Sobreajuste

En estadística, el sobreajuste es "la producción de un análisis que se corresponde demasiado cerca o exactamente con un conjunto particular de datos y, por lo tanto, puede fallar en ajustar datos adicionales o predecir observaciones futuras de manera confiable". [1] Un modelo sobreajustado es un modelo estadístico que contiene más parámetros de los que los datos pueden justificar. [2] La esencia del sobreajuste es haber extraído sin saberlo parte de la variación residual (es decir, el ruido ) como si esa variación representara la estructura del modelo subyacente. [3] : 45

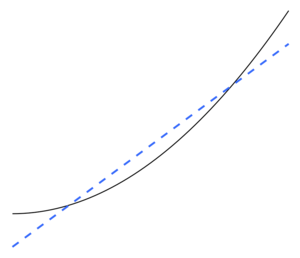

El desajuste ocurre cuando un modelo estadístico no puede capturar adecuadamente la estructura subyacente de los datos. Un modelo no ajustado es un modelo en el que faltan algunos parámetros o términos que aparecerían en un modelo correctamente especificado. [2] Se produciría un ajuste insuficiente, por ejemplo, al ajustar un modelo lineal a datos no lineales. Tal modelo tenderá a tener un rendimiento predictivo deficiente.

Existe la posibilidad de un ajuste excesivo porque el criterio utilizado para seleccionar el modelo no es el mismo que el utilizado para juzgar la idoneidad de un modelo. Por ejemplo, un modelo podría seleccionarse maximizando su rendimiento en algún conjunto de datos de entrenamiento y, sin embargo, su idoneidad podría estar determinada por su capacidad para funcionar bien en datos invisibles; luego, el ajuste excesivo ocurre cuando un modelo comienza a "memorizar" datos de entrenamiento en lugar de "aprender" a generalizar a partir de una tendencia.

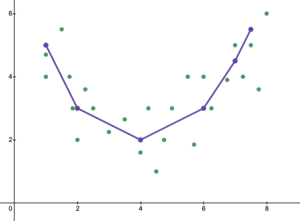

Como ejemplo extremo, si el número de parámetros es igual o mayor que el número de observaciones, entonces un modelo puede predecir perfectamente los datos de entrenamiento simplemente memorizando los datos en su totalidad. (Para ver una ilustración, consulte la Figura 2). Sin embargo, este modelo normalmente fallará gravemente al hacer predicciones.

El potencial de sobreajuste depende no solo del número de parámetros y datos, sino también de la adaptabilidad de la estructura del modelo a la forma de los datos y de la magnitud del error del modelo en comparación con el nivel esperado de ruido o error en los datos. [ cita requerida ] Incluso cuando el modelo ajustado no tiene un número excesivo de parámetros, es de esperar que la relación ajustada parezca funcionar menos bien en un nuevo conjunto de datos que en el conjunto de datos utilizado para el ajuste (un fenómeno a veces conocido como contracción ). [2] En particular, el valor del coeficiente de determinación se reducirá en relación con los datos originales.

Para disminuir la posibilidad o la cantidad de sobreajuste, se encuentran disponibles varias técnicas (por ejemplo, comparación de modelos , validación cruzada , regularización , detención temprana , poda , priores bayesianos o abandono ). La base de algunas técnicas es (1) penalizar explícitamente los modelos demasiado complejos o (2) probar la capacidad del modelo para generalizar mediante la evaluación de su desempeño en un conjunto de datos que no se utilizan para el entrenamiento, que se supone que se aproxima a los datos típicos que no se ven. que encontrará un modelo.