En el almacenamiento informático , los niveles RAID estándar comprenden un conjunto básico de configuraciones RAID (" Matriz redundante de discos independientes " o " Matriz redundante de discos económicos ") que emplean las técnicas de creación de bandas , duplicación o paridad para crear grandes almacenes de datos fiables a partir de múltiples unidades de disco duro (HDD) de computadora de uso general . Los tipos más comunes son RAID 0 (creación de bandas), RAID 1 (duplicación) y sus variantes, RAID 5 (paridad distribuida) y RAID 6 (paridad dual). También se pueden combinar o anidar varios niveles de RAID, por ejemplo, RAID 10 (creación de bandas de espejos) o RAID 01 (conjuntos de bandas de duplicación). Los niveles RAID y sus formatos de datos asociados están estandarizados por la Storage Networking Industry Association (SNIA) en el estándar Common RAID Disk Drive Format (DDF). [1] Los valores numéricos solo sirven como identificadores y no significan rendimiento, confiabilidad, generación o cualquier otra métrica.

Si bien la mayoría de los niveles de RAID pueden brindar una buena protección y recuperación de defectos de hardware o sectores defectuosos / errores de lectura ( errores de hardware ), no brindan ninguna protección contra la pérdida de datos debido a fallas catastróficas (fuego, agua) o errores leves como errores de usuario , mal funcionamiento del software o infección de malware. Para datos valiosos, RAID es solo un componente de un esquema de recuperación y prevención de pérdida de datos más grande; no puede reemplazar un plan de respaldo .

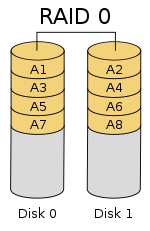

RAID 0 [ editar ]

RAID 0 (también conocido como conjunto de bandas o volumen seccionado ) divide (" bandas ") los datos de manera uniforme en dos o más discos, sin información de paridad , redundancia o tolerancia a fallas . Dado que RAID 0 no proporciona tolerancia a fallas ni redundancia, la falla de una unidad hará que falle todo el arreglo; como resultado de tener datos seccionados en todos los discos, la falla resultará en una pérdida total de datos. Esta configuración se implementa típicamente teniendo la velocidad como objetivo previsto. [2] [3] RAID 0 se utiliza normalmente para aumentar el rendimiento, aunque también se puede utilizar como una forma de crear un gran volumen lógico a partir de dos o más discos físicos.[4]

Se puede crear una configuración RAID 0 con discos de diferentes tamaños, pero el espacio de almacenamiento agregado a la matriz por cada disco está limitado al tamaño del disco más pequeño. Por ejemplo, si un disco de 120 GB está seccionado junto con un disco de 320 GB, el tamaño de la matriz será 120 GB × 2 = 240 GB. Sin embargo, algunas implementaciones de RAID permiten que los 200 GB restantes se utilicen para otros fines.

El diagrama de esta sección muestra cómo se distribuyen los datos en franjas A x en dos discos, con A1: A2 como la primera franja, A3: A4 como la segunda, etc. Una vez que se define el tamaño de la franja durante la creación de un RAID 0, debe mantenerse en todo momento. Dado que se accede a las bandas en paralelo, una matriz RAID 0 de n unidades aparece como un solo disco grande con una velocidad de datos n veces mayor que la velocidad de un solo disco.

Rendimiento [ editar ]

Una matriz RAID 0 de n unidades proporciona velocidades de transferencia de lectura y escritura de datos hasta n veces más altas que las velocidades de las unidades individuales, pero sin redundancia de datos. Como resultado, RAID 0 se usa principalmente en aplicaciones que requieren un alto rendimiento y pueden tolerar una menor confiabilidad, como en la informática científica [5] o los juegos de computadora . [6]

Algunas pruebas de rendimiento de las aplicaciones de escritorio muestran que el rendimiento de RAID 0 es ligeramente mejor que el de una sola unidad. [7] [8] Otro artículo examinó estas afirmaciones y concluyó que "la creación de bandas no siempre aumenta el rendimiento (en ciertas situaciones, en realidad será más lento que una configuración sin RAID), pero en la mayoría de las situaciones producirá una mejora significativa en el rendimiento ". [9] [10] Los puntos de referencia sintéticos muestran diferentes niveles de mejoras de rendimiento cuando se utilizan varios HDD o SSD en una configuración RAID 0, en comparación con el rendimiento de una sola unidad. Sin embargo, algunos puntos de referencia sintéticos también muestran una caída en el rendimiento para la misma comparación. [11] [12]

RAID 1 [ editar ]

RAID 1 consiste en una copia exacta (o espejo ) de un conjunto de datos en dos o más discos; un par duplicado RAID 1 clásico contiene dos discos. Esta configuración no ofrece paridad, división o expansión del espacio de disco en varios discos, ya que los datos se reflejan en todos los discos que pertenecen a la matriz y la matriz solo puede ser tan grande como el disco miembro más pequeño. Este diseño es útil cuando el rendimiento de lectura o la confiabilidad es más importante que el rendimiento de escritura o la capacidad de almacenamiento de datos resultante. [13] [14]

La matriz seguirá funcionando mientras al menos una unidad miembro esté operativa. [15]

Rendimiento [ editar ]

Any read request can be serviced and handled by any drive in the array; thus, depending on the nature of I/O load, random read performance of a RAID 1 array may equal up to the sum of each member's performance,[a] while the write performance remains at the level of a single disk. However, if disks with different speeds are used in a RAID 1 array, overall write performance is equal to the speed of the slowest disk.[14][15]

Synthetic benchmarks show varying levels of performance improvements when multiple HDDs or SSDs are used in a RAID 1 setup, compared with single-drive performance. However, some synthetic benchmarks also show a drop in performance for the same comparison.[11][12]

RAID 2[edit]

RAID 2 , que rara vez se usa en la práctica, divide los datos a nivel de bit (en lugar de bloque) y usa un código Hamming para la corrección de errores . El controlador sincroniza los discos para que giren en la misma orientación angular (alcanzan el índice al mismo tiempo [16] ), por lo que generalmente no puede atender múltiples solicitudes simultáneamente. [17] [18] Sin embargo, dependiendo de un código Hamming de alta velocidad , muchos ejes funcionarían en paralelo para transferir datos simultáneamente, de modo que son posibles "velocidades de transferencia de datos muy altas" [19] como, por ejemplo, en DataVault donde 32 bits de datos fueron transmitidos simultáneamente.

Con todas las unidades de disco duro implementando la corrección de errores internos, la complejidad de un código Hamming externo ofrecía pocas ventajas sobre la paridad, por lo que RAID 2 rara vez se ha implementado; es el único nivel original de RAID que no se utiliza actualmente. [17] [18]

RAID 3 [ editar ]

RAID 3, which is rarely used in practice, consists of byte-level striping with a dedicated parity disk. One of the characteristics of RAID 3 is that it generally cannot service multiple requests simultaneously, which happens because any single block of data will, by definition, be spread across all members of the set and will reside in the same physical location on each disk. Therefore, any I/O operation requires activity on every disk and usually requires synchronized spindles.

Esto lo hace adecuado para aplicaciones que exigen las tasas de transferencia más altas en lecturas y escrituras secuenciales largas, por ejemplo, edición de video sin comprimir . Las aplicaciones que realizan lecturas y escrituras pequeñas desde ubicaciones de disco aleatorias obtendrán el peor rendimiento de este nivel. [18]

El requisito de que todos los discos giraran sincrónicamente (al mismo tiempo ) agregó consideraciones de diseño que no proporcionaron ventajas significativas sobre otros niveles de RAID. Tanto RAID 3 como RAID 4 fueron rápidamente reemplazados por RAID 5. [20] RAID 3 generalmente se implementaba en hardware, y los problemas de rendimiento se abordaban mediante el uso de cachés de disco grandes. [18]

RAID 4 [ editar ]

RAID 4 consta de bandas a nivel de bloque con un disco de paridad dedicado . Como resultado de su diseño, RAID 4 proporciona un buen rendimiento de lecturas aleatorias, mientras que el rendimiento de las escrituras aleatorias es bajo debido a la necesidad de escribir todos los datos de paridad en un solo disco, [21] al menos mientras el sistema de archivos no lo esté RAID 4 consciente y lo compensa.

Una ventaja de RAID 4 es que se puede ampliar rápidamente en línea, sin volver a calcular la paridad, siempre que los discos recién agregados estén completamente llenos de 0 bytes.

En el diagrama 1, una solicitud de lectura para el bloque A1 sería atendida por el disco 0. Una solicitud de lectura simultánea para el bloque B1 tendría que esperar, pero una solicitud de lectura para B2 podría ser atendida simultáneamente por el disco 1.

RAID 5 [ editar ]

RAID 5 consta de bandas a nivel de bloque con paridad distribuida. A diferencia de RAID 4, la información de paridad se distribuye entre las unidades. Requiere que todas las unidades menos una estén presentes para funcionar. En caso de falla de una sola unidad, las lecturas posteriores se pueden calcular a partir de la paridad distribuida de manera que no se pierdan datos. [5] RAID 5 requiere al menos tres discos. [22]

Hay muchos diseños de datos y paridad en una matriz de unidades de disco RAID 5 dependiendo de la secuencia de escritura en los discos, [23] es decir:

- la secuencia de bloques de datos escritos, de izquierda a derecha o de derecha a izquierda en la matriz de discos, de los discos 0 a N, y

- la ubicación del bloque de paridad al principio o al final de la franja, y

- la ubicación del primer bloque de una franja con respecto a la paridad de la franja anterior.

La figura de la derecha muestra 1) bloques de datos escritos de izquierda a derecha, 2) el bloque de paridad al final de la banda y 3) el primer bloque de la siguiente banda que no está en el mismo disco que el bloque de paridad de la banda anterior. Se puede designar como un diseño RAID 5 asíncrono izquierdo [23] y este es el único diseño identificado en la última edición de The Raid Book [24] publicado por el desaparecido Raid Advisory Board. [25] En un diseño síncrono , el primer bloque de datos de la siguiente banda se escribe en la misma unidad que el bloque de paridad de la banda anterior.

En comparación con RAID 4, la paridad distribuida de RAID 5 equilibra el estrés de un disco de paridad dedicado entre todos los miembros de RAID. Además, el rendimiento de escritura aumenta ya que todos los miembros de RAID participan en el servicio de solicitudes de escritura. Aunque no será tan eficiente como una configuración de bandas (RAID 0), debido a que la paridad aún debe escribirse, esto ya no es un cuello de botella. [26]

Dado que el cálculo de paridad se realiza en la franja completa, los pequeños cambios en la matriz experimentan amplificación de escritura [ cita requerida ] : en el peor de los casos, cuando se va a escribir un solo sector lógico, es necesario leer el sector original y el sector de paridad correspondiente , los datos originales se eliminan de la paridad, los nuevos datos se calculan en la paridad y se escriben tanto el nuevo sector de datos como el nuevo sector de paridad.

RAID 6 [ editar ]

RAID 6 amplía RAID 5 agregando otro bloque de paridad ; por lo tanto, utiliza bandas a nivel de bloque con dos bloques de paridad distribuidos en todos los discos miembros. [27]

Al igual que en RAID 5, hay muchos diseños de matrices de discos RAID 6 dependiendo de la dirección en la que se escriben los bloques de datos, la ubicación de los bloques de paridad con respecto a los bloques de datos y si se escribe o no el primer bloque de datos de una franja posterior. a la misma unidad que el último bloque de paridad de la banda anterior. La figura de la derecha es solo uno de muchos de estos diseños.

Según la Storage Networking Industry Association (SNIA), la definición de RAID 6 es: "Cualquier forma de RAID que pueda continuar ejecutando solicitudes de lectura y escritura en todos los discos virtuales de una matriz RAID en presencia de dos fallas de disco concurrentes. Se han utilizado varios métodos, incluidos los cálculos de datos de verificación dual (paridad y Reed-Solomon ), los datos de verificación de paridad dual ortogonal y la paridad diagonal, para implementar el nivel 6 de RAID ". [28]

Rendimiento [ editar ]

RAID 6 no tiene una penalización de rendimiento para las operaciones de lectura, pero sí tiene una penalización de rendimiento en las operaciones de escritura debido a la sobrecarga asociada con los cálculos de paridad. El rendimiento varía mucho según cómo se implemente RAID 6 en la arquitectura de almacenamiento del fabricante: en software, firmware o mediante el uso de firmware y ASIC especializados para cálculos de paridad intensivos. RAID 6 puede leer hasta la misma velocidad que RAID 5 con el mismo número de unidades físicas. [29]

Cuando se utiliza paridad dual diagonal u ortogonal, es necesario un segundo cálculo de paridad para las operaciones de escritura. Esto duplica la sobrecarga de la CPU para escrituras RAID-6, en comparación con los niveles RAID de paridad única. Cuando se utiliza un código Reed Solomon, el segundo cálculo de paridad es innecesario. Reed Solomon tiene la ventaja de permitir que toda la información de redundancia esté contenida dentro de una franja determinada.

Ejemplo de paridad simplificado [ editar ]

Suppose we would like to distribute our data over chunks. Our goal is to define two parity values and , known as syndromes, resulting in a system of physical drives that is resilient to the loss of any two of them. In order to generate more than a single independent syndrome, we will need to perform our parity calculations on data chunks of size A typical choice in practice is a chunk size , i.e. striping the data per-byte. We will denote the base-2 representation of a data chunk as , where each is either 0 or 1.

Si usamos una pequeña cantidad de fragmentos , podemos usar un cálculo de paridad simple, que ayudará a motivar el uso del sistema Reed-Solomon en el caso general. Para nuestro primer valor de paridad , calculamos el XOR simple de los datos en las franjas, como con RAID 5. Esto está escrito

y recupere los datos perdidos deshaciendo el cambio de bits. También podemos recuperarnos de la falla de dos discos de datos calculando el XOR de y con los datos restantes. Si en el ejemplo anterior también se hubiera perdido un fragmento , calcularíamos

Este sistema ya no funcionará si se aplica a un mayor número de unidades . Esto se debe a que si aplicamos repetidamente los tiempos del operador de turno a una parte de la longitud , terminamos de nuevo donde comenzamos. Si intentáramos aplicar el algoritmo anterior a un sistema que contiene discos de datos, el lado derecho de la segunda ecuación sería , que es el mismo que el primer conjunto de ecuaciones. Esto solo produciría la mitad de las ecuaciones necesarias para resolver los valores faltantes.

Sistema de paridad general [ editar ]

Es posible admitir un número mucho mayor de unidades eligiendo la función de paridad con más cuidado. El problema al que nos enfrentamos es asegurarnos de que un sistema de ecuaciones sobre el campo finito tenga una solución única, por lo que pasaremos a la teoría de ecuaciones polinomiales. Considere el campo de Galois con . Este campo es isomorfo a un campo polinomial para un polinomio irreducible adecuado de grado superior . Representaremos los elementos de datos como polinomios en el campo de Galois. Deje corresponder a las franjas de datos en los discos duros codificados como elementos de campo de esta manera. Usaremos para denotar la suma en el campo y la concatenación para denotar la multiplicación. La reutilización de es intencional: esto se debe a que la suma en el campo finito representa al operador XOR, por lo que calcular la suma de dos elementos es equivalente a calcular XOR en los coeficientes del polinomio.

Un generador de un campo es un elemento del campo que es diferente para cada no negativo . Esto significa que cada elemento del campo, excepto el valor , se puede escribir como una potencia de. Se garantiza que un campo finito tiene al menos un generador. Elija uno de esos generadores y defina y de la siguiente manera:

As before, the first checksum is just the XOR of each stripe, though interpreted now as a polynomial. The effect of can be thought of as the action of a carefully chosen linear feedback shift register on the data chunk.[30] Unlike the bit shift in the simplified example, which could only be applied times before the encoding began to repeat, applying the operator multiple times is guaranteed to produce unique invertible functions, which will allow a chunk length of to support up to data pieces.

If one data chunk is lost, the situation is similar to the one before. In the case of two lost data chunks, we can compute the recovery formulas algebraically. Suppose that and are the lost values with , then, using the other values of , we find constants and :

We can solve for in the second equation and plug it into the first to find , and then .

Unlike P, The computation of Q is relatively CPU intensive, as it involves polynomial multiplication in . This can be mitigated with a hardware implementation or by using an FPGA.

Comparison[edit]

This section needs additional citations for verification. (January 2015) (Learn how and when to remove this template message) |

The following table provides an overview of some considerations for standard RAID levels. In each case:

- Array space efficiency is given as an expression in terms of the number of drives, n; this expression designates a fractional value between zero and one, representing the fraction of the sum of the drives' capacities that is available for use. For example, if three drives are arranged in RAID 3, this gives an array space efficiency of 1 − 1/n = 1 − 1/3 = 2/3 ≈ 67%; thus, if each drive in this example has a capacity of 250 GB, then the array has a total capacity of 750 GB but the capacity that is usable for data storage is only 500 GB.

| Level | Description | Minimum number of drives[b] | Space efficiency | Fault tolerance | Read performance | Write performance |

|---|---|---|---|---|---|---|

| as factor of single disk | ||||||

| RAID 0 | Block-level striping without parity or mirroring | 2 | 1 | None | n | n |

| RAID 1 | Mirroring without parity or striping | 2 | 1/n | n − 1 drive failures | n[a][15] | 1[c][15] |

| RAID 2 | Bit-level striping with Hamming code for error correction | 3 | 1 − 1/n log2 (n + 1) | One drive failure[d] | Depends | Depends |

| RAID 3 | Byte-level striping with dedicated parity | 3 | 1 − 1/n | One drive failure | n − 1 | n − 1[e] |

| RAID 4 | Block-level striping with dedicated parity | 3 | 1 − 1/n | One drive failure | n − 1 | n − 1[e][citation needed] |

| RAID 5 | Block-level striping with distributed parity | 3 | 1 − 1/n | One drive failure | n[e] | single sector: 1/4 full stripe: n − 1[e][citation needed] |

| RAID 6 | Block-level striping with double distributed parity | 4 | 1 − 2/n | Two drive failures | n[e] | single sector: 1/6 full stripe: n − 2[e][citation needed] |

System implications[edit]

In measurement of the I/O performance of five filesystems with five storage configurations—single SSD, RAID 0, RAID 1, RAID 10, and RAID 5 it was shown that F2FS on RAID 0 and RAID 5 with eight SSDs outperforms EXT4 by 5 times and 50 times, respectively. The measurements also suggest that the RAID controller can be a significant bottleneck in building a RAID system with high speed SSDs.[31]

Nested RAID[edit]

Combinations of two or more standard RAID levels. They are also known as RAID 0+1 or RAID 01, RAID 0+3 or RAID 03, RAID 1+0 or RAID 10, RAID 5+0 or RAID 50, RAID 6+0 or RAID 60, and RAID 10+0 or RAID 100.

Non-standard variants[edit]

In addition to standard and nested RAID levels, alternatives include non-standard RAID levels, and non-RAID drive architectures. Non-RAID drive architectures are referred to by similar terms and acronyms, notably JBOD ("just a bunch of disks"), SPAN/BIG, and MAID ("massive array of idle disks").

Notes[edit]

- ^ a b Theoretical maximum, as low as single-disk performance in practice

- ^ Assumes a non-degenerate minimum number of drives

- ^ If disks with different speeds are used in a RAID 1 array, overall write performance is equal to the speed of the slowest disk.

- ^ RAID 2 can recover from one drive failure or repair corrupt data or parity when a corrupted bit's corresponding data and parity are good.

- ^ a b c d e f Assumes hardware capable of performing associated calculations fast enough

References[edit]

- ^ "Common raid Disk Data Format (DDF)". SNIA.org. Storage Networking Industry Association. Retrieved 2013-04-23.

- ^ "RAID 0 Data Recovery". DataRecovery.net. Retrieved 2015-04-30.

- ^ "Understanding RAID". CRU-Inc.com. Retrieved 2015-04-30.

- ^ "How to Combine Multiple Hard Drives Into One Volume for Cheap, High-Capacity Storage". LifeHacker.com. 2013-02-26. Retrieved 2015-04-30.

- ^ a b Chen, Peter; Lee, Edward; Gibson, Garth; Katz, Randy; Patterson, David (1994). "RAID: High-Performance, Reliable Secondary Storage". ACM Computing Surveys. 26 (2): 145–185. CiteSeerX 10.1.1.41.3889. doi:10.1145/176979.176981. S2CID 207178693.

- ^ de Kooter, Sebastiaan (2015-04-13). "Gaming storage shootout 2015: SSD, HDD or RAID 0, which is best?". GamePlayInside.com. Retrieved 2015-09-22.

- ^ "Western Digital's Raptors in RAID-0: Are two drives better than one?". AnandTech.com. AnandTech. July 1, 2004. Retrieved 2007-11-24.

- ^ "Hitachi Deskstar 7K1000: Two Terabyte RAID Redux". AnandTech.com. AnandTech. April 23, 2007. Retrieved 2007-11-24.

- ^ "RAID 0: Hype or blessing?". Tweakers.net. Persgroep Online Services. August 7, 2004. Retrieved 2008-07-23.

- ^ "Does RAID0 Really Increase Disk Performance?". HardwareSecrets.com. November 1, 2006.

- ^ a b Larabel, Michael (2014-10-22). "Btrfs RAID HDD Testing on Ubuntu Linux 14.10". Phoronix. Retrieved 2015-09-19.

- ^ a b Larabel, Michael (2014-10-29). "Btrfs on 4 × Intel SSDs In RAID 0/1/5/6/10". Phoronix. Retrieved 2015-09-19.

- ^ "FreeBSD Handbook: 19.3. RAID 1 – Mirroring". FreeBSD.org. 2014-03-23. Retrieved 2014-06-11.

- ^ a b "Which RAID Level is Right for Me?: RAID 1 (Mirroring)". Adaptec.com. Adaptec. Retrieved 2014-01-02.

- ^ a b c d "Selecting the Best RAID Level: RAID 1 Arrays (Sun StorageTek SAS RAID HBA Installation Guide)". Docs.Oracle.com. Oracle Corporation. 2010-12-23. Retrieved 2014-01-02.

- ^ "RAID 2". Techopedia. Techopedia. Retrieved 11 December 2019.

- ^ a b Vadala, Derek (2003). Managing RAID on Linux. O'Reilly Series (illustrated ed.). O'Reilly. p. 6. ISBN 9781565927308.

- ^ a b c d Marcus, Evan; Stern, Hal (2003). Blueprints for high availability (2, illustrated ed.). John Wiley and Sons. p. 167. ISBN 9780471430261.

- ^ The RAIDbook, 4th Edition, The RAID Advisory Board, June 1995, p.101

- ^ Meyers, Michael; Jernigan, Scott (2003). Mike Meyers' A+ Guide to Managing and Troubleshooting PCs (illustrated ed.). McGraw-Hill Professional. p. 321. ISBN 9780072231465.

- ^ Natarajan, Ramesh (2011-11-21). "RAID 2, RAID 3, RAID 4 and RAID 6 Explained with Diagrams". TheGeekStuff.com. Retrieved 2015-01-02.

- ^ "RAID 5 Data Recovery FAQ". VantageTech.com. Vantage Technologies. Retrieved 2014-07-16.

- ^ a b "RAID Information - Linux RAID-5 Algorithms". Ashford computer Consulting Service. Retrieved February 16, 2021.

- ^ Massigilia, Paul (February 1997). The RAID Book, 6th Edition. RAID Advisory Board. pp. 101–129.

- ^ "Welcome to the RAID Advisory Board". RAID Advisory Board. April 6, 2001. Retrieved February 16, 2021. Last valid archived webpage at Wayback Machine}}

- ^ Koren, Israel. "Basic RAID Organizations". ECS.UMass.edu. University of Massachusetts. Retrieved 2014-11-04.

- ^ "Sun StorageTek SAS RAID HBA Installation Guide, Appendix F: Selecting the Best RAID Level: RAID 6 Arrays". Docs.Oracle.com. 2010-12-23. Retrieved 2015-08-27.

- ^ "Dictionary R". SNIA.org. Storage Networking Industry Association. Retrieved 2007-11-24.

- ^ Faith, Rickard E. (13 May 2009). "A Comparison of Software RAID Types". Cite journal requires

|journal=(help) - ^ Anvin, H. Peter (May 21, 2009). "The Mathematics of RAID-6" (PDF). Kernel.org. Linux Kernel Organization. Retrieved November 4, 2009.

- ^ Park, Chanhyun; Lee, Seongjin; Won, Youjip (2014). An Analysis on Empirical Performance of SSD-Based RAID. Information Sciences and Systems. 2014. pp. 395–405. doi:10.1007/978-3-319-09465-6_41. ISBN 978-3-319-09464-9.

Further reading[edit]

- "Learning About RAID". Support.Dell.com. Dell. 2009. Archived from the original on 2009-02-20. Retrieved 2016-04-15.

- Redundant Arrays of Inexpensive Disks (RAIDs), chapter 38 from the Operating Systems: Three Easy Pieces book by Remzi H. Arpaci-Dusseau and Andrea C. Arpaci-Dusseau

External links[edit]

- IBM summary on RAID levels

- RAID 5 parity explanation and checking tool

- RAID Calculator for Standard RAID Levels and Other RAID Tools

- Sun StorEdge 3000 Family Configuration Service 2.5 User’s Guide: RAID Basics

![{\displaystyle F_{2}[x]/(p(x))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5a94539f2b3a0114d3e0d1f244a9a4a657b0995d)