Red neuronal residual

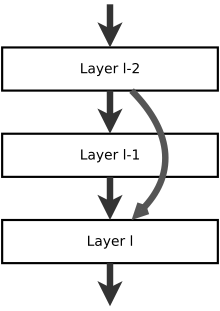

Una red neuronal residual ( ResNet ) es una red neuronal artificial (ANN) de un tipo que se basa en construcciones conocidas de células piramidales en la corteza cerebral . Las redes neuronales residuales hacen esto mediante el uso de conexiones de salto o atajos para saltar sobre algunas capas. Los modelos típicos de ResNet se implementan con saltos de doble o triple capa que contienen no linealidades ( ReLU ) y normalización de lotes en el medio. [1] Se puede usar una matriz de peso adicional para aprender los pesos de salto; estos modelos se conocen como HighwayNets . [2]Los modelos con varios saltos paralelos se denominan DenseNets . [3] En el contexto de las redes neuronales residuales, una red no residual puede describirse como una red simple .

Hay dos razones principales para agregar conexiones de omisión: para evitar el problema de los gradientes que desaparecen o para mitigar el problema de Degradación (saturación de precisión); donde agregar más capas a un modelo adecuadamente profundo conduce a un mayor error de entrenamiento. [1] Durante el entrenamiento, los pesos se adaptan para silenciar la capa ascendente [ aclaración necesaria ] y amplificar la capa previamente omitida. En el caso más simple, solo se adaptan los pesos para la conexión de la capa adyacente, sin pesos explícitos para la capa aguas arriba. Esto funciona mejor cuando se pasa por encima de una sola capa no lineal o cuando las capas intermedias son todas lineales. De lo contrario, se debe aprender una matriz de peso explícita para la conexión omitida (un HighwayNet debería ser usado).

Omitir simplifica la red de forma eficaz, utilizando menos capas en las etapas iniciales de formación [ aclaración necesaria ] . Esto acelera el aprendizaje al reducir el impacto de los gradientes que desaparecen, ya que hay menos capas por las que propagarse. Luego, la red restaura gradualmente las capas omitidas a medida que aprende el espacio de características . Hacia el final del entrenamiento, cuando se expanden todas las capas, permanece más cerca de la variedad [ aclaración necesaria ] y, por lo tanto, aprende más rápido. Una red neuronal sin partes residuales explora más el espacio de características. Esto lo hace más vulnerable a las perturbaciones que hacen que salga del colector y necesita datos de entrenamiento adicionales para recuperarse.

El cerebro tiene estructuras similares a las redes residuales, ya que las neuronas de la capa VI cortical reciben información de la capa I, saltando las capas intermedias. [4] En la figura, esto se compara con las señales de la dendrita apical (3) saltando capas, mientras que la dendrita basal (2) recopila señales de la capa anterior y / o la misma. [nota 1] [5] Existen estructuras similares para otras capas. [6] No está claro cuántas capas de la corteza cerebral se comparan con las capas de una red neuronal artificial, ni si todas las áreas de la corteza cerebralexhibe la misma estructura, pero en grandes áreas parecen similares. No hay evidencia de que ocurra algo parecido a la retropropagación en el cerebro y la existencia de una “señal de enseñanza” global u optimización iterativa en el cerebro animal no está respaldada por evidencia neurofisiológica.

Dada una matriz de pesos para los pesos de conexión de la capa a , y una matriz de pesos para los pesos de conexión de la capa a , entonces la propagación hacia adelante a través de la función de activación sería (también conocida como HighwayNets )