Estimación de la densidad de kernel

En estadística , la estimación de la densidad del kernel ( KDE ) es una forma no paramétrica de estimar la función de densidad de probabilidad de una variable aleatoria . La estimación de la densidad de kernel es un problema fundamental de suavizado de datos donde se hacen inferencias sobre la población , basadas en una muestra de datos finitos . En algunos campos, como el procesamiento de señales y la econometría , también se denomina método de ventana de Parzen-Rosenblatt , en honor a Emanuel Parzen y Murray Rosenblatt., a quienes generalmente se les atribuye haberlo creado de forma independiente en su forma actual. [1] [2] Una de las aplicaciones más famosas de la estimación de la densidad del kernel es estimar las densidades marginales condicionales de clase de los datos cuando se usa un clasificador Bayes ingenuo , [3] [4] que puede mejorar su precisión de predicción. [3]

Sea ( x 1 , x 2 , ..., x n ) muestras independientes e idénticamente distribuidas extraídas de alguna distribución univariante con una densidad desconocida f en cualquier punto x dado . Estamos interesados en estimar la forma de esta función f . Su estimador de densidad de kernel es

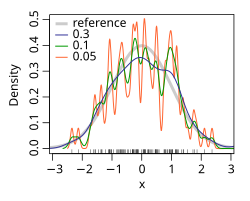

donde K es el kernel , una función no negativa, y h > 0 es un parámetro de suavizado llamado ancho de banda. Un kernel con el subíndice h se denomina kernel escalado y se define como K h ( x ) = 1 / h K ( x / h ) . Intuitivamente, uno quiere elegir h tan pequeño como lo permitan los datos; sin embargo, siempre existe una compensación entre el sesgo del estimador y su varianza. La elección del ancho de banda se analiza con más detalle a continuación.

Se utiliza comúnmente una variedad de funciones del kernel : uniforme, triangular, biweight, triweight, Epanechnikov, normal y otras. El núcleo de Epanechnikov es óptimo en un sentido de error cuadrático medio, [5] aunque la pérdida de eficiencia es pequeña para los núcleos enumerados anteriormente. [6] Debido a sus convenientes propiedades matemáticas, a menudo se usa el núcleo normal, lo que significa que K ( x ) = ϕ ( x ) , donde ϕ es la función de densidad normal estándar .

La construcción de una estimación de densidad de kernel encuentra interpretaciones en campos fuera de la estimación de densidad. [7] Por ejemplo, en termodinámica , esto es equivalente a la cantidad de calor generado cuando los granos de calor (la solución fundamental de la ecuación de calor ) se colocan en las ubicaciones de cada punto de datos x i . Se utilizan métodos similares para construir operadores de Laplace discretos en nubes de puntos para el aprendizaje múltiple (por ejemplo, mapa de difusión ).

Las estimaciones de densidad de kernel están estrechamente relacionadas con los histogramas , pero se pueden dotar de propiedades como suavidad o continuidad mediante el uso de un kernel adecuado. El siguiente diagrama basado en estos 6 puntos de datos ilustra esta relación: