Análisis de variación

El análisis de varianza ( ANOVA ) es una colección de modelos estadísticos y sus procedimientos de estimación asociados (como la "variación" entre grupos) que se utiliza para analizar las diferencias entre medias. ANOVA fue desarrollado por el estadístico Ronald Fisher . ANOVA se basa en la ley de la varianza total , donde la varianza observada en una variable particular se divide en componentes atribuibles a diferentes fuentes de variación. En su forma más simple, ANOVA proporciona una prueba estadística de si dos o más medias poblacionales son iguales y, por lo tanto, generaliza la prueba t.más allá de dos medios. En otras palabras, el ANOVA se usa para probar la diferencia entre dos o más medias.

Si bien el análisis de la varianza llegó a buen término en el siglo XX, los antecedentes se remontan siglos atrás, según Stigler. [1] Estos incluyen la prueba de hipótesis, la partición de sumas de cuadrados, técnicas experimentales y el modelo aditivo. Laplace estaba realizando pruebas de hipótesis en la década de 1770. [2] Alrededor de 1800, Laplace y Gauss desarrollaron el método de mínimos cuadrados para combinar observaciones, que mejoró los métodos que se usaban entonces en astronomía y geodesia. También inició mucho estudio de las contribuciones a las sumas de cuadrados. Laplace sabía cómo estimar una varianza a partir de una suma de cuadrados residual (en lugar de un total). [3] Para 1827, Laplace estaba usando mínimos cuadradosmétodos para abordar los problemas de ANOVA con respecto a las mediciones de las mareas atmosféricas. [4] Antes de 1800, los astrónomos habían aislado errores de observación resultantes de los tiempos de reacción (la " ecuación personal ") y habían desarrollado métodos para reducir los errores. [5] Los métodos experimentales utilizados en el estudio de la ecuación personal fueron posteriormente aceptados por el campo emergente de la psicología [6] que desarrolló métodos experimentales fuertes (factorial completo) a los que pronto se agregaron la aleatorización y el cegamiento. [7] Una elocuente explicación no matemática del modelo de efectos aditivos estaba disponible en 1885. [8]

Ronald Fisher introdujo el término varianza y propuso su análisis formal en un artículo de 1918 La correlación entre parientes sobre la suposición de la herencia mendeliana . [9] Su primera aplicación del análisis de varianza se publicó en 1921. [10] El análisis de varianza se hizo ampliamente conocido después de ser incluido en el libro de Fisher de 1925 Métodos estadísticos para investigadores .

Varios investigadores desarrollaron modelos de aleatorización. El primero fue publicado en polaco por Jerzy Neyman en 1923. [11]

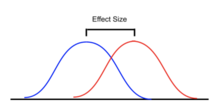

El análisis de varianza se puede utilizar para describir relaciones complejas entre variables. Una exposición canina proporciona un ejemplo. Una exposición canina no es una muestra aleatoria de la raza: generalmente se limita a perros adultos, de raza pura y ejemplares. Es plausible que un histograma de pesos de perros de un espectáculo sea bastante complejo, como la distribución amarillo-naranja que se muestra en las ilustraciones. Supongamos que quisiéramos predecir el peso de un perro en función de un determinado conjunto de características de cada perro. Una forma de hacerlo es explicarla distribución de pesos dividiendo la población de perros en grupos basados en esas características. Un agrupamiento exitoso dividirá a los perros de tal manera que (a) cada grupo tenga una varianza baja en el peso de los perros (lo que significa que el grupo es relativamente homogéneo) y (b) la media de cada grupo sea distinta (si dos grupos tienen la misma media, entonces no es razonable concluir que los grupos están, de hecho, separados de manera significativa).