Ejemplos de cadenas de Markov

Este artículo contiene ejemplos de cadenas de Markov y procesos de Markov en acción.

Todos los ejemplos están en el espacio de estado contable . Para obtener una descripción general de las cadenas de Markov en el espacio de estado general, consulte Cadenas de Markov en un espacio de estado medible .

Tiempo discreto

Juegos de mesa con dados

Un juego de serpientes y escaleras o cualquier otro juego cuyos movimientos estén determinados enteramente por los dados es una cadena de Markov, de hecho, una cadena de Markov absorbente . Esto contrasta con los juegos de cartas como el blackjack., donde las cartas representan un "recuerdo" de los movimientos pasados. Para ver la diferencia, considere la probabilidad de un determinado evento en el juego. En los juegos de dados mencionados anteriormente, lo único que importa es el estado actual del tablero. El siguiente estado del tablero depende del estado actual y del próximo lanzamiento de los dados. No depende de cómo las cosas llegaron a su estado actual. En un juego como el blackjack, un jugador puede obtener una ventaja recordando qué cartas ya se han mostrado (y, por lo tanto, qué cartas ya no están en la baraja), por lo que el siguiente estado (o mano) del juego no es independiente de la Estados pasados.

Cadenas de Markov de paseo aleatorio

Un paseo aleatorio con sesgo central

Considere un paseo aleatorio en la recta numérica donde, en cada paso, la posición (llámelo x ) puede cambiar en +1 (a la derecha) o -1 (a la izquierda) con probabilidades:

(donde c es una constante mayor que 0)

Por ejemplo, si la constante, c , es igual a 1, las probabilidades de un movimiento hacia la izquierda en las posiciones x = −2, −1,0,1,2 vienen dadas por respectivamente. La caminata aleatoria tiene un efecto de centrado que se debilita a medida que aumenta c .

Dado que las probabilidades dependen solo de la posición actual (valor de x ) y no de ninguna posición anterior, esta caminata aleatoria sesgada satisface la definición de una cadena de Markov.

Juego

Suponga que comienza con $ 10 y apuesta $ 1 en un lanzamiento de moneda justo e interminable indefinidamente o hasta que pierde todo su dinero. Si representa la cantidad de dólares que tiene después de n lanzamientos, con , entonces la secuencia es un proceso de Markov. Si sé que tiene $ 12 ahora, entonces se esperaría que con probabilidades iguales, tenga $ 11 o $ 13 después del próximo lanzamiento. Esta suposición no mejora con el conocimiento adicional de que comenzó con $ 10, luego subió a $ 11, bajó a $ 10, hasta $ 11 y luego a $ 12. El hecho de que la suposición no mejore con el conocimiento de lanzamientos anteriores muestra la propiedad de Markov , la propiedad sin memoria de un proceso estocástico. [1] [2]

Un modelo meteorológico simple

Las probabilidades de las condiciones climáticas (modeladas como lluviosas o soleadas), dado el clima del día anterior, se pueden representar mediante una matriz de transición : [3]

La matriz P representa el modelo meteorológico en el que un día soleado tiene un 90% de probabilidades de ser seguido por otro día soleado, y un día lluvioso es un 50% de probabilidades de que sea seguido por otro día lluvioso. [3] Las columnas se pueden etiquetar como "soleado" y "lluvioso", y las filas se pueden etiquetar en el mismo orden.

( P ) ij es la probabilidad de que, si un día determinado es de tipo i , vaya seguido de un día de tipo j .

Observe que las filas de P suman 1: esto se debe a que P es una matriz estocástica . [3]

Predecir el clima

Se sabe que el clima en el día 0 (hoy) es soleado. Esto está representado por un vector en el que la entrada "soleado" es 100% y la entrada "lluviosa" es 0%:

El tiempo el día 1 (mañana) se puede predecir mediante:

Por lo tanto, existe un 90% de probabilidad de que el día 1 también sea soleado.

El tiempo en el día 2 (pasado mañana) se puede predecir de la misma manera:

o

Las reglas generales para el día n son:

Estado estable del clima

En este ejemplo, las predicciones meteorológicas en días más distantes son cada vez más inexactas y tienden a un vector de estado estable . [4] Este vector representa las probabilidades de clima soleado y lluvioso en todos los días y es independiente del clima inicial. [4]

El vector de estado estacionario se define como:

pero converge a un vector estrictamente positivo solo si P es una matriz de transición regular (es decir, hay al menos un P n con todas las entradas distintas de cero).

Desde el q es independiente de las condiciones iniciales, debe ser sin cambios cuando transformado por P . [4] Esto hace que sea un vector propio (con valor propio 1), y medios que se puede derivar de P . [4] Para el ejemplo del tiempo:

y dado que son un vector de probabilidad, sabemos que

Resolver este par de ecuaciones simultáneas da la distribución de estado estable:

En conclusión, a largo plazo, alrededor del 83,3% de los días son soleados.

Bolsa de Valores

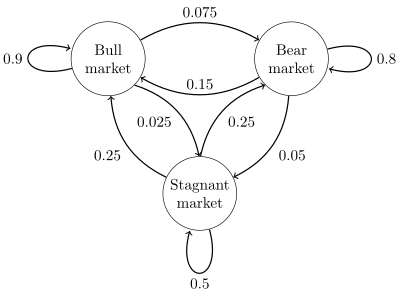

En la figura de la derecha se muestra un diagrama de estado para un ejemplo simple, utilizando un gráfico dirigido para representar las transiciones de estado . Los estados representan si un mercado de valores hipotético está exhibiendo un mercado alcista , un mercado bajista o una tendencia de mercado estancada durante una semana determinada. Según la figura, una semana alcista es seguida por otra semana alcista el 90% del tiempo, una semana bajista el 7.5% del tiempo y una semana estancada el otro 2.5% del tiempo. Al etiquetar el espacio de estados {1 = toro, 2 = oso, 3 = estancado} la matriz de transición para este ejemplo es

La distribución sobre los estados se puede escribir como un vector fila estocástico x con la relación x ( n + 1) = x ( n ) P . Entonces, si en el momento n el sistema está en el estado x ( n ) , entonces tres períodos de tiempo después, en el momento n + 3 la distribución es

En particular, si en el momento n el sistema está en el estado 2 (oso), entonces en el momento n + 3 la distribución es

Usando la matriz de transición es posible calcular, por ejemplo, la fracción de semanas a largo plazo durante las cuales el mercado está estancado, o el número promedio de semanas que se necesitarán para pasar de un mercado estancado a uno alcista. Usando las probabilidades de transición, las probabilidades de estado estable indican que el 62.5% de las semanas estarán en un mercado alcista, el 31.25% de las semanas estarán en un mercado bajista y el 6.25% de las semanas estarán estancadas, ya que:

Se puede encontrar un desarrollo completo y muchos ejemplos en la monografía en línea Meyn & Tweedie 2005. [6]

Se puede utilizar una máquina de estados finitos como representación de una cadena de Markov. Suponiendo una secuencia de señales de entrada independientes e idénticamente distribuidas (por ejemplo, símbolos de un alfabeto binario elegido mediante el lanzamiento de una moneda), si la máquina está en el estado y en el momento n , entonces la probabilidad de que se mueva al estado x en el momento n + 1 depende solo del estado actual.

Tiempo continuo

Un proceso de nacimiento-muerte

Si uno hace estallar cien granos de palomitas de maíz en un horno, cada grano explota en un tiempo independiente distribuido exponencialmente , entonces este sería un proceso de Markov de tiempo continuo . Si denota el número de núcleos que han aparecido hasta el momento t , el problema se puede definir como encontrar el número de núcleos que aparecerán en algún momento posterior. Lo único que se necesita saber es el número de núcleos que aparecieron antes del tiempo "t". No es necesario saber cuándo aparecieron, por lo que conocer la "t" de tiempos anteriores no es relevante.

El proceso que se describe aquí es una aproximación de un proceso de punto de Poisson; los procesos de Poisson también son procesos de Markov.

Ver también

- Mark V. Shaney

- Sistema de partículas interactivas

- Autómatas celulares estocásticos

Referencias

- ↑ Øksendal, BK (Bernt Karsten), 1945- (2003). Ecuaciones diferenciales estocásticas: una introducción con aplicaciones (6ª ed.). Berlín: Springer. ISBN 3540047581. OCLC 52203046 .CS1 maint: varios nombres: lista de autores ( enlace )

- ^ Gagniuc, Paul A. (2017). Cadenas de Markov: de la teoría a la implementación y experimentación . Estados Unidos, Nueva Jersey: John Wiley & Sons. págs. 1–235. ISBN 978-1-119-38755-8.

- ↑ a b c Van Kampen, NG (2007). Procesos estocásticos en física y química . NL: Holanda Septentrional Elsevier. págs. 73 –95. ISBN 978-0-444-52965-7.

- ↑ a b c d Van Kampen, NG (2007). Procesos estocásticos en física y química . NL: Holanda Septentrional Elsevier. págs. 73 –95. ISBN 978-0-444-52965-7.

- ↑ a b Gagniuc, Paul A. (2017). Cadenas de Markov: de la teoría a la implementación y experimentación . Hoboken, Nueva Jersey: John Wiley & Sons. págs. 131-163. ISBN 9781119387572. OCLC 982373850 .

- ^ SP Meyn y RL Tweedie, 2005. Cadenas de Markov y estabilidad estocástica. Archivado el 3 de septiembre de 2013 en la Wayback Machine.

Este artículo necesita citas adicionales para su verificación . ( junio de 2016 ) |

enlaces externos

- El monopolio como cadena de Markov

- Modelos de Markov

- Ejemplos matemáticos

![{\ displaystyle {\ begin {align} x ^ {(n + 3)} & = {\ begin {bmatrix} 0 & 1 & 0 \ end {bmatrix}} {\ begin {bmatrix} 0.9 & 0.075 & 0.025 \\ 0.15 & 0. 8 & 0.05 \\ 0.25 & 0.25 & 0.5 \ end {bmatrix}} ^ {3} \\ [5pt] & = {\ begin {bmatrix} 0 & 1 & 0 \ end {bmatrix}} {\ begin {bmatrix} 0.7745 & 0. 17875 & 0.04675 \\ 0.3575 & 0.56825 & 0.07425 \\ 0.4675 & 0.37125 & 0.16125 \\\ end {bmatrix}} \\ [5pt] & = {\ begin {bmatrix} 0.3575 & 0.56825 & 0.07425 \ end {bmatrix }}. \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e236058858e3e9fc8c0bd61f7168c236bceedd37)