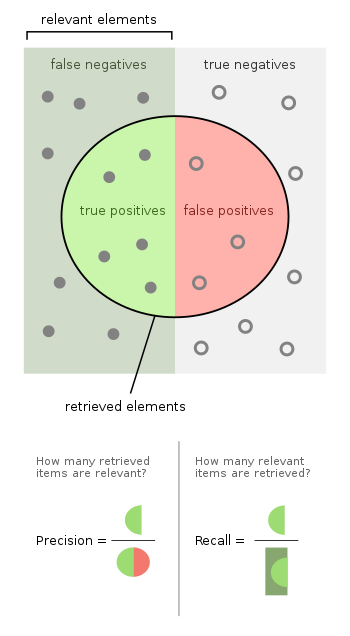

En el reconocimiento de patrones , la recuperación y clasificación de información (aprendizaje automático) , la precisión (también llamada valor predictivo positivo ) es la fracción de instancias relevantes entre las instancias recuperadas, mientras que la recuperación (también conocida como sensibilidad ) es la fracción de instancias relevantes que se recuperaron. Por tanto, tanto la precisión como la memoria se basan en la relevancia .

Supongamos que un programa de computadora para reconocer perros (el elemento relevante ) en fotografías identifica ocho perros en una imagen que contiene diez gatos y doce perros, y de los ocho que identifica como perros, cinco en realidad son perros (verdaderos positivos), mientras que los otros tres son gatos (falsos positivos). Se perdieron siete perros (falsos negativos) y siete gatos se excluyeron correctamente (verdaderos negativos). La precisión del programa es entonces 5/8 (verdaderos positivos / todos los positivos) mientras que su recuperación es 5/12 (verdaderos positivos / elementos relevantes).

Cuando un motor de búsqueda devuelve 30 páginas, de las cuales solo 20 son relevantes, mientras que no devuelve 40 páginas relevantes adicionales, su precisión es 20/30 = 2/3, lo que nos dice qué tan válidos son los resultados, mientras que su recuperación es 20 / 60 = 1/3, que nos dice qué tan completos son los resultados.

Adoptar un enfoque de prueba de hipótesis a partir de estadísticas , en el que, en este caso, la hipótesis nula es que un elemento dado es irrelevante , es decir, no un perro, ausencia de errores de tipo I y tipo II (es decir, especificidad perfecta y sensibilidad del 100% cada uno) corresponde respectivamente a una precisión perfecta (sin falsos positivos) y una recuperación perfecta (sin falsos negativos).

De manera más general, la recuperación es simplemente el complemento de la tasa de error de tipo II, es decir, uno menos la tasa de error de tipo II. La precisión está relacionada con la tasa de error tipo I, pero de una manera un poco más complicada, ya que también depende de la distribución previa de ver un elemento relevante frente a uno irrelevante.

El ejemplo de gato y perro anterior contenía 8 - 5 = 3 errores de tipo I, para una tasa de error de tipo I de 3/10, y 12 - 5 = 7 errores de tipo II, para una tasa de error de tipo II de 7/12. La precisión puede verse como una medida de calidad y el recuerdo como una medida de cantidad. Una mayor precisión significa que un algoritmo devuelve resultados más relevantes que los irrelevantes, y una alta recuperación significa que un algoritmo devuelve la mayoría de los resultados relevantes (ya sea que también se devuelvan los irrelevantes o no).

Introducción [ editar ]

En la recuperación de información , las instancias son documentos y la tarea es devolver un conjunto de documentos relevantes dado un término de búsqueda. La recuperación es la cantidad de documentos relevantes recuperados por una búsqueda dividida por la cantidad total de documentos relevantes existentes , mientras que la precisión es la cantidad de documentos relevantes recuperados por una búsqueda dividida por la cantidad total de documentos recuperados por esa búsqueda.

En una tarea de clasificación , la precisión de una clase es el número de verdaderos positivos (es decir, el número de elementos correctamente etiquetados como pertenecientes a la clase positiva) dividido por el número total de elementos etiquetados como pertenecientes a la clase positiva (es decir, la suma de verdaderos positivos y falsos positivos , que son elementos etiquetados incorrectamente como pertenecientes a la clase). El recuerdo en este contexto se define como el número de verdaderos positivos dividido por el número total de elementos que realmente pertenecen a la clase positiva (es decir, la suma de verdaderos positivos y falsos negativos , que son elementos que no fueron etiquetados como pertenecientes a la clase positiva). pero debería haber sido).

En la recuperación de información, una puntuación de precisión perfecta de 1.0 significa que todos los resultados recuperados por una búsqueda fueron relevantes (pero no dice nada sobre si se recuperaron todos los documentos relevantes), mientras que una puntuación de recuperación perfecta de 1.0 significa que todos los documentos relevantes fueron recuperados por la búsqueda ( pero no dice nada sobre cuántos documentos irrelevantes también se recuperaron).

La precisión y la recuperación no son métricas particularmente útiles cuando se usan de forma aislada. Por ejemplo, es posible tener una recuperación perfecta simplemente recuperando cada artículo. Del mismo modo, es posible tener una precisión casi perfecta seleccionando solo un número muy pequeño de elementos extremadamente probables.

En una tarea de clasificación, una puntuación de precisión de 1.0 para una clase C significa que todos los elementos etiquetados como pertenecientes a la clase C pertenecen de hecho a la clase C (pero no dice nada sobre el número de elementos de la clase C que no se etiquetaron correctamente) mientras que un la recuperación de 1.0 significa que todos los elementos de la clase C se etiquetaron como pertenecientes a la clase C (pero no dice nada sobre cuántos elementos de otras clases también se etiquetaron incorrectamente como pertenecientes a la clase C).

A menudo, existe una relación inversa entre precisión y recuerdo, donde es posible aumentar uno a costa de reducir el otro. La cirugía cerebral proporciona un ejemplo ilustrativo de la compensación. Considere la posibilidad de que un neurocirujano extirpe un tumor canceroso del cerebro de un paciente. El cirujano debe extirpar todas las células tumorales, ya que las células cancerosas restantes regenerarán el tumor. Por el contrario, el cirujano no debe eliminar las células cerebrales sanas, ya que eso dejaría al paciente con una función cerebral deteriorada. El cirujano puede ser más liberal en el área del cerebro que extrae para asegurarse de haber extraído todas las células cancerosas. Esta decisión aumenta el recuerdo pero reduce la precisión. Por otro lado, el cirujano puede ser más conservador en el cerebro que extrae para asegurarse de que extrae solo células cancerosas.Esta decisión aumenta la precisión pero reduce el recuerdo. Es decir, una mayor memoria aumenta las posibilidades de eliminar las células sanas (resultado negativo) y aumenta las posibilidades de eliminar todas las células cancerosas (resultado positivo). Una mayor precisión disminuye las posibilidades de eliminar las células sanas (resultado positivo), pero también disminuye las posibilidades de eliminar todas las células cancerosas (resultado negativo).

Por lo general, las puntuaciones de precisión y memoria no se discuten de forma aislada. En cambio, los valores de una medida se comparan para un nivel fijo en la otra medida (por ejemplo, precisión en un nivel de recuperación de 0,75 ) o ambos se combinan en una única medida. Ejemplos de medidas que son una combinación de precisión y recuperación son la medida F (la media armónica ponderada de precisión y recuperación), o el coeficiente de correlación de Matthews , que es una media geométrica de las variantes corregidas por azar: los coeficientes de regresión Informedness ( DeltaP ') y Markedness (DeltaP). [1] [2] Precisiónes una media aritmética ponderada de Precisión y Precisión inversa (ponderada por Sesgo), así como una media aritmética ponderada de Recuperación y Recuperación inversa (ponderada por Prevalencia). [1] Precisión inversa y recuperación inversa son simplemente la precisión y recuperación del problema inverso donde se intercambian etiquetas positivas y negativas (tanto para clases reales como para etiquetas de predicción). La recuperación y la recuperación inversa, o de manera equivalente, la tasa de verdaderos positivos y la tasa de falsos positivos, con frecuencia se grafican entre sí como ROCcurvas y proporcionan un mecanismo basado en principios para explorar las compensaciones de los puntos operativos. Fuera de la recuperación de información, se argumenta que la aplicación de recuperación, precisión y medida F es defectuosa, ya que ignoran la celda negativa verdadera de la tabla de contingencia y se manipulan fácilmente al sesgar las predicciones. [1] El primer problema se 'resuelve' usando Precisión y el segundo problema se 'resuelve' descontando el componente de probabilidad y renormalizando a la kappa de Cohen , pero esto ya no brinda la oportunidad de explorar las compensaciones gráficamente. Sin embargo, Informedness y Markedness son renormalizaciones Kappa de Recall y Precision, [3] y su media geométricaEl coeficiente de correlación de Matthews actúa así como una medida F sin suavizar.

Definición (contexto de recuperación de información) [ editar ]

En contextos de recuperación de información , la precisión y la recuperación se definen en términos de un conjunto de documentos recuperados (por ejemplo, la lista de documentos producida por un motor de búsqueda web para una consulta) y un conjunto de documentos relevantes (por ejemplo, la lista de todos los documentos en Internet que son relevantes para un tema determinado), cf. relevancia . [4]

Precisión [ editar ]

En el campo de la recuperación de información , la precisión es la fracción de documentos recuperados que son relevantes para la consulta:

Por ejemplo, para una búsqueda de texto en un conjunto de documentos, la precisión es el número de resultados correctos dividido por el número de todos los resultados devueltos.

La precisión tiene en cuenta todos los documentos recuperados, pero también se puede evaluar en un rango de corte determinado, considerando solo los mejores resultados devueltos por el sistema. Esta medida se llama precisión en n o P @ n .

La precisión se utiliza con recuperación, el porcentaje de todos los documentos relevantes que devuelve la búsqueda. En ocasiones, las dos medidas se utilizan juntas en la puntuación F 1 (o medida f) para proporcionar una única medida para un sistema.

Tenga en cuenta que el significado y uso de "precisión" en el campo de la recuperación de información difiere de la definición de exactitud y precisión dentro de otras ramas de la ciencia y la tecnología.

Recordar [ editar ]

En la recuperación de información, la recuperación es la fracción de los documentos relevantes que se recuperan con éxito.

Por ejemplo, para una búsqueda de texto en un conjunto de documentos, la recuperación es el número de resultados correctos dividido por el número de resultados que deberían haberse devuelto.

En la clasificación binaria, el recuerdo se llama sensibilidad . Puede verse como la probabilidad de que la consulta recupere un documento relevante.

Es trivial lograr una recuperación del 100% devolviendo todos los documentos en respuesta a cualquier consulta. Por lo tanto, recordar por sí solo no es suficiente, sino que también es necesario medir el número de documentos no relevantes, por ejemplo, calculando también la precisión.

Definición (contexto de clasificación) [ editar ]

Para las tareas de clasificación, los términos verdaderos positivos , verdaderos negativos , falsos positivos y falsos negativos (consulte los errores de tipo I y tipo II para ver las definiciones) comparan los resultados del clasificador bajo prueba con juicios externos confiables. Los términos positivo y negativo se refieren a la predicción del clasificador (a veces conocida como la expectativa ), y los términos verdadero y falso se refieren a si esa predicción corresponde al juicio externo (a veces conocido como la observación ).

Definamos un experimento a partir de P casos positivos y N casos negativos para alguna condición. Los cuatro resultados se pueden formular en una tabla de contingencia o matriz de confusión de 2 × 2 , de la siguiente manera:

| Condición prevista | Fuentes: [5] [6] [7] [8] [9] [10] [11] [12] | |||||

| Población total = P + N | Condición prevista positiva (PP) | Condición prevista negativa (NP) | Información, información de la casa de apuestas (BM) = TPR + TNR - 1 | Umbral de prevalencia (PT) =√ TPR · FPR - FPR/TPR - FPR | ||

| Condición real positiva (P) | Verdadero positivo (TP) , golpear | Falso negativo (FN) , error de tipo II , error , sobreestimación | Tasa de verdaderos positivos (TPR), recuperación , sensibilidad (SEN), probabilidad de detección, tasa de aciertos, potencia =TP/PAG = 1 - FNR | Tasa de falsos negativos (FNR), tasa de fallas =FN/PAG = 1 - TPR | ||

| Condición real negativa (N) | Falso positivo (FP) , error de tipo I , falsa alarma, subestimación | Verdadero negativo (TN) , rechazo correcto | Tasa de falsos positivos (FPR), probabilidad de falsa alarma, caída =FP/norte = 1 - TNR | Tasa de verdaderos negativos (TNR), especificidad (SPC), selectividad =Tennesse/norte = 1 - FPR | ||

| Prevalencia =PAG/P + N | Valor predictivo positivo (VPP), precisión =TP/PÁGINAS = 1 - FDR | Tasa de falsas omisiones (FOR) =FN/PN = 1 - VPN | Razón de probabilidad positiva (LR +) =TPR/FPR | Razón de verosimilitud negativa (LR−) =FNR/TNR | ||

| Precisión (ACC) =TP + TN/P + N | Tasa de descubrimiento falso (FDR) =FP/PÁGINAS = 1 - PPV | Valor predictivo negativo (VPN) =Tennesse/PN = 1 - PARA | Marcado (MK), deltaP (Δp) = PPV + NPV - 1 | Razón de posibilidades de diagnóstico (DOR) =LR +/LR− | ||

| Precisión equilibrada (BA) =TPR + TNR/2 | Puntuación F 1 =2 · PPV · TPR/PPV + TPR = 2TP/2TP + FP + FN | Índice de aves de corral-malvas (FM) = √ PPV · TPR | Puntuación de amenaza (TS), índice de éxito crítico (CSI) =TP/TP + FN + FP | Coeficiente de correlación de Matthews (MCC) = √ TPR · TNR · PPV · NPV - √ FNR · FPR · FOR · FDR | ||

Fuentes: Fawcett (2006), [13] Piryonesi y El-Diraby (2020), [14] Powers (2011), [15] Ting (2011), [16] CAWCR, [17] D. Chicco & G. Jurman (2020, 2021) , [18] [19] Tharwat (2018). [20] |

La precisión y la recuperación se definen entonces como: [21]

El recuerdo en este contexto también se conoce como la tasa o sensibilidad positiva verdadera , y la precisión también se conoce como valor predictivo positivo (VPP); Otras medidas relacionadas utilizadas en la clasificación incluyen la tasa y la precisión de verdaderos negativos . [21] La tasa de verdaderos negativos también se denomina especificidad .

Datos desequilibrados [ editar ]

La precisión puede ser una métrica engañosa para conjuntos de datos desequilibrados. Considere una muestra con 95 valores negativos y 5 positivos. En este caso, clasificar todos los valores como negativos da una puntuación de precisión de 0,95. Hay muchas métricas que no sufren este problema. Por ejemplo, la precisión equilibrada [22] (bACC) normaliza las predicciones verdaderas positivas y negativas verdaderas por el número de muestras positivas y negativas, respectivamente, y divide su suma por dos:

Para el ejemplo anterior (95 muestras negativas y 5 positivas), clasificar todas como negativas da una puntuación de precisión equilibrada de 0,5 (la puntuación máxima de bACC es uno), que es equivalente al valor esperado de una suposición aleatoria en un conjunto de datos equilibrado. La precisión equilibrada puede servir como una métrica de rendimiento general para un modelo, ya sea que las etiquetas verdaderas estén desequilibradas en los datos o no, asumiendo que el costo de FN es el mismo que FP.

Otra métrica es la tasa de condición positiva prevista (PPCR), que identifica el porcentaje de la población total que está marcada. Por ejemplo, para un motor de búsqueda que devuelve 30 resultados (documentos recuperados) de 1.000.000 de documentos, el PPCR es 0,003%.

Según Saito y Rehmsmeier, las gráficas de recuperación de precisión son más informativas que las gráficas ROC cuando se evalúan clasificadores binarios en datos desequilibrados. En tales escenarios, las gráficas ROC pueden ser visualmente engañosas con respecto a las conclusiones sobre la confiabilidad del desempeño de la clasificación. [23]

A diferencia de los enfoques anteriores, si una escala de desequilibrio se aplica directamente ponderando los elementos de la matriz de confusión, las definiciones de métricas estándar aún se aplican incluso en el caso de conjuntos de datos desequilibrados [24] . El procedimiento de ponderación relaciona los elementos de la matriz de confusión con el conjunto de soporte de cada clase considerada.

Interpretación probabilística [ editar ]

También se puede interpretar la precisión y recordar no como razones sino como estimaciones de probabilidades: [25]

- La precisión es la probabilidad estimada de que un documento seleccionado al azar del conjunto de documentos recuperados sea relevante.

- La recuperación es la probabilidad estimada de que se recupere un documento seleccionado al azar del conjunto de documentos relevantes.

Otra interpretación es que la precisión es la probabilidad promedio de recuperación relevante y la recuperación es la probabilidad promedio de recuperación completa promediada sobre múltiples consultas de recuperación.

Medida F [ editar ]

Una medida que combina precisión y recuperación es la media armónica de precisión y recuperación, la medida F tradicional o puntuación F equilibrada:

Esta medida es aproximadamente el promedio de los dos cuando están cerca, y es más generalmente la media armónica que, para el caso de dos números, coincide con el cuadrado de la media geométrica dividida por la media aritmética . Hay varias razones por las que el puntaje F puede ser criticado en circunstancias particulares debido a su sesgo como métrica de evaluación. [1] Esto también se conoce como la medida, porque la memoria y la precisión se ponderan uniformemente.

Es un caso especial de la medida general (para valores reales no negativos de ):

Otras dos medidas de uso común son la medida, cuyas ponderaciones recuerdan más que la precisión, y la medida, que pone más énfasis en la precisión que en la memoria.

La medida F fue derivada por van Rijsbergen (1979) de modo que "mide la efectividad de la recuperación con respecto a un usuario que concede a los tiempos tanta importancia como la precisión". Se basa en la medida de eficacia de van Rijsbergen , siendo el segundo término la media armónica ponderada de precisión y recuperación con pesos . Su relación es donde .

Limitaciones como objetivos [ editar ]

Existen otros parámetros y estrategias para la métrica de rendimiento del sistema de recuperación de información, como el área bajo la curva ROC (AUC). [26]

Ver también [ editar ]

- Coeficiente de incertidumbre , también llamado competencia

- Sensibilidad y especificidad

Referencias [ editar ]

- ↑ a b c d Powers, David MW (2011). "Evaluación: de precisión, recuperación y F-Measure a ROC, información, marca y correlación" (PDF) . Revista de tecnologías de aprendizaje automático . 2 (1): 37–63. Archivado desde el original (PDF) el 14 de noviembre de 2019.

- ↑ Perruchet, P .; Peereman, R. (2004). "La explotación de la información distributiva en el procesamiento de sílabas". J. Neurolingüística . 17 (2-3): 97-119. doi : 10.1016 / s0911-6044 (03) 00059-9 . S2CID 17104364 .

- ^ Poderes, David MW (2012). "El problema con Kappa" . Conferencia del Capítulo Europeo de la Asociación de Lingüística Computacional (EACL2012) Taller conjunto ROBUS-UNSUP .

- ^ * Kent, Allen; Berry, Madeline M .; Luehrs, Jr., Fred U .; Perry, JW (1955). "Búsqueda de literatura de máquinas VIII. Criterios operativos para el diseño de sistemas de recuperación de información". Documentación americana . 6 (2): 93. doi : 10.1002 / asi.5090060209 .

- ^ Fawcett, Tom (2006). "Una introducción al análisis ROC" (PDF) . Cartas de reconocimiento de patrones . 27 (8): 861–874. doi : 10.1016 / j.patrec.2005.10.010 .

- ^ Piryonesi S. Madeh; El-Diraby Tamer E. (1 de marzo de 2020). "Análisis de datos en la gestión de activos: predicción rentable del índice de condición del pavimento". Revista de sistemas de infraestructura . 26 (1): 04019036. doi : 10.1061 / (ASCE) IS.1943-555X.0000512 .

- ^ Poderes, David MW (2011). "Evaluación: de precisión, recuperación y medida F a ROC, información, marca y correlación" . Revista de tecnologías de aprendizaje automático . 2 (1): 37–63.

- ^ Ting, Kai Ming (2011). Sammut, Claude; Webb, Geoffrey I. (eds.). Enciclopedia de aprendizaje automático . Saltador. doi : 10.1007 / 978-0-387-30164-8 . ISBN 978-0-387-30164-8.

- ^ Brooks, Harold; Marrón, púa; Ebert, Beth; Ferro, Chris; Jolliffe, Ian; Koh, Tieh-Yong; Roebber, Paul; Stephenson, David (26 de enero de 2015). "Grupo de trabajo conjunto WWRP / WGNE sobre investigación de verificación de pronósticos" . Colaboración para la investigación meteorológica y climática de Australia . Organización Meteorológica Mundial . Consultado el 17 de julio de 2019 .

- ^ Chicco D., Jurman G. (enero de 2020). "Las ventajas del coeficiente de correlación de Matthews (MCC) sobre la puntuación F1 y la precisión en la evaluación de clasificación binaria" . BMC Genomics . 21 (1): 6-1–6-13. doi : 10.1186 / s12864-019-6413-7 . PMC 6941312 . PMID 31898477 . CS1 maint: uses authors parameter (link)

- ^ Chicco D., Toetsch N., Jurman G. (febrero de 2021). "El coeficiente de correlación de Matthews (MCC) es más confiable que la precisión equilibrada, la información de las casas de apuestas y la marcación en la evaluación de la matriz de confusión de dos clases" . Minería de Biodatos . 14 (13): 1-22. doi : 10.1186 / s13040-021-00244-z . PMC 7863449 . PMID 33541410 . CS1 maint: uses authors parameter (link)

- ^ Tharwat A. (agosto de 2018). "Métodos de evaluación de clasificación" . Informática y Computación Aplicada . doi : 10.1016 / j.aci.2018.08.003 .

- ^ Fawcett, Tom (2006). "Una introducción al análisis ROC" (PDF) . Cartas de reconocimiento de patrones . 27 (8): 861–874. doi : 10.1016 / j.patrec.2005.10.010 .

- ^ Piryonesi S. Madeh; El-Diraby Tamer E. (1 de marzo de 2020). "Análisis de datos en la gestión de activos: predicción rentable del índice de condición del pavimento". Revista de sistemas de infraestructura . 26 (1): 04019036. doi : 10.1061 / (ASCE) IS.1943-555X.0000512 .

- ^ Poderes, David MW (2011). "Evaluación: de precisión, recuperación y medida F a ROC, información, marca y correlación" . Revista de tecnologías de aprendizaje automático . 2 (1): 37–63.

- ^ Ting, Kai Ming (2011). Sammut, Claude; Webb, Geoffrey I. (eds.). Enciclopedia de aprendizaje automático . Saltador. doi : 10.1007 / 978-0-387-30164-8 . ISBN 978-0-387-30164-8.

- ^ Brooks, Harold; Marrón, púa; Ebert, Beth; Ferro, Chris; Jolliffe, Ian; Koh, Tieh-Yong; Roebber, Paul; Stephenson, David (26 de enero de 2015). "Grupo de trabajo conjunto WWRP / WGNE sobre investigación de verificación de pronósticos" . Colaboración para la investigación meteorológica y climática de Australia . Organización Meteorológica Mundial . Consultado el 17 de julio de 2019 .

- ^ Chicco D., Jurman G. (enero de 2020). "Las ventajas del coeficiente de correlación de Matthews (MCC) sobre la puntuación F1 y la precisión en la evaluación de clasificación binaria" . BMC Genomics . 21 (1): 6-1–6-13. doi : 10.1186 / s12864-019-6413-7 . PMC 6941312 . PMID 31898477 . CS1 maint: uses authors parameter (link)

- ^ Chicco D., Toetsch N., Jurman G. (febrero de 2021). "El coeficiente de correlación de Matthews (MCC) es más confiable que la precisión equilibrada, la información de las casas de apuestas y la marcación en la evaluación de la matriz de confusión de dos clases" . Minería de Biodatos . 14 (13): 1-22. doi : 10.1186 / s13040-021-00244-z . PMC 7863449 . PMID 33541410 . CS1 maint: uses authors parameter (link)

- ^ Tharwat A. (agosto de 2018). "Métodos de evaluación de clasificación" . Informática y Computación Aplicada . doi : 10.1016 / j.aci.2018.08.003 .

- ↑ a b Olson, David L .; y Delen, Dursun (2008); Técnicas avanzadas de minería de datos , Springer, primera edición (1 de febrero de 2008), página 138, ISBN 3-540-76916-1

- ↑ Cortacésped, Jeffrey P. (12 de abril de 2005). "PREP-Mt: editor de ARN predictivo para genes mitocondriales de plantas" . BMC Bioinformática . 6 : 96. doi : 10.1186 / 1471-2105-6-96 . ISSN 1471-2105 . PMC 1087475 . PMID 15826309 .

- ^ Saito, Takaya; Rehmsmeier, Marc (4 de marzo de 2015). Brock, Guy (ed.). "La gráfica de recuperación de precisión es más informativa que la gráfica ROC al evaluar clasificadores binarios en conjuntos de datos desequilibrados" . PLOS ONE . 10 (3): e0118432. Código Bibliográfico : 2015PLoSO..1018432S . doi : 10.1371 / journal.pone.0118432 . ISSN 1932-6203 . PMC 4349800 . PMID 25738806 . Resumen Lay (marzo de 2017).

- ^ Tripicchio, Paolo; Camacho González, Gerardo; D'Avella, Salvatore (2020). "Detección de defectos de soldadura: hacer frente a los artefactos en la línea de producción" . Revista internacional de tecnología de fabricación avanzada . 111 (5): 1659--1669.

- ^ Fatih Cakir, Kun He, Xide Xia, Brian Kulis, Stan Sclaroff, Deep Metric Learning to Rank , In Proc. Conferencia IEEE sobre visión artificial y reconocimiento de patrones (CVPR), 2019.

- ^ Zygmunt Zając. Lo que querías saber sobre las AUC. http://fastml.com/what-you-wanted-to-know-about-auc/

- Baeza-Yates, Ricardo; Ribeiro-Neto, Berthier (1999). Recuperación de información moderna . Nueva York, NY: ACM Press, Addison-Wesley, Seiten 75 ff. ISBN 0-201-39829-X

- Hjørland, Birger (2010); La base del concepto de relevancia , Revista de la Sociedad Estadounidense de Ciencia y Tecnología de la Información, 61 (2), 217-237

- Makhoul, John ; Kubala, Francis; Schwartz, Richard; y Weischedel, Ralph (1999); Medidas de desempeño para la extracción de información , en Proceedings of DARPA Broadcast News Workshop, Herndon, VA, febrero de 1999

- van Rijsbergen, Cornelis Joost "Keith" (1979); Recuperación de información , Londres, GB; Boston, MA: Butterworth, segunda edición, ISBN 0-408-70929-4

Enlaces externos [ editar ]

- Recuperación de información - CJ van Rijsbergen 1979

- Precisión informática y recuperación para un problema de clasificación de clases múltiples