Análisis de regresión

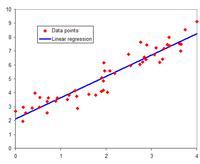

En el modelado estadístico , el análisis de regresión es un conjunto de procesos estadísticos para estimar las relaciones entre una variable dependiente (a menudo llamada variable de 'resultado' o 'respuesta') y una o más variables independientes (a menudo llamadas 'predictores', 'covariables', 'variables explicativas' o 'características'). La forma más común de análisis de regresión es la regresión lineal , en la que se encuentra la línea (o una combinación lineal más compleja ) que se ajusta más a los datos de acuerdo con un criterio matemático específico. Por ejemplo,el método de mínimos cuadrados ordinarios calcula la línea única (o hiperplano) que minimiza la suma de diferencias cuadradas entre los datos verdaderos y esa línea (o hiperplano). Por razones matemáticas específicas (ver regresión lineal ), esto permite al investigador estimar la expectativa condicional (o valor promedio de la población ) de la variable dependiente cuando las variables independientes toman un conjunto de valores dado. Las formas menos comunes de regresión utilizan procedimientos ligeramente diferentes para estimar parámetros de ubicación alternativos (p. Ej., Regresión cuantílica o análisis de condición necesaria [1] ) o estimar la expectativa condicional a través de una colección más amplia de modelos no lineales (p. Ej., Regresión no paramétrica ).

El análisis de regresión se utiliza principalmente para dos propósitos conceptualmente distintos. Primero, el análisis de regresión se usa ampliamente para la predicción y el pronóstico , donde su uso se superpone sustancialmente con el campo del aprendizaje automático . En segundo lugar, en algunas situaciones el análisis de regresión se puede utilizar para inferir relaciones causalesentre las variables independientes y dependientes. Es importante destacar que las regresiones por sí mismas solo revelan relaciones entre una variable dependiente y una colección de variables independientes en un conjunto de datos fijo. Para usar regresiones para la predicción o para inferir relaciones causales, respectivamente, un investigador debe justificar cuidadosamente por qué las relaciones existentes tienen poder predictivo para un nuevo contexto o por qué una relación entre dos variables tiene una interpretación causal. Esto último es especialmente importante cuando los investigadores esperan estimar las relaciones causales utilizando datos de observación . [2] [3]

La forma más temprana de regresión fue el método de mínimos cuadrados , que fue publicado por Legendre en 1805, [4] y por Gauss en 1809. [5] Legendre y Gauss aplicaron el método al problema de determinar, a partir de observaciones astronómicas, el órbitas de cuerpos alrededor del Sol (en su mayoría cometas, pero también más tarde los planetas menores recién descubiertos). Gauss publicó un desarrollo adicional de la teoría de mínimos cuadrados en 1821, [6] incluyendo una versión del teorema de Gauss-Markov .

El término "regresión" fue acuñado por Francis Galton en el siglo XIX para describir un fenómeno biológico. El fenómeno fue que las alturas de los descendientes de antepasados altos tienden a retroceder hacia un promedio normal (un fenómeno también conocido como regresión hacia la media ). [7] [8] Para Galton, la regresión sólo tenía este significado biológico, [9] [10] pero su trabajo fue ampliado más tarde por Udny Yule y Karl Pearson a un contexto estadístico más general. [11] [12] En el trabajo de Yule y Pearson, se supone que la distribución conjunta de la respuesta y las variables explicativas es gaussiana. Esta suposición fue debilitada por RA Fisher en sus trabajos de 1922 y 1925. [13] [14] [15] Fisher asumió que la distribución condicional de la variable de respuesta es gaussiana, pero la distribución conjunta no tiene por qué serlo. A este respecto, el supuesto de Fisher se acerca más a la formulación de Gauss de 1821.

En las décadas de 1950 y 1960, los economistas utilizaron "calculadoras" electromecánicas de escritorio para calcular las regresiones. Antes de 1970, a veces se tardaba hasta 24 horas en recibir el resultado de una regresión. [dieciséis]