Las variables dependientes e independientes son variables en modelos matemáticos , modelos estadísticos y ciencias experimentales . Las variables dependientes reciben este nombre porque, en un experimento, sus valores se estudian bajo el supuesto o hipótesis de que dependen, por alguna ley o regla (por ejemplo, por una función matemática ), de los valores de otras variables. Las variables independientes, a su vez, no se consideran dependientes de ninguna otra variable en el alcance del experimento en cuestión. [a] En este sentido, algunas variables independientes comunes son tiempo , espacio , densidad ,masa , caudal de fluido , [1] [2] y valores previos de algún valor observado de interés (por ejemplo, tamaño de la población humana) para predecir valores futuros (la variable dependiente). [3]

De las dos, siempre es la variable dependiente cuya variación se está estudiando, mediante la alteración de los insumos, también conocidos como regresores en un contexto estadístico . En un experimento, cualquier variable que manipule el experimentador [ aclaración necesaria ] puede denominarse variable independiente. Los modelos y experimentos prueban los efectos que tienen las variables independientes sobre las variables dependientes. A veces, incluso si su influencia no es de interés directo, las variables independientes pueden incluirse por otras razones, como para dar cuenta de su potencial efecto de confusión .

Matemáticas [ editar ]

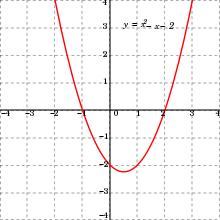

En matemáticas, una función es una regla para tomar una entrada (en el caso más simple, un número o conjunto de números) [5] y proporcionar una salida (que también puede ser un número). [5] Un símbolo que representa una entrada arbitraria se llama variable independiente , mientras que un símbolo que representa una salida arbitraria se llama variable dependiente . [6] El símbolo más común para la entrada es x , y el símbolo más común para la salida es y ; la función en sí se escribe comúnmente y = f ( x ) . [6] [7]

Es posible tener múltiples variables independientes o múltiples variables dependientes. Por ejemplo, en el cálculo multivariable , a menudo se encuentra funciones de la forma z = f ( x , y ) , donde z es una variable dependiente y x y y son variables independientes. [8] Las funciones con múltiples salidas a menudo se denominan funciones con valores vectoriales .

Estadísticas [ editar ]

En un experimento , la variable manipulada por un experimentador es algo que se ha demostrado que funciona y se llama variable independiente. [9] La variable dependiente es el evento que se espera que cambie cuando se manipula la variable independiente. [10]

En las herramientas de minería de datos (para estadísticas multivariadas y aprendizaje automático ), a la variable dependiente se le asigna un rol como variable de destino (o en algunas herramientas como atributo de etiqueta ), mientras que a una variable independiente se le puede asignar un rol como variable regular . [11] Se proporcionan valores conocidos para la variable objetivo para el conjunto de datos de entrenamiento y el conjunto de datos de prueba , pero deben predecirse para otros datos. La variable de destino se utiliza en algoritmos de aprendizaje supervisado , pero no en el aprendizaje no supervisado.

Modelado [ editar ]

En el modelado matemático , la variable dependiente se estudia para ver si varía y cuánto varía a medida que varían las variables independientes. En el modelo lineal estocástico simple y i = a + b x i + e i el término y i es el i- ésimo valor de la variable dependiente y x i es el i- ésimo valor de la variable independiente. El término e i se conoce como "error" y contiene la variabilidad de la variable dependiente no explicada por la variable independiente.

Con múltiples variables independientes, el modelo es y i = a + b x i , 1 + b x i , 2 + ... + b x i, n + e i , donde n es el número de variables independientes. [ cita requerida ]

Ahora se analiza el modelo de regresión lineal. Para usar la regresión lineal, se genera un diagrama de dispersión de datos con X como variable independiente e Y como variable dependiente. Esto también se denomina conjunto de datos bivariados, ( x 1 , y 1 ) ( x 2 , y 2 ) ... ( x i , y i ) . El modelo de regresión lineal simple toma la forma Y i = a + B x i + U i , para i = 1, 2, ..., n . En este caso,U i , ..., U n son variables aleatorias independientes. Esto ocurre cuando las medidas no se influyen entre sí. Mediante la propagación de la independencia, la independencia de U i implica la independencia de Y i , aunque cada Y i tiene un valor de expectativa diferente. Cada U i tiene un valor esperado de 0 y una varianza de σ 2 . [12]

Expectativa de Y i Prueba: [12]

La línea de mejor ajuste para el conjunto de datos bivariados toma la forma y = α + βx y se llama línea de regresión. α y β corresponden a la intersección y la pendiente, respectivamente. [12]

Simulación [ editar ]

En la simulación , la variable dependiente se cambia en respuesta a cambios en las variables independientes.

Sinónimos de estadística [ editar ]

Dependiendo del contexto, una variable independiente a veces se llama "variable predictora", regresor , covariable , "variable manipulada", "variable explicativa", variable de exposición (ver teoría de confiabilidad ), " factor de riesgo " (ver estadísticas médicas ), " feature "(en aprendizaje automático y reconocimiento de patrones ) o" variable de entrada ". [13] [14] En econometría , el término "variable de control" se usa generalmente en lugar de "covariable". [15] [16] [17] [18] [19]

Desde la comunidad de Economía, las variables independientes también se denominan exógenas .

Dependiendo del contexto, una variable dependiente a veces se denomina "variable de respuesta", "regresando", "criterio", "variable predicha", "variable medida", "variable explicada", "variable experimental", "variable de respuesta", "variable de resultado", "variable de salida", "objetivo" o "etiqueta". [14] En economía, las variables endógenas suelen hacer referencia al objetivo.

"Variable explicativa"es preferido por algunos autores sobre "variable independiente" cuando las cantidades tratadas como variables independientes pueden no ser estadísticamente independientes o manipulables independientemente por el investigador. [20] [21] Si la variable independiente se denomina "variable explicativa", entonces el término "variable de respuesta"es preferido por algunos autores para la variable dependiente. [14] [20] [21]

"Variable explicada"Algunos autores prefieren la "variable dependiente" cuando las cantidades tratadas como "variables dependientes" pueden no ser estadísticamente dependientes. [22] Si la variable dependiente se denomina "variable explicada", entonces el término "variable predictora"es preferido por algunos autores para la variable independiente. [22]

Las variables también pueden ser denominadas por su forma: continua o categórica , que a su vez puede ser binaria / dicotómica, categórica nominal y categórica ordinal, entre otras.

Un ejemplo lo proporciona el análisis de la tendencia del nivel del mar realizado por Woodworth (1987) . En este caso, la variable dependiente (y la variable de mayor interés) fue el nivel medio anual del mar en un lugar determinado para el que se disponía de una serie de valores anuales. La principal variable independiente fue el tiempo. Se utilizó una covariable formada por valores anuales de la presión atmosférica media anual al nivel del mar. Los resultados mostraron que la inclusión de la covariable permitió obtener mejores estimaciones de la tendencia contra el tiempo, en comparación con los análisis que omitieron la covariable.

Otras variables [ editar ]

Se puede pensar que una variable altera las variables dependientes o independientes, pero es posible que en realidad no sea el foco del experimento. De modo que la variable se mantendrá constante o monitoreada para tratar de minimizar su efecto en el experimento. Tales variables pueden designarse como "variable controlada", " variable de control " o "variable fija".

Las variables extrañas, si se incluyen en un análisis de regresión como variables independientes, pueden ayudar a un investigador con la estimación precisa de los parámetros de respuesta, la predicción y la bondad de ajuste , pero no son de interés sustancial para la hipótesis bajo examen. Por ejemplo, en un estudio que examina el efecto de la educación postsecundaria sobre los ingresos de toda la vida, algunas variables extrañas pueden ser el género, la etnia, la clase social, la genética, la inteligencia, la edad, etc. Una variable es extraña solo cuando se puede suponer (o mostrar) que influye en la variable dependiente . Si se incluye en una regresión, puede mejorar el ajuste del modelo. Si se excluye de la regresión y tiene una covarianza distinta de cero con una o más de las variables independientes de interés, su omisión sesgará el resultado de la regresión por el efecto de esa variable independiente de interés. Este efecto se denomina sesgo de variable de confusión u omitida ; en estas situaciones, es necesario realizar cambios de diseño y / o controlar una variable de control estadístico.

Las variables extrañas a menudo se clasifican en tres tipos:

- Variables de sujeto, que son las características de los individuos en estudio que pueden afectar sus acciones. Estas variables incluyen edad, sexo, estado de salud, estado de ánimo, antecedentes, etc.

- Las variables de bloqueo o las variables experimentales son características de las personas que realizan el experimento que pueden influir en el comportamiento de una persona. El género, la presencia de discriminación racial, el idioma u otros factores pueden calificar como tales variables.

- Las variables situacionales son características del entorno en el que se realizó el estudio o la investigación, que influyen negativamente en el resultado del experimento. Se incluyen la temperatura del aire, el nivel de actividad, la iluminación y la hora del día.

En el modelado, la variabilidad que no está cubierta por la variable independiente se designa y se conoce como " residual ", "efecto secundario", " error ", "participación inexplicable", "variable residual", "perturbación" o "tolerancia ".

Ejemplos [ editar ]

- Efecto del fertilizante sobre el crecimiento de las plantas:

- En un estudio que mida la influencia de diferentes cantidades de fertilizante en el crecimiento de las plantas, la variable independiente sería la cantidad de fertilizante utilizada. La variable dependiente sería el crecimiento en altura o masa de la planta. Las variables controladas serían el tipo de planta, el tipo de fertilizante, la cantidad de luz solar que recibe la planta, el tamaño de las macetas, etc.

- Efecto de la dosis del fármaco sobre la gravedad de los síntomas:

- En un estudio de cómo las diferentes dosis de un medicamento afectan la gravedad de los síntomas, un investigador podría comparar la frecuencia y la intensidad de los síntomas cuando se administran diferentes dosis. Aquí la variable independiente es la dosis y la variable dependiente es la frecuencia / intensidad de los síntomas.

- Efecto de la temperatura sobre la pigmentación:

- Al medir la cantidad de color eliminado de las muestras de remolacha a diferentes temperaturas, la temperatura es la variable independiente y la cantidad de pigmento eliminado es la variable dependiente.

- Efecto del azúcar añadido en un café:

- El sabor varía con la cantidad de azúcar agregada al café. Aquí, el azúcar es la variable independiente, mientras que el sabor es la variable dependiente.

Ver también [ editar ]

- Abscisa y ordenada

- Bloqueo (estadísticas)

- Variable latente versus variable observable

Notas [ editar ]

- ^ Incluso si la dependencia existente es invertible (por ejemplo, encontrando la función inversa cuando existe), la nomenclatura se mantiene si la dependencia inversa no es el objeto de estudio en el experimento.

Referencias [ editar ]

- ^ Aris, Rutherford (1994). Técnicas de modelado matemático . Corporación de mensajería.

- ^ Boyce, William E .; Richard C. DiPrima (2012). Ecuaciones diferenciales elementales . John Wiley e hijos.

- ^ Alligood, Kathleen T .; Sauer, Tim D .; Yorke, James A. (1996). Caos una introducción a los sistemas dinámicos . Springer Nueva York.

- ^ Hastings, Nancy Baxter. Taller de cálculo: exploración guiada con repaso. Vol. 2. Springer Science & Business Media, 1998. p. 31

- ^ a b Carlson, Robert. Una introducción concreta al análisis real. CRC Press, 2006. p.183

- ^ a b Stewart, James. Cálculo. Cengage Learning, 2011. Sección 1.1

- ^ Anton, Howard, Irl C. Bivens y Stephen Davis. Cálculo de una sola variable. John Wiley & Sons, 2012. Sección 0.1

- ^ Larson, Ron y Bruce Edwards. Cálculo. Cengage Learning, 2009. Sección 13.1

- ^ http://onlinestatbook.com/2/introduction/variables.html

- ^ Diccionario íntegro de Random House Webster. Random House, Inc. 2001. Página 534, 971. ISBN 0-375-42566-7 .

- ^ Versión del manual en inglés 1.0 Archivado el 10 de febrero de 2014 en Wayback Machine para RapidMiner 5.0, octubre de 2013.

- ^ a b c Dekking, Frederik Michel (2005), Una introducción moderna a la probabilidad y la estadística: comprender por qué y cómo , Springer, ISBN 1-85233-896-2, OCLC 783259968

- ^ Dodge, Y. (2003) El diccionario de términos estadísticos de Oxford , OUP. ISBN 0-19-920613-9 (entrada para "variable independiente")

- ^ a b c Dodge, Y. (2003) El diccionario de términos estadísticos de Oxford , OUP. ISBN 0-19-920613-9 (entrada para "regresión")

- ↑ Gujarati, Damodar N .; Porter, Dawn C. (2009). "Terminología y notación". Econometría básica (Quinta ed. Internacional). Nueva York: McGraw-Hill. pag. 21. ISBN 978-007-127625-2.

- ^ Wooldridge, Jeffrey (2012). Econometría introductoria: un enfoque moderno (Quinta ed.). Mason, OH: South-Western Cengage Learning. págs. 22-23. ISBN 978-1-111-53104-1.

- ^ Por último, John M., ed. (2001). Diccionario de epidemiología (Cuarta ed.). Oxford UP. ISBN 0-19-514168-7.

- ^ Everitt, BS (2002). El Diccionario de Estadística de Cambridge (2ª ed.). Cambridge UP. ISBN 0-521-81099-X.

- ^ Woodworth, PL (1987). "Tendencias en el nivel del mar medio del Reino Unido". Geodesia marina . 11 (1): 57–87. doi : 10.1080 / 15210608709379549 .Mantenimiento CS1: ref = harv ( enlace )

- ^ a b Everitt, BS (2002) Diccionario de estadística de Cambridge, CUP. ISBN 0-521-81099-X

- ^ a b Dodge, Y. (2003) El diccionario de términos estadísticos de Oxford , OUP. ISBN 0-19-920613-9

- ^ a b Ash Narayan Sah (2009) Análisis de datos con Microsoft Excel, Nueva Delhi. ISBN 978-81-7446-716-4

| Wikiversity tiene recursos de aprendizaje sobre la variable independiente |

| Wikiversity tiene recursos de aprendizaje sobre la variable dependiente |

![{\ Displaystyle E [Y_ {i}] = E [\ alpha + \ beta x_ {i} + U_ {i}] = \ alpha + \ beta x_ {i} + E [U_ {i}] = \ alpha + \ beta x_ {i}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/060c6d2c55947cceb008cbe330e1b07a2c119d3a)