Codificación de caracteres

La codificación de caracteres es el proceso de asignar números a los caracteres gráficos , especialmente a los caracteres escritos del lenguaje humano , lo que permite almacenarlos , transmitirlos y transformarlos mediante computadoras digitales . [1] Los valores numéricos que componen una codificación de caracteres se conocen como " puntos de código " y colectivamente comprenden un "espacio de código", una " página de códigos " o un " mapa de caracteres ".

Los primeros códigos de caracteres asociados con el telégrafo óptico o eléctrico solo podían representar un subconjunto de los caracteres utilizados en los idiomas escritos , a veces restringidos a letras mayúsculas , números y solo algunos signos de puntuación . El bajo costo de la representación digital de datos en los sistemas informáticos modernos permite códigos de caracteres más elaborados (como Unicode ) que representan la mayoría de los caracteres utilizados en muchos lenguajes escritos. La codificación de caracteres utilizando estándares aceptados internacionalmente permite el intercambio de texto en formato electrónico en todo el mundo.

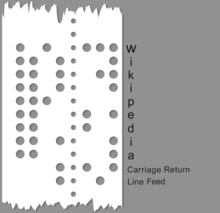

La historia de los códigos de caracteres ilustra la necesidad creciente de información simbólica basada en caracteres mediada por máquinas a distancia, utilizando medios eléctricos que alguna vez fueron novedosos. Los primeros códigos se basaban en sistemas de codificación y cifrado manuales y escritos a mano, como el cifrado de Bacon , Braille , banderas de señales marítimas internacionales y la codificación de 4 dígitos de caracteres chinos para un código telegráfico chino ( Hans Schjellerup , 1869). Con la adopción de técnicas eléctricas y electromecánicas, estos primeros códigos se adaptaron a las nuevas capacidades y limitaciones de las primeras máquinas. El código de caracteres transmitido eléctricamente más antiguo conocido, el código Morse, introducido en la década de 1840, utilizó un sistema de cuatro "símbolos" (señal corta, señal larga, espacio corto, espacio largo) para generar códigos de longitud variable. Aunque parte del uso comercial del código Morse se realizó a través de maquinaria, a menudo se usaba como código manual, generado a mano en una tecla de telégrafo y descifrable de oído, y persiste en radioaficionados y uso aeronáutico . La mayoría de los códigos tienen una longitud fija por carácter o secuencias de longitud variable de códigos de longitud fija (por ejemplo, Unicode ). [2]

Los ejemplos comunes de sistemas de codificación de caracteres incluyen el código Morse , el código Baudot , el Código estándar americano para el intercambio de información ( ASCII ) y Unicode . Unicode , un sistema de codificación extensible y bien definido, ha suplantado a la mayoría de las codificaciones de caracteres anteriores, pero el camino del desarrollo del código hasta el presente es bastante conocido.

El código Baudot , una codificación de cinco bits, fue creado por Émile Baudot en 1870, patentado en 1874, modificado por Donald Murray en 1901 y estandarizado por el CCITT como Alfabeto Telegráfico Internacional No. 2 (ITA2) en 1930. El nombre "baudot "se ha aplicado erróneamente a ITA2 y sus muchas variantes. ITA2 adolecía de muchas deficiencias y, a menudo, muchos fabricantes de equipos lo "mejoraban", lo que a veces creaba problemas de compatibilidad. En 1959, el ejército estadounidense definió su Fieldatacode, un código de seis o siete bits, introducido por el Cuerpo de Señales del Ejército de EE. UU. Si bien Fieldata abordó muchos de los problemas entonces modernos (por ejemplo, códigos de letras y dígitos dispuestos para la clasificación de la máquina), Fieldata no alcanzó sus objetivos y fue de corta duración. En 1963, el primer código ASCII (Código estándar americano para el intercambio de información) fue publicado (X3.4-1963) por el comité ASCII (que incluía al menos a un miembro del comité Fieldata, WF Leubbert) que abordó la mayoría de las deficiencias de Fieldata , usando un código más simple. Muchos de los cambios fueron sutiles, como conjuntos de caracteres que se pueden comparar dentro de ciertos rangos numéricos. ASCII63 fue un éxito, ampliamente adoptado por la industria, y con el número de seguimiento del código ASCII de 1967 (que agregó letras minúsculas y solucionó algunos problemas de "código de control"), ASCII67 fue adoptado de manera bastante generalizada. ASCII67 'La naturaleza centrada en Estados Unidos se abordó de alguna manera en elEstándar ECMA-6 . [3]