distribución de veneno

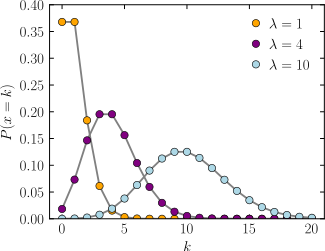

Función de probabilidad  El eje horizontal es el índice k , el número de ocurrencias. λ es la tasa esperada de ocurrencias. El eje vertical es la probabilidad de k ocurrencias dado λ . La función se define solo en valores enteros de k ; las líneas de conexión son solo guías para el ojo. | |||

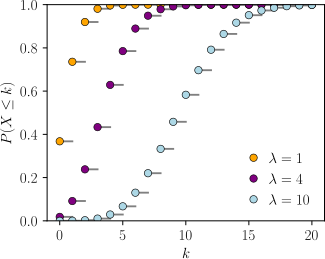

Función de distribución acumulativa  El eje horizontal es el índice k , el número de ocurrencias. La CDF es discontinua en los números enteros de k y plana en todos los demás lugares porque una variable que está distribuida por Poisson toma solo valores enteros. | |||

| Notación | |||

|---|---|---|---|

| Parámetros | (Velocidad) | ||

| Apoyo | ( Números naturales a partir de 0) | ||

| PMF | |||

| CDF | , o , o (porque , donde está la función gamma incompleta superior , es la función del piso y Q es la función gamma regularizada ) | ||

| Significar | |||

| Mediana | |||

| Modo | |||

| Diferencia | |||

| Oblicuidad | |||

| Ex. curtosis | |||

| Entropía | (para grandes ) | ||

| MGF | |||

| CF | |||

| PGF | |||

| Información de Fisher | |||

En teoría de la probabilidad y estadísticas , la distribución de Poisson ( / p w ɑː s ɒ n / ; pronunciación francesa: [pwasɔ] ), el nombre de francés el matemático Denis Poisson , es una distribución de probabilidad discreta que expresa la probabilidad de que un número dado de eventos que ocurren en un intervalo fijo de tiempo o espacio si estos eventos ocurren con una tasa media constante conocida e independientemente del tiempo transcurrido desde el último evento. [1] La distribución de Poisson también se puede utilizar para el número de eventos en otros intervalos especificados, como la distancia, el área o el volumen.

Por ejemplo, un centro de llamadas recibe un promedio de 180 llamadas por hora, las 24 horas del día. Las llamadas son independientes; recibir uno no cambia la probabilidad de cuándo llegará el siguiente. El número de llamadas recibidas durante cualquier minuto tiene una distribución de probabilidad de Poisson: los números más probables son 2 y 3, pero también son probables 1 y 4 y hay una pequeña probabilidad de que sea tan bajo como cero y una probabilidad muy pequeña de que sea 10. Otro ejemplo es el número de eventos de desintegración que ocurren a partir de una fuente radiactiva durante un período de observación definido.

Definiciones

Función de probabilidad

Se dice que una variable aleatoria discreta X tiene una distribución de Poisson, con parámetro , si tiene una función de masa de probabilidad dada por: [2] : 60

donde

- k es el número de ocurrencias ( )

- e es el número de Euler ( )

- ! es la función factorial .

El número real positivo λ es igual al valor esperado de X y también a su varianza [3]

La distribución de Poisson se puede aplicar a sistemas con una gran cantidad de eventos posibles, cada uno de los cuales es raro . El número de estos eventos que ocurren durante un intervalo de tiempo fijo es, en las circunstancias adecuadas, un número aleatorio con una distribución de Poisson.

La ecuación se puede adaptar si, en lugar del número promedio de eventos , se nos da una tasa de tiempo para el número de eventos que suceden. Luego (mostrando el número de eventos por unidad de tiempo) y

Ejemplo

La distribución de Poisson puede ser útil para modelar eventos como

- La cantidad de meteoritos de más de 1 metro de diámetro que golpean la Tierra en un año.

- El número de pacientes que llegan a una sala de emergencias entre las 10 y las 11 p. M.

- El número de fotones láser que impactan en un detector en un intervalo de tiempo particular.

Supuestos y validez

La distribución de Poisson es un modelo apropiado si se cumplen los siguientes supuestos: [4]

- k es el número de veces que ocurre un evento en un intervalo y k puede tomar valores 0, 1, 2, ....

- La ocurrencia de un evento no afecta la probabilidad de que ocurra un segundo evento. Es decir, los eventos ocurren de forma independiente.

- La tasa promedio a la que ocurren los eventos es independiente de cualquier ocurrencia. Por simplicidad, generalmente se supone que esto es constante, pero en la práctica puede variar con el tiempo.

- Dos eventos no pueden ocurrir exactamente en el mismo instante; en cambio, en cada subintervalo muy pequeño ocurre o no ocurre exactamente un evento.

Si estas condiciones son verdaderas, entonces k es una variable aleatoria de Poisson y la distribución de k es una distribución de Poisson.

La distribución de Poisson también es el límite de una distribución binomial , para la cual la probabilidad de éxito de cada ensayo es igual a λ dividido por el número de ensayos, ya que el número de ensayos se acerca al infinito (consulte Distribuciones relacionadas ).

Ejemplos de probabilidad para distribuciones de Poisson

En un río en particular, las inundaciones por desbordamiento ocurren una vez cada 100 años en promedio. Calcule la probabilidad de k = 0, 1, 2, 3, 4, 5 o 6 inundaciones por desbordamiento en un intervalo de 100 años, asumiendo que el modelo de Poisson es apropiado. Debido a que la tasa promedio de eventos es una inundación por desbordamiento cada 100 años, λ = 1

|

La probabilidad de que se produzcan de 0 a 6 inundaciones por desbordamiento en un período de 100 años. |

Ugarte y sus colegas informan que el número promedio de goles en un partido de fútbol de la Copa del Mundo es aproximadamente 2.5 y el modelo de Poisson es apropiado. [5] Dado que la tasa media de eventos es de 2,5 goles por partido, λ = 2,5.

|

La probabilidad de 0 a 7 goles en un partido. |

Eventos de una vez en un intervalo: el caso especial de λ = 1 y k = 0

Supongamos que los astrónomos estiman que los meteoritos grandes (por encima de cierto tamaño) golpean la Tierra en promedio una vez cada 100 años ( λ = 1 evento cada 100 años), y que el número de impactos de meteoritos sigue una distribución de Poisson. ¿Cuál es la probabilidad de que k = 0 impactos de meteoritos en los próximos 100 años?

Bajo estos supuestos, la probabilidad de que ningún gran meteorito golpee la Tierra en los próximos 100 años es aproximadamente de 0,37. El 1 - 0,37 = 0,63 restante es la probabilidad de que se produzcan 1, 2, 3 o más grandes impactos de meteoritos en los próximos 100 años. En un ejemplo anterior, se produjo una inundación por desbordamiento una vez cada 100 años ( λ = 1). La probabilidad de que no se produzcan inundaciones por desbordamiento en 100 años fue de aproximadamente 0,37, según el mismo cálculo.

En general, si un evento ocurre en promedio una vez por intervalo ( λ = 1), y los eventos siguen una distribución de Poisson, entonces P (0 eventos en el siguiente intervalo) = 0.37 . Además, P (exactamente un evento en el siguiente intervalo) = 0.37, como se muestra en la tabla para inundaciones por desbordamiento.

Ejemplos que violan los supuestos de Poisson

La cantidad de estudiantes que llegan a la unión de estudiantes por minuto probablemente no seguirá una distribución de Poisson, porque la tasa no es constante (tasa baja durante el tiempo de clase, tasa alta entre horas de clase) y las llegadas de estudiantes individuales no son independientes (estudiantes tienden a venir en grupos).

El número de terremotos de magnitud 5 por año en un país puede no seguir una distribución de Poisson si un gran terremoto aumenta la probabilidad de réplicas de magnitud similar.

Los ejemplos en los que al menos un evento está garantizado no son Poission distribuida; pero puede modelarse utilizando una distribución de Poisson truncada en cero .

Las distribuciones de recuento en las que el número de intervalos con eventos cero es mayor que el predicho por un modelo de Poisson pueden modelarse utilizando un modelo inflado por cero .

Propiedades

Estadísticas descriptivas

- El valor esperado y la varianza de una variable aleatoria distribuida por Poisson son ambos iguales a λ.

- El coeficiente de variación es , mientras que el índice de dispersión es 1. [6] : 163

- La desviación absoluta media sobre la media es [6] : 163

- La moda de una variable aleatoria distribuida por Poisson con un número no entero λ es igual a , que es el entero más grande menor o igual que λ . Esto también se escribe como piso (λ). Cuando λ es un número entero positivo, los modos son λ y λ - 1.

- Todos los acumulados de la distribución de Poisson son iguales al valor esperado λ . El n- ésimo momento factorial de la distribución de Poisson es λ n .

- El valor esperado de un proceso de Poisson a veces se descompone en el producto de la intensidad y la exposición (o más generalmente se expresa como la integral de una "función de intensidad" en el tiempo o el espacio, a veces descrita como "exposición"). [7]

Mediana

Los límites de la mediana ( ) de la distribución se conocen y son nítidos : [8]

Momentos superiores

- Los momentos no centrados más altos , m k de la distribución de Poisson, son polinomios de Touchard en λ:

- donde las {llaves} denotan números de Stirling del segundo tipo . [9] [1] : 6 Los coeficientes de los polinomios tienen un significado combinatorio . De hecho, cuando el valor esperado de la distribución de Poisson es 1, entonces la fórmula de Dobinski dice que el n- ésimo momento es igual al número de particiones de un conjunto de tamaño n .

Un límite simple es [10]

Sumas de variables aleatorias distribuidas por Poisson

- Si para son independientes , entonces . [11] : 65 Un inverso es el teorema de Raikov , que dice que si la suma de dos variables aleatorias independientes está distribuida por Poisson, entonces también lo son cada una de esas dos variables aleatorias independientes. [12] [13]

Otras propiedades

- Las distribuciones de Poisson son distribuciones de probabilidad infinitamente divisibles . [14] : 233 [6] : 164

- La divergencia dirigida de Kullback-Leibler de de viene dada por

- Los límites de las probabilidades de cola de una variable aleatoria de Poisson se pueden derivar utilizando un argumento de límite de Chernoff . [15] : 97-98

- ,

- La probabilidad de cola superior se puede ajustar (en un factor de al menos dos) de la siguiente manera: [16]

- donde es la divergencia dirigida de Kullback-Leibler, como se describe arriba.

- Las desigualdades que relacionan la función de distribución de una variable aleatoria de Poisson con la función de distribución normal estándar son las siguientes: [16]

- donde está nuevamente la divergencia dirigida Kullback-Leibler.

Carreras de poisson

Sean y sean variables aleatorias independientes, con , entonces tenemos que

El límite superior se prueba utilizando un límite de Chernoff estándar.

El límite inferior se puede demostrar observando que es la probabilidad de que , donde , que está delimitado por debajo de , donde es la entropía relativa (consulte la entrada sobre los límites en las colas de las distribuciones binomiales para obtener más detalles). Observando además eso , y calculando un límite inferior en la probabilidad incondicional da el resultado. Se pueden encontrar más detalles en el apéndice de Kamath et al. . [17]

Distribuciones relacionadas

General

- Si y son independientes, entonces la diferencia sigue una distribución Skellam .

- Si y son independientes, entonces la distribución de condicional a es una distribución binomial .

- Específicamente, si , entonces .

- De manera más general, si X 1 , X 2 , ..., X n son variables aleatorias de Poisson independientes con parámetros λ 1 , λ 2 , ..., λ n entonces

- dado que sigue eso . De hecho, .

- Si y la distribución de , condicionada a X = k , es una distribución binomial , , entonces la distribución de Y sigue una distribución de Poisson . De hecho, si , condicional a X = k, sigue una distribución multinomial , entonces cada uno sigue una distribución de Poisson independiente .

- La distribución de Poisson se puede derivar como un caso límite para la distribución binomial, ya que el número de ensayos llega al infinito y el número esperado de éxitos permanece fijo; consulte la ley de eventos raros a continuación. Por lo tanto, se puede utilizar como una aproximación de la distribución binomial si n es suficientemente grande y p es suficientemente pequeño. Existe una regla empírica que establece que la distribución de Poisson es una buena aproximación de la distribución binomial si n es al menos 20 yp es menor o igual que 0.05, y una excelente aproximación si n ≥ 100 y np ≤ 10. [18 ]

- La distribución de Poisson es un caso especial de la distribución de Poisson compuesta discreta (o distribución de Poisson tartamudeante) con solo un parámetro. [19] [20] La distribución de Poisson compuesta discreta se puede deducir de la distribución límite de la distribución multinomial univariante. También es un caso especial de una distribución de Poisson compuesta .

- Para valores suficientemente grandes de λ, (digamos λ> 1000), la distribución normal con media λ y varianza λ (desviación estándar ) es una excelente aproximación a la distribución de Poisson. Si λ es mayor que aproximadamente 10, entonces la distribución normal es una buena aproximación si se realiza una corrección de continuidad apropiada , es decir, si P ( X ≤ x ), donde x es un número entero no negativo, se reemplaza por P ( X ≤ x + 0,5).

- Transformación estabilizadora de varianza : Si , entonces

- , [6] : 168

- y

- . [21] : 196

- Bajo esta transformación, la convergencia a la normalidad (a medida que aumenta) es mucho más rápida que la variable no transformada. [ cita requerida ] Otras transformaciones estabilizadoras de varianza, un poco más complicadas, están disponibles, [6] : 168 una de las cuales es la transformada de Anscombe . [22] Consulte Transformación de datos (estadísticas) para conocer los usos más generales de las transformaciones.

- Si para cada t > 0 el número de llegadas en el intervalo de tiempo [0, t ] sigue la distribución de Poisson con media λt , entonces la secuencia de tiempos entre llegadas son variables aleatorias exponenciales independientes e idénticamente distribuidas que tienen media 1 / λ . [23] : 317–319

- Las funciones de distribución acumulada de las distribuciones de Poisson y chi-cuadrado están relacionadas de las siguientes formas: [6] : 167

- y [6] : 158

Aproximación de Poisson

Suponga donde , entonces [24] se distribuye multinomialmente condicionado a .

Esto significa [15] : 101-102 , entre otras cosas, que para cualquier función no negativa , si está distribuida multinomialmente, entonces

donde .

El factor de puede ser reemplazado por 2 si además se supone que aumenta o disminuye monótonamente.

Distribución de Poisson bivariada

Esta distribución se ha extendido al caso bivariado . [25] La función generadora de esta distribución es

con

Las distribuciones marginales son Poisson ( θ 1 ) y Poisson ( θ 2 ) y el coeficiente de correlación se limita al rango

Una forma sencilla de generar una distribución de Poisson bivariada es tomar tres distribuciones de Poisson independientes con medias y luego establecer . La función de probabilidad de la distribución de Poisson bivariada es

Distribución gratuita de Poisson

La distribución de Poisson libre [26] con tamaño de salto y velocidad surge en la teoría de probabilidad libre como el límite de convolución libre repetida

como N → ∞.

En otras palabras, sean variables aleatorias para que tenga valor con probabilidad y valor 0 con la probabilidad restante. Suponga también que la familia es libremente independiente . Entonces, el límite de la ley de está dado por la ley de Poisson libre con parámetros .

Esta definición es análoga a una de las formas en que la distribución de Poisson clásica se obtiene a partir de un proceso de Poisson (clásico).

La medida asociada a la ley de Poisson libre viene dada por [27]

donde

y tiene apoyo .

Esta ley también surge en la teoría de matrices aleatorias como la ley de Marchenko-Pastur . Sus acumulados libres son iguales a .

Algunas transformaciones de esta ley

Damos valores de algunas transformadas importantes de la ley de Poisson libre; el cálculo se puede encontrar, por ejemplo, en el libro Lectures on the Combinatorics of Free Probability por A. Nica y R. Speicher [28]

La transformada R de la ley de Poisson libre está dada por

La transformada de Cauchy (que es el negativo de la transformación de Stieltjes ) está dada por

La transformada S está dada por

en el caso de que .

Inferencia estadística

Estimación de parámetros

Dada una muestra de n valores medidos , para i = 1, ..., n , deseamos estimar el valor del parámetro λ de la población de Poisson de la que se extrajo la muestra. La estimación de máxima verosimilitud es [29]

Dado que cada observación tiene una expectativa λ, también la tiene la media de la muestra. Por lo tanto, la estimación de máxima verosimilitud es un estimador insesgado de λ. También es un estimador eficiente ya que su varianza alcanza el límite inferior de Cramér-Rao (CRLB). [ cita requerida ] Por lo tanto, la varianza mínima es insesgada . También se puede probar que la suma (y por lo tanto la media muestral, ya que es una función uno a uno de la suma) es una estadística completa y suficiente para λ.

Para demostrar la suficiencia, podemos usar el teorema de factorización . Considere dividir la función de masa de probabilidad de la distribución conjunta de Poisson para la muestra en dos partes: una que depende únicamente de la muestra (llamada ) y otra que depende del parámetro y de la muestra solo a través de la función . Entonces es una estadística suficiente para .

El primer término , depende solo de . El segundo término, depende de la muestra solo a través de . Por lo tanto, es suficiente.

Para encontrar el parámetro λ que maximiza la función de probabilidad para la población de Poisson, podemos usar el logaritmo de la función de probabilidad:

Tomamos la derivada de con respecto a λ y la comparamos con cero:

Resolver para λ da un punto estacionario.

Entonces λ es el promedio de los valores de k i . Obtener el signo de la segunda derivada de L en el punto estacionario determinará qué tipo de valor extremo es λ .

Evaluar la segunda derivada en el punto estacionario da:

que es el negativo de n veces el recíproco del promedio de k i . Esta expresión es negativa cuando el promedio es positivo. Si esto se satisface, entonces el punto estacionario maximiza la función de probabilidad.

Para completar , se dice que una familia de distribuciones está completa si y solo si implica eso para todos . Si el individuo es iid , entonces . Conociendo la distribución que queremos investigar, es fácil ver que la estadística está completa.

Para que se mantenga esta igualdad, debe ser 0. Esto se sigue del hecho de que ninguno de los otros términos será 0 para todos en la suma y para todos los valores posibles de . Por lo tanto, para todos implica eso , y se ha demostrado que la estadística es completa.

Intervalo de confianza

El intervalo de confianza para la media de una distribución de Poisson se puede expresar utilizando la relación entre las funciones de distribución acumuladas de las distribuciones de Poisson y chi-cuadrado . La distribución chi-cuadrado está en sí misma estrechamente relacionada con la distribución gamma , y esto conduce a una expresión alternativa. Dada una observación k de una distribución de Poisson con media μ , un intervalo de confianza para μ con nivel de confianza 1 - α es

o equivalente,

donde es la función cuantil (correspondiente a un área de cola inferior p ) de la distribución chi-cuadrado con n grados de libertad y es la función cuantil de una distribución gamma con parámetro de forma n y parámetro de escala 1. [6] : 176-178 [30] Este intervalo es " exacto " en el sentido de que su probabilidad de cobertura nunca es menor que el nominal 1 - α .

Cuando no se dispone de cuantiles de la distribución gamma, se ha propuesto una aproximación precisa a este intervalo exacto (basada en la transformación de Wilson-Hilferty ): [31]

donde denota la desviación normal estándar con el área superior de la cola α / 2 .

Para la aplicación de estas fórmulas en el mismo contexto que el anterior (dada una muestra de n valores medidos k i cada uno extraído de una distribución de Poisson con media λ ), se establecería

calcule un intervalo para μ = nλ , y luego derive el intervalo para λ .

Inferencia bayesiana

En la inferencia bayesiana , el conjugado previo para el parámetro de velocidad λ de la distribución de Poisson es la distribución gamma . [32] Deja

denotan que λ se distribuye de acuerdo con la densidad gamma g parametrizada en términos de un parámetro de forma α y un parámetro de escala inversa β :

Entonces, dada la misma muestra de n valores medidos k i que antes , y una previa de Gamma ( α , β ), la distribución posterior es

La media posterior E [ λ ] se aproxima a la estimación de máxima verosimilitud en el límite como , que se deriva inmediatamente de la expresión general de la media de la distribución gamma .

La distribución predictiva posterior para una única observación adicional es una distribución binomial negativa , [33] : 53 a veces denominada distribución gamma-Poisson.

Estimación simultánea de múltiples medias de Poisson

Supongamos que es un conjunto de variables aleatorias independientes de un conjunto de distribuciones de Poisson, cada uno con un parámetro , y nos gustaría para estimar estos parámetros. Entonces, Clevenson y Zidek muestran que bajo la pérdida de error cuadrático normalizado , cuando , entonces, similar al ejemplo de Stein para las medias normales, el estimador MLE es inadmisible . [34]

En este caso, se da una familia de estimadores minimax para cualquier y como [35]

Ocurrencia y aplicaciones

Este artículo necesita citas adicionales para su verificación . ( diciembre de 2019 ) |

Las aplicaciones de la distribución de Poisson se pueden encontrar en muchos campos, entre ellos: [36]

- Ejemplo de telecomunicaciones : llamadas telefónicas que llegan a un sistema.

- Ejemplo de astronomía : fotones que llegan a un telescopio.

- Ejemplo de química : la distribución de masa molar de una polimerización viva . [37]

- Ejemplo de biología : el número de mutaciones en una hebra de ADN por unidad de longitud.

- Ejemplo de gestión : clientes que llegan a un mostrador o centro de llamadas.

- Ejemplo de finanzas y seguros : número de pérdidas o reclamaciones que se producen en un período de tiempo determinado.

- Ejemplo de sismología de terremotos : un modelo asintótico de Poisson de riesgo sísmico para grandes terremotos. [38]

- Ejemplo de radiactividad : número de desintegraciones en un intervalo de tiempo determinado en una muestra radiactiva.

- Ejemplo de óptica : el número de fotones emitidos en un solo pulso de láser. Esta es una vulnerabilidad importante para la mayoría de los protocolos de distribución de claves de Quantum , conocida como división de números de fotones (PNS).

La distribución de Poisson surge en relación con los procesos de Poisson. Se aplica a varios fenómenos de propiedades discretas (es decir, aquellos que pueden suceder 0, 1, 2, 3, ... veces durante un período de tiempo determinado o en un área determinada) siempre que la probabilidad de que ocurra el fenómeno es constante en tiempo o espacio . Ejemplos de eventos que pueden modelarse como una distribución de Poisson incluyen:

- El número de soldados muertos por patadas de caballo cada año en cada cuerpo de la caballería prusiana . Este ejemplo fue utilizado en un libro por Ladislaus Bortkiewicz (1868-1931). [39] : 23-25

- El número de células de levadura que se utilizan al elaborar cerveza Guinness . Este ejemplo fue utilizado por William Sealy Gosset (1876-1937). [40] [41]

- La cantidad de llamadas telefónicas que llegan a un centro de llamadas en un minuto. Este ejemplo fue descrito por AK Erlang (1878-1929). [42]

- Tráfico de internet.

- El número de goles en deportes que involucran a dos equipos en competencia. [43]

- El número de muertes por año en un grupo de edad determinado.

- El número de saltos en el precio de una acción en un intervalo de tiempo determinado.

- Bajo un supuesto de homogeneidad , el número de veces que se accede a un servidor web por minuto.

- El número de mutaciones en un tramo determinado de ADN después de cierta cantidad de radiación.

- La proporción de células que se infectarán con una multiplicidad de infección determinada .

- La cantidad de bacterias en una determinada cantidad de líquido. [44]

- La llegada de fotones a un circuito de píxeles con una iluminación determinada y durante un período de tiempo determinado.

- El objetivo de las bombas voladoras V-1 en Londres durante la Segunda Guerra Mundial investigado por RD Clarke en 1946. [45]

Gallagher demostró en 1976 que el conteo de números primos en intervalos cortos obedece a una distribución de Poisson [46] proporcionó una cierta versión de la conjetura de tupla r-tupla de primos no demostrados de Hardy-Littlewood [47] es verdadera.

Ley de eventos raros

La tasa de un evento está relacionada con la probabilidad de que ocurra un evento en algún pequeño subintervalo (de tiempo, espacio o de otro modo) [ aclaración necesaria ] . En el caso de la distribución de Poisson [se necesita aclaración ] , se asume que existe un subintervalo lo suficientemente pequeño para el cual la probabilidad de que un evento ocurra dos veces es "insignificante". Con esta suposición, se puede derivar la distribución de Poisson a partir de la Binomial, dada solo la información del número esperado de eventos totales en todo el intervalo [ aclaración necesaria ] .

Sea el número total de eventos en todo el intervalo denotado por . Divida todo el intervalo en subintervalos de igual tamaño, de modo que > (dado que estamos interesados en solo porciones muy pequeñas del intervalo, esta suposición es significativa [se necesita aclaración ] ). Esto significa que el número esperado de eventos en cada uno de los n subintervalos es igual a .

Ahora [se necesita aclaración ] asumimos que la ocurrencia de un evento [se necesita aclaración ] en todo el intervalo puede verse como una secuencia de n ensayos de Bernoulli , donde el ensayo de Bernoulli corresponde a observar si un evento ocurre en el subintervalo con probabilidad . El número esperado de eventos totales en tales ensayos sería el número esperado de eventos totales en todo el intervalo. Por lo tanto, para cada subdivisión del intervalo, hemos aproximado la ocurrencia del evento [ aclaración necesaria ] como un proceso de Bernoulli de la forma . Como hemos señalado antes [se necesita aclaración ] queremos considerar solo subintervalos muy pequeños. Por lo tanto, tomamos el límite como va al infinito.

En este caso, la distribución binomial converge a lo que se conoce como distribución de Poisson por el teorema del límite de Poisson .

En varios de los ejemplos anteriores [se necesita aclaración ] , como el número de mutaciones en una secuencia determinada de ADN, los eventos que se cuentan son en realidad los resultados de ensayos discretos y, con más precisión, [se necesita aclaración ] se modelarían utilizando el binomio distribución , es decir

En tales casos, n es muy grande y p es muy pequeño (por lo que la expectativa np es de magnitud intermedia). Entonces la distribución puede ser aproximada por la distribución de Poisson menos engorrosa [ cita requerida ]

Esta aproximación a veces se conoce como la ley de los eventos raros , [48] : 5 ya que cada uno de los n eventos individuales de Bernoulli rara vez ocurre.

El nombre "ley de eventos raros" puede ser engañoso porque el recuento total de eventos exitosos en un proceso de Poisson no necesita ser raro si el parámetro np no es pequeño. Por ejemplo, el número de llamadas telefónicas a una centralita ocupada en una hora sigue una distribución de Poisson con los eventos que le parecen frecuentes al operador, pero son raros desde el punto de vista del miembro promedio de la población que es muy poco probable que lo haga. una llamada a esa centralita a esa hora.

La varianza de la distribución binomial es 1 - p veces la de la distribución de Poisson, por lo que es casi igual cuando p es muy pequeño.

La palabra ley se usa a veces como sinónimo de distribución de probabilidad , y convergencia en ley significa convergencia en distribución . En consecuencia, la distribución de Poisson a veces se denomina "ley de los números pequeños" porque es la distribución de probabilidad del número de ocurrencias de un evento que ocurre raramente pero que tiene muchas oportunidades de ocurrir. La ley de los números pequeños es un libro de Ladislaus Bortkiewicz sobre la distribución de Poisson, publicado en 1898. [39] [49]

Proceso de punto de Poisson

La distribución de Poisson surge como el número de puntos de un proceso de puntos de Poisson ubicados en alguna región finita. Más específicamente, si D es un espacio de región, por ejemplo, el espacio euclidiano R d , para el cual | D |, el área, el volumen o, más generalmente, la medida de Lebesgue de la región es finita, y si N ( D ) denota el número de puntos en D , entonces

Regresión de Poisson y regresión binomial negativa

La regresión de Poisson y la regresión binomial negativa son útiles para análisis donde la variable dependiente (respuesta) es el recuento (0, 1, 2, ...) del número de eventos o ocurrencias en un intervalo.

Otras aplicaciones en ciencia

En un proceso de Poisson, el número de ocurrencias observadas fluctúa alrededor de su media λ con una desviación estándar . Estas fluctuaciones se denominan ruido de Poisson o (particularmente en electrónica) ruido de disparo .

La correlación de la media y la desviación estándar al contar ocurrencias discretas independientes es útil científicamente. Al monitorear cómo varían las fluctuaciones con la señal media, se puede estimar la contribución de una sola ocurrencia, incluso si esa contribución es demasiado pequeña para ser detectada directamente . Por ejemplo, la carga e de un electrón puede estimarse correlacionando la magnitud de una corriente eléctrica con su ruido de disparo . Si N electrones pasan por un punto en un tiempo determinado t en promedio, la corriente media es ; ya que las fluctuaciones actuales deben ser del orden (es decir, la desviación estándar de laProceso de Poisson ), la carga se puede estimar a partir de la relación . [ cita requerida ]

Un ejemplo cotidiano es la granulosidad que aparece a medida que se amplían las fotografías; la granulosidad se debe a las fluctuaciones de Poisson en el número de granos de plata reducidos , no a los granos individuales en sí. Al correlacionar la granulosidad con el grado de agrandamiento, se puede estimar la contribución de un grano individual (que de otra manera sería demasiado pequeño para verse sin ayuda). [ cita requerida ] Se han desarrollado muchas otras aplicaciones moleculares del ruido de Poisson, por ejemplo, la estimación de la densidad numérica de moléculas receptoras en una membrana celular .

En la teoría de conjuntos causales , los elementos discretos del espacio-tiempo siguen una distribución de Poisson en el volumen.

Métodos computacionales

La distribución de Poisson plantea dos tareas diferentes para las bibliotecas de software dedicadas: evaluar la distribución y extraer números aleatorios de acuerdo con esa distribución.

Evaluación de la distribución de Poisson

Calcular para dado y es una tarea trivial que se puede lograr utilizando la definición estándar de en términos de funciones exponenciales, de potencia y factoriales. Sin embargo, la definición convencional de la distribución de Poisson contiene dos términos que pueden desbordarse fácilmente en las computadoras: λ k y k ! La fracción de λ k a k ! también puede producir un error de redondeo muy grande en comparación con e −λ y, por lo tanto, dar un resultado erróneo. Por lo tanto, para la estabilidad numérica, la función de masa de probabilidad de Poisson debe evaluarse como

que es matemáticamente equivalente pero numéricamente estable. El logaritmo natural de la función Gamma se puede obtener usando la lgammafunción en la biblioteca estándar C (versión C99) o R , la gammalnfunción en MATLAB o SciPy , o la log_gammafunción en Fortran 2008 y posteriores.

Algunos lenguajes de computación proporcionan funciones integradas para evaluar la distribución de Poisson, a saber

- R : función

dpois(x, lambda); - Excel : función

POISSON( x, mean, cumulative), con una bandera para especificar la distribución acumulativa; - Mathematica : distribución de Poisson univariado como , [50] distribución bivariante Poisson como ,. [51]

PoissonDistribution[]MultivariatePoissonDistribution[,{ , }]

Dibujo aleatorio de la distribución de Poisson

La tarea menos trivial es extraer números enteros aleatorios de la distribución de Poisson con dado .

Las soluciones son proporcionadas por:

- R : función

rpois(n, lambda); - Biblioteca científica GNU (GSL): función gsl_ran_poisson

Generación de variables aleatorias distribuidas por Poisson

Knuth ha proporcionado un algoritmo simple para generar números aleatorios distribuidos por Poisson ( muestreo de números pseudoaleatorios ) : [52] : 137-138

algoritmo número aleatorio de Poisson (Knuth) : init : Sea L ← e −λ , k ← 0 yp ← 1. hacer : k ← k + 1. Genere un número aleatorio uniforme u en [0,1] y sea p ← p × u. mientras que p> L. devuelve k - 1.

La complejidad es lineal en el valor devuelto k , que es λ en promedio. Hay muchos otros algoritmos para mejorar esto. Algunos se dan en Ahrens & Dieter, ver § Referencias a continuación.

Para valores grandes de λ, el valor de L = e −λ puede ser tan pequeño que es difícil de representar. Esto se puede resolver mediante un cambio en el algoritmo que utiliza un parámetro adicional STEP de modo que e −STEP no se desborde : [ cita requerida ]

algoritmo número aleatorio de Poisson (Junhao, basado en Knuth) : init : Let λLeft ← λ, k ← 0 yp ← 1. hacer : k ← k + 1. Genere un número aleatorio uniforme u en (0,1) y sea p ← p × u. while p <1 y λLeft> 0: si λLeft> PASO: p ← p × e PASO λ Izquierda ← λ Izquierda - PASO otra cosa : p ← p × e λ Izquierda λ Izquierda ← 0 mientras que p> 1. devuelve k - 1.

La elección de STEP depende del umbral de desbordamiento. Para el formato de coma flotante de doble precisión, el umbral está cerca de e 700 , por lo que 500 será un PASO seguro .

Otras soluciones para valores grandes de λ incluyen el muestreo de rechazo y el uso de la aproximación gaussiana.

El muestreo por transformada inversa es simple y eficiente para valores pequeños de λ, y requiere solo un número aleatorio uniforme u por muestra. Las probabilidades acumuladas se examinan sucesivamente hasta que una excede u .

algoritmo generador de Poisson basado en la inversión por búsqueda secuencial : [53] : 505 init : Sea x ← 0, p ← e −λ , s ← p. Genere un número aleatorio uniforme u en [0,1]. mientras que ustedes hacen : x ← x + 1. p ← p × λ / x. s ← s + p. devuelve x.Historia

La distribución fue introducida por primera vez por Siméon Denis Poisson (1781-1840) y publicada junto con su teoría de la probabilidad en su obra Recherches sur la probabilité des jugements en matière criminelle et en matière civile (1837). [54] : 205-207 El trabajo teorizó sobre el número de condenas injustas en un país dado al enfocarse en ciertas variables aleatorias N que cuentan, entre otras cosas, el número de ocurrencias discretas (a veces llamadas "eventos" o "llegadas") que tienen lugar durante un intervalo de tiempo de duración determinada. El resultado ya lo había dado en 1711 Abraham de Moivre enDe Mensura Sortis seu; de Probabilitate Eventuum en Ludis a Casu Fortuito Pendentibus . [55] : 219 [56] : 14-15 [57] : 193 [6] : 157 Esto lo convierte en un ejemplo de la ley de Stigler y ha llevado a algunos autores a argumentar que la distribución de Poisson debería llevar el nombre de de Moivre. [58] [59]

En 1860, Simon Newcomb ajustó la distribución de Poisson al número de estrellas encontradas en una unidad de espacio. [60] Ladislaus Bortkiewicz hizo una aplicación práctica adicional de esta distribución en 1898 cuando se le dio la tarea de investigar el número de soldados en el ejército prusiano muertos accidentalmente por patadas de caballo; [39] : 23-25 este experimento introdujo la distribución de Poisson en el campo de la ingeniería de confiabilidad .

Ver también

- Distribución de Poisson compuesta

- Distribución de Conway-Maxwell-Poisson

- Distribución de Erlang

- Distribución de Hermite

- Índice de dispersión

- Distribución binomial negativa

- Aglomeración de Poisson

- Proceso de punto de Poisson

- Regresión de Poisson

- Muestreo de Poisson

- Onda de Poisson

- Teoría de las colas

- Teoría de la renovación

- Lema de Robbins

- Distribución de Skellam

- Distribución Tweedie

- Modelo inflado cero

- Distribución de Poisson truncada en cero

Referencias

Citas

- ^ a b Haight, Frank A. (1967), Manual de distribución de Poisson , Nueva York, NY, EE. UU .: John Wiley & Sons, ISBN 978-0-471-33932-8

- ^ Yates, Roy D .; Goodman, David J. (2014), Probability and Stochastic Processes: A Friendly Introduction for Electrical and Computer Engineers (2a ed.), Hoboken, EE.UU .: Wiley, ISBN 978-0-471-45259-1

- ^ Para la prueba, consulte: Wiki de prueba: expectativa y wiki de prueba: varianza

- ^ Koehrsen, William (20 de enero de 2019), Explicación del proceso de distribución y Poisson de Poisson , Hacia la ciencia de datos , consultado el 19 de septiembre de 2019

- ^ Ugarte, Maria Dolores; Militino, Ana F .; Arnholt, Alan T. (2016), Probability and Statistics with R (Segunda ed.), Boca Raton, FL, EE. UU .: CRC Press, ISBN 978-1-4665-0439-4

- ^ a b c d e f g h i Johnson, Norman L .; Kemp, Adrienne W .; Kotz, Samuel (2005), "Distribución de Poisson", Distribuciones discretas univariadas (3ª ed.), Nueva York, NY, EE. UU .: John Wiley & Sons, Inc., págs. 156–207, doi : 10.1002 / 0471715816 , ISBN 978-0-471-27246-5

- ↑ Helske, Jouni (2017). "KFAS: modelos de espacio de estado familiar exponencial en R". Revista de software estadístico . 78 (10). arXiv : 1612.01907 . doi : 10.18637 / jss.v078.i10 . S2CID 14379617 .

- ^ Choi, Kwok P. (1994), "Sobre las medianas de las distribuciones gamma y una ecuación de Ramanujan", Proceedings of the American Mathematical Society , 121 (1): 245-251, doi : 10.2307 / 2160389 , JSTOR 2160389

- ^ Riordan, John (1937), "Relaciones de recurrencia de momento para distribuciones de frecuencia binomial, de Poisson e hipergeométrica" (PDF) , Annals of Mathematical Statistics , 8 (2): 103-111, doi : 10.1214 / aoms / 1177732430 , JSTOR 2957598

- ↑ D. Ahle, Thomas (31 de marzo de 2021). "Límites agudos y simples para los momentos crudos de las distribuciones binomial y de Poisson". arXiv : 2103.17027 [ math.PR ].

- ^ Lehmann, Erich Leo (1986), Testing Statistical Hypotheses (segunda ed.), Nueva York, Nueva Jersey, EE. UU.: Springer Verlag, ISBN 978-0-387-94919-2

- ↑ Raikov, Dmitry (1937), "Sobre la descomposición de las leyes de Poisson", Comptes Rendus de l'Académie des Sciences de l'URSS , 14 : 9-11

- ^ von Mises, Richard (1964), Teoría matemática de probabilidad y estadística , Nueva York, Nueva Jersey, EE. UU .: Academic Press, doi : 10.1016 / C2013-0-12460-9 , ISBN 978-1-4832-3213-3

- ^ Laha, Radha G .; Rohatgi, Vijay K. (1979), Probability Theory , Nueva York, Nueva Jersey, EE.UU .: John Wiley & Sons, ISBN 978-0-471-03262-5

- ↑ a b Mitzenmacher, Michael ; Upfal, Eli (2005), Probability and Computing: Randomized Algorithms and Probabilistic Analysis , Cambridge, Reino Unido: Cambridge University Press, ISBN 978-0-521-83540-4

- ^ a b Short, Michael (2013), "Desigualdades mejoradas para las funciones de distribución binomial y de Poisson y cuantil de cola superior", ISRN Probability and Statistics , 2013 : 412958, doi : 10.1155 / 2013/412958

- ^ Kamath, Govinda M .; Şaşoğlu, Eren; Tse, David (2015), "Optimal Haplotype Assembly from High-Throughput Mate-Pair Reads", Simposio internacional de IEEE sobre teoría de la información (ISIT) 2015, 14-19 de junio , Hong Kong, China, págs. 914-918, arXiv : 1502.01975 , doi : 10.1109 / ISIT.2015.7282588 , S2CID 128634

- ^ Prins, Jack (2012), "6.3.3.1. Cuadros de control de recuentos" , e-Handbook of Statistical Methods , NIST / SEMATECH , consultado el 20 de septiembre de 2019

- ^ Zhang, Huiming; Liu, Yunxiao; Li, Bo (2014), "Notas sobre el modelo de Poisson compuesto discreto con aplicaciones a la teoría del riesgo", Seguros: Matemáticas y economía , 59 : 325–336, doi : 10.1016 / j.insmatheco.2014.09.012

- ^ Zhang, Huiming; Li, Bo (2016), "Caracterizaciones de distribuciones de Poisson compuestas discretas", Comunicaciones en estadística - Teoría y métodos , 45 (22): 6789–6802, doi : 10.1080 / 03610926.2014.901375 , S2CID 125475756

- ^ McCullagh, Peter ; Nelder, John (1989), Modelos lineales generalizados , Monografías sobre estadística y probabilidad aplicada, 37 , Londres, Reino Unido: Chapman y Hall, ISBN 978-0-412-31760-6

- ^ Anscombe, Francis J. (1948), "La transformación de Poisson, datos binomiales y binomiales negativos", Biometrika , 35 (3-4): 246-254, doi : 10.1093 / biomet / 35.3-4.246 , JSTOR 2332343

- ^ Ross, Sheldon M. (2010), Introducción a los modelos de probabilidad (décima ed.), Boston, MA, Estados Unidos: Academic Press, ISBN 978-0-12-375686-2

- ^ "1.7.7 - Relación entre Multinomial y Poisson | STAT 504" .

- ^ Loukas, Sotirios; Kemp, C. David (1986), "The Index of Dispersion Test for the Bivariate Poisson Distribution", Biometrics , 42 (4): 941–948, doi : 10.2307 / 2530708 , JSTOR 2530708

- ^ Variables aleatorias libres por D. Voiculescu, K. Dykema, A. Nica, Serie de monografías CRM, American Mathematical Society, Providence RI, 1992

- ^ James A. Mingo, Roland Speicher: Probabilidad libre y matrices aleatorias. Monografías del Fields Institute, vol. 35, Springer, Nueva York, 2017.

- ^ Conferencias sobre la combinatoria de la probabilidad libre por A. Nica y R. Speicher, págs. 203-204, Cambridge Univ. Prensa 2006

- ^ Paszek, Ewa. "Estimación de máxima verosimilitud - Ejemplos" .

- ^ Garwood, Frank (1936), "Límites de referencia para la distribución de Poisson", Biometrika , 28 (3/4): 437–442, doi : 10.1093 / biomet / 28.3-4.437 , JSTOR 2333958

- ^ Breslow, Norman E .; Day, Nick E. (1987), Métodos estadísticos en la investigación del cáncer: Volumen 2 — El diseño y análisis de estudios de cohortes , Lyon, Francia: Agencia Internacional para la Investigación del Cáncer , ISBN 978-92-832-0182-3, Archivado desde el original en 08/08/2018 , recuperado 2012-03-11

- ^ Fink, Daniel (1997), Un compendio de priores conjugados

- ^ Gelman; Carlin, John B .; Stern, Hal S .; Rubin, Donald B. (2003), Análisis de datos bayesianos (2a ed.), Boca Raton, FL, EE. UU .: Chapman & Hall / CRC, ISBN 1-58488-388-X

- ^ Clevenson, M. Lawrence; Zidek, James V. (1975), "Estimación simultánea de los medios de las leyes de Poisson independientes", Journal of the American Statistical Association , 70 (351): 698–705, doi : 10.1080 / 01621459.1975.10482497 , JSTOR 2285958

- ^ Berger, James O. (1985), Teoría de la decisión estadística y análisis bayesiano , Springer Series in Statistics (2a ed.), Nueva York, NJ, EE. UU .: Springer-Verlag, Bibcode : 1985sdtb.book ..... B , doi : 10.1007 / 978-1-4757-4286-2 , ISBN 978-0-387-96098-2

- ^ Rasch, Georg (1963), "El proceso de Poisson como modelo para una diversidad de fenómenos conductuales" (PDF) , XVII Congreso Internacional de Psicología , 2 , Washington, DC, EE. UU., 20 al 26 de agosto de 1963: Asociación Americana de Psicología , doi : 10.1037 / e685262012-108 Mantenimiento de CS1: ubicación ( enlace )

- ^ Flory, Paul J. (1940), "Distribución de tamaño molecular en polímeros de óxido de etileno", Revista de la Sociedad Química Estadounidense , 62 (6): 1561-1565, doi : 10.1021 / ja01863a066

- ^ Lomnitz, Cinna (1994), Fundamentos de la predicción de terremotos , Nueva York: John Wiley & Sons, ISBN 0-471-57419-8, OCLC 647404423

- ↑ a b c von Bortkiewitsch, Ladislaus (1898), Das Gesetz der kleinen Zahlen [ La ley de los números pequeños ] (en alemán), Leipzig, Alemania: B. G. Teubner, p. En la página 1 , Bortkiewicz presenta la distribución de Poisson. En las páginas 23-25 , Bortkiewitsch presenta su análisis de "4. Beispiel: Die durch Schlag eines Pferdes im preußischen Heere Getöteten". (4. Ejemplo: los que murieron en el ejército prusiano por la patada de un caballo).

- ^ Estudiante (1907), "Sobre el error de contar con un hemacitómetro" , Biometrika , 5 (3): 351–360, doi : 10.2307 / 2331633 , JSTOR 2331633

- ^ Boland, Philip J. (1984), "Un vistazo biográfico de William Sealy Gosset", The American Statistician , 38 (3): 179-183, doi : 10.1080 / 00031305.1984.10483195 , JSTOR 2683648

- ^ Erlang, Agner K. (1909), "Sandsynlighedsregning og Telefonsamtaler" [Cálculo de probabilidades y conversaciones telefónicas], Nyt Tidsskrift para Matematik (en danés), 20 (B): 33-39, JSTOR 24528622

- ^ Hornby, Dave (2014), modelo de predicción de fútbol: distribución de Poisson , apuestas deportivas en línea , consultado el 19 de septiembre de 2014

- ^ Koyama, Kento; Hokunan, Hidekazu; Hasegawa, Mayumi; Kawamura, Shuso; Koseki, Shigenobu (2016), "¿Los números de células bacterianas siguen una distribución teórica de Poisson? Comparación de números de células individuales obtenidos experimentalmente con generación de números aleatorios mediante simulación por computadora", Food Microbiology , 60 : 49–53, doi : 10.1016 / j. fm.2016.05.019 , PMID 27554145

- ^ Clarke, RD (1946), "Una aplicación de la distribución de Poisson" (PDF) , Revista del Instituto de Actuarios , 72 (3): 481, doi : 10.1017 / S0020268100035435

- ^ Gallagher, Patrick X. (1976), "Sobre la distribución de números primos en intervalos cortos", Mathematika , 23 (1): 4-9, doi : 10.1112 / s0025579300016442

- ^ Hardy, Godfrey H .; Littlewood, John E. (1923), "Sobre algunos problemas de" partitio numerorum "III: Sobre la expresión de un número como suma de primos", Acta Mathematica , 44 : 1–70, doi : 10.1007 / BF02403921

- ^ Cameron, A. Colin; Trivedi, Pravin K. (1998), Análisis de regresión de datos de recuento , Cambridge, Reino Unido: Cambridge University Press, ISBN 978-0-521-63567-7

- ^ Edgeworth, Francis Y. (1913), "Sobre el uso de la teoría de probabilidades en las estadísticas relativas a la sociedad" , Revista de la Royal Statistical Society , 76 (2): 165-193, doi : 10.2307 / 2340091 , JSTOR 2340091

- ^ "Wolfram Language: página de referencia de PoissonDistribution" . wolfram.com . Consultado el 8 de abril de 2016 .

- ^ "Wolfram Language: página de referencia MultivariatePoissonDistribution" . wolfram.com . Consultado el 8 de abril de 2016 .

- ^ Knuth, Donald Ervin (1997), Algoritmos seminuméricos , El arte de la programación informática , 2 (3.a ed.), Addison Wesley , ISBN 978-0-201-89684-8

- ^ Devroye, Luc (1986), "Distribuciones univariadas discretas" (PDF) , Generación variable aleatoria no uniforme , Nueva York, Nueva Jersey, EE. UU.: Springer-Verlag, págs. 485–553, doi : 10.1007 / 978-1-4613 -8643-8_10 , ISBN 978-1-4613-8645-2

- ^ Poisson, Siméon D. (1837), Probabilité des jugements en matière criminelle et en matière civile, précédées des règles générales du calcul des probabilités [ Investigación sobre la probabilidad de sentencias en materia penal y civil ] (en francés), París, Francia : Soltero

- ↑ de Moivre, Abraham (1711), "De mensura sortis, seu, de probabilitate eventuum in ludis a casu fortuito pendentibus" [Sobre la medición del azar, o sobre la probabilidad de eventos en juegos que dependen del azar], Transacciones filosóficas of the Royal Society (en latín), 27 (329): 213–264, doi : 10.1098 / rstl.1710.0018

- ↑ de Moivre, Abraham (1718), The Doctrine of Chances: Or, A Method of Calculating the Probability of Events in Play , Londres, Gran Bretaña: W. Pearson, ISBN 9780598843753

- ↑ de Moivre, Abraham (1721), "De las leyes del azar", en Motte, Benjamin (ed.), Las transacciones filosóficas desde el año MDCC (donde termina el Sr. Lowthorp) hasta el año MDCCXX. Abridg'd, and Dispos'd Under General Heads (en latín), vol. I, Londres, Gran Bretaña: R. Wilkin, R. Robinson, S. Ballard, W. y J. Innys, y J. Osborn, págs. 190–219

|volume=tiene texto extra ( ayuda ) - ^ Stigler, Stephen M. (1982), "Poisson sobre la distribución de Poisson", Estadísticas y letras de probabilidad , 1 (1): 33-35, doi : 10.1016 / 0167-7152 (82) 90010-4

- ^ Hald, Anders; de Moivre, Abraham; McClintock, Bruce (1984), "A. de Moivre: 'De Mensura Sortis' or 'On the Measurement of Chance ' ", International Statistical Review / Revue Internationale de Statistique , 52 (3): 229-262, doi : 10.2307 / 1403045 , JSTOR 1403045

- ^ Newcomb, Simon (1860), "Notas sobre la teoría de probabilidades" , The Mathematical Monthly , 2 (4): 134-140

Fuentes

- Ahrens, Joachim H .; Dieter, Ulrich (1974), "Métodos informáticos para el muestreo de distribuciones gamma, beta, Poisson y binomial", Computación , 12 (3): 223–246, doi : 10.1007 / BF02293108 , S2CID 37484126

- Ahrens, Joachim H .; Dieter, Ulrich (1982), "Computer Generation of Poisson Deviates", ACM Transactions on Mathematical Software , 8 (2): 163-179, doi : 10.1145 / 355993.355997 , S2CID 12410131

- Evans, Ronald J .; Boersma, J .; Blachman, NM; Jagers, AA (1988), "La entropía de una distribución de Poisson: Problema 87-6" , Revisión de SIAM , 30 (2): 314–317, doi : 10.1137 / 1030059

- distribución de veneno

- Distribuciones previas conjugadas

- Temas factoriales y binomiales

- Distribuciones de probabilidad infinitamente divisibles

![\ lambda [1- \ log (\ lambda)] + e ^ {- \ lambda} \ sum _ {k = 0} ^ {\ infty} {\ frac {\ lambda ^ {k} \ log (k!)} {k!}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cf6cf37058d59e89453fd5bf9a1ece59a8c81d1a)

![{\ Displaystyle \ exp [\ lambda (e ^ {t} -1)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/37f90da880784209b7d467c2ee82a15ef35544bd)

![{\ Displaystyle \ exp [\ lambda (e ^ {it} -1)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/827b1fc5eade6309eb6c3847ef256b239d3d046b)

![{\ Displaystyle \ exp [\ lambda (z-1)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ba700aec4d72e190d3991306786e0cfc0cf2e40e)

![{\ Displaystyle \ operatorname {E} [| X- \ lambda |] = {\ frac {2 \ lambda ^ {\ lfloor \ lambda \ rfloor +1} e ^ {- \ lambda}} {\ lfloor \ lambda \ rfloor !}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2d2a28e8d0c95b951904e617de82eb5ab5d74155)

![{\ Displaystyle m_ {k} = E [X ^ {k}] \ leq \ left ({\ frac {k} {\ log (k / \ lambda +1)}} \ right) ^ {k} \ leq \ lambda ^ {k} \ exp (k ^ {2} / (2 \ lambda)).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/70081f1f5a8e965418a59a8f5c199e8ebb462c88)

![{\ Displaystyle \ operatorname {E} [f (Y_ {1}, Y_ {2}, \ dots, Y_ {n})] \ leq e {\ sqrt {m}} \ operatorname {E} [f (X_ { 1}, X_ {2}, \ puntos, X_ {n})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2d196f4817af3673334cad96f9aa090d2ae3cb7e)

![g (u, v) = \ exp [(\ theta _ {1} - \ theta _ {12}) (u-1) + (\ theta _ {2} - \ theta _ {12}) (v-1 ) + \ theta _ {12} (uv-1)]](https://wikimedia.org/api/rest_v1/media/math/render/svg/0d994b2c4f3b36c80cfd0b97ed72fe289c0855d4)

![[\ alpha (1- \ sqrt {\ lambda}) ^ 2, \ alpha (1+ \ sqrt {\ lambda}) ^ 2]](https://wikimedia.org/api/rest_v1/media/math/render/svg/e4f29bfa6afda41f2042de51314c69ffa22c703c)

![{\ Displaystyle \! f (k; \ lambda) = \ exp \ left [k \ ln \ lambda - \ lambda - \ ln \ Gamma (k + 1) \ right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83a8a374612dfba5c3e699450970a5b2330925c3)