Regresión lineal

En estadística , la regresión lineal es un enfoque lineal para modelar la relación entre una respuesta escalar y una o más variables explicativas (también conocidas como variables dependientes e independientes ). El caso de una variable explicativa se llama regresión lineal simple ; para más de uno, el proceso se denomina regresión lineal múltiple . [1] Este término es distinto de la regresión lineal multivariante , donde se predicen múltiples variables dependientes correlacionadas , en lugar de una sola variable escalar. [2]

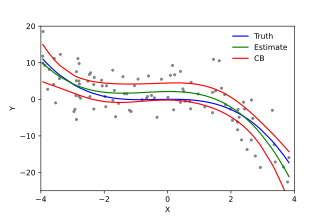

En la regresión lineal, las relaciones se modelan utilizando funciones de predicción lineal cuyos parámetros de modelo desconocidos se estiman a partir de los datos . Estos modelos se denominan modelos lineales . [3] Más comúnmente, se supone que la media condicional de la respuesta dados los valores de las variables explicativas (o predictores) es una función afín de esos valores; con menos frecuencia, se utiliza la mediana condicional o algún otro cuantil . Como todas las formas de análisis de regresión , la regresión lineal se centra en la distribución de probabilidad condicionalde la respuesta dados los valores de los predictores, en lugar de la distribución de probabilidad conjunta de todas estas variables, que es el dominio del análisis multivariado .

La regresión lineal fue el primer tipo de análisis de regresión que se estudió rigurosamente y se utilizó ampliamente en aplicaciones prácticas. [4] Esto se debe a que los modelos que dependen linealmente de sus parámetros desconocidos son más fáciles de ajustar que los modelos que no están relacionados linealmente con sus parámetros y porque las propiedades estadísticas de los estimadores resultantes son más fáciles de determinar.

La regresión lineal tiene muchos usos prácticos. La mayoría de las aplicaciones se incluyen en una de las siguientes dos categorías generales:

Los modelos de regresión lineal a menudo se ajustan utilizando el enfoque de mínimos cuadrados , pero también pueden ajustarse de otras formas, como minimizando la "falta de ajuste" en alguna otra norma (como con la regresión de desviaciones mínimas absolutas ), o minimizando una penalización. versión de la función de costo de mínimos cuadrados como en la regresión de la cresta ( penalización normal L 2 ) y lazo ( penalización normal L 1 ). Por el contrario, el enfoque de mínimos cuadrados se puede utilizar para ajustar modelos que no son modelos lineales. Por tanto, aunque los términos "mínimos cuadrados" y "modelo lineal" están estrechamente relacionados, no son sinónimos.

Dado un conjunto de datos de n unidades estadísticas , un modelo de regresión lineal supone que la relación entre la variable dependiente y y el vector p de los regresores x es lineal . Esta relación se modela a través de un término de perturbación o variable de error ε , una variable aleatoria no observada que agrega "ruido" a la relación lineal entre la variable dependiente y los regresores. Así, el modelo toma la forma