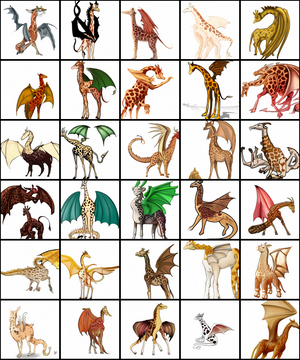

Imágenes producidas por DALL-E cuando se les da el mensaje de texto "una ilustración profesional de alta calidad de una quimera dragón jirafa. Una jirafa imitando a un dragón. Una jirafa hecha de dragón". | |

| Autor (es) original (es) | OpenAI |

|---|---|

| Versión inicial | 5 de enero de 2021 |

| Escribe | Modelo de lenguaje transformador |

| Sitio web | www |

| Parte de una serie sobre |

| Inteligencia artificial |

|---|

DALL-E ( DALL · E estilizado ) es un programa de inteligencia artificial que crea imágenes a partir de descripciones textuales, revelado por OpenAI el 5 de enero de 2021. [1] Utiliza una versión de 12 mil millones de parámetros [2] del transformador GPT-3 modelo para interpretar las entradas del lenguaje natural (como "un bolso de cuero verde con forma de pentágono" o "una vista isométrica de un carpincho triste ") y generar las imágenes correspondientes. [3] Es capaz de crear imágenes de objetos realistas ("un vitral con la imagen de una fresa azul") así como objetos que no existen en la realidad ("[2] [4] [5] [6] [7] [8] El nombre de DALL-E es un acrónimo de WALL-E y Dalí . [3] [2]

Muchas redes neuronales desde la década de 2000 en adelante han podido generar imágenes realistas. [3] DALL-E, sin embargo, es capaz de generarlos a partir de indicaciones de lenguaje natural , que "comprende [...] y rara vez falla de manera seria". [3]

DALL-E fue desarrollado y anunciado al público, junto con otro modelo, CLIP (Pre-entrenamiento de Imagen y Lenguaje Contrastivo), [1] cuya función es "comprender y clasificar" su salida. [3] La salida sin procesar de DALL-E está seleccionada por CLIP, que presenta imágenes de la más alta calidad para cualquier mensaje dado. [1] OpenAI se ha negado a publicar el código fuente de cualquiera de los modelos; una "demostración controlada" de DALL-E está disponible en el sitio web de OpenAI, donde se puede ver la salida de una selección limitada de mensajes de muestra. [2]

Según MIT Technology Review , uno de los objetivos de OpenAI a través del desarrollo de DALL-E era "dar a los modelos de lenguaje una mejor comprensión de los conceptos cotidianos que los humanos usan para dar sentido a las cosas". [1]

Arquitectura [ editar ]

El transformador generativo Pre entrenado modelo (GPT) fue desarrollado por primera vez por OpenAI en 2018, [9] utilizando el transformador de la arquitectura. La primera iteración, GPT, se amplió para producir GPT-2 en 2019. [10] En 2020, GPT-2 se aumentó de manera similar para producir GPT-3 , [11] del cual DALL-E es una implementación. [2] [12] Utiliza el aprendizaje zero-shot para generar resultados a partir de una descripción y una pista sin más entrenamiento. [13]

El modelo de DALL-E es una versión multimodal de GPT-3 [14] con 12 mil millones de parámetros [2] (reducido del tamaño de parámetro de GPT-3 de 175 mil millones) [11] que "intercambia texto por píxeles", entrenado en texto-imagen pares de Internet. [1]

DALL-E genera una gran cantidad de imágenes en respuesta a las indicaciones; otro modelo OpenAI, CLIP, se desarrolló en conjunto (y se anunció simultáneamente) con DALL-E para "comprender y clasificar" su salida. [3] CLIP se entrenó en más de 400 millones de pares de imágenes y texto. [2] CLIP es un sistema de reconocimiento de imágenes; [1] sin embargo, a diferencia de la mayoría de los modelos de clasificadores , CLIP no se entrenó en conjuntos de datos seleccionados de imágenes etiquetadas (como ImageNet ), sino más bien en imágenes y descripciones extraídas de Internet. [1] En lugar de aprender de una sola etiqueta, CLIP aprende a asociar imágenes con subtítulos completos. [1]CLIP fue entrenado para predecir qué subtítulo (de una "selección aleatoria" de 32.768 subtítulos posibles) era el más apropiado para una imagen, permitiéndole identificar posteriormente objetos en una amplia variedad de imágenes fuera de su conjunto de entrenamiento. [1]

Rendimiento [ editar ]

DALL-E es capaz de generar imágenes en una variedad de estilos, desde imágenes fotorrealistas [2] hasta pinturas y emoji . También puede "manipular y reorganizar" objetos en sus imágenes. [2] Una habilidad notada por sus creadores fue la colocación correcta de elementos de diseño en composiciones novedosas sin instrucciones explícitas: "Por ejemplo, cuando se les pide que dibujen un rábano daikon sonándose la nariz, bebiendo un café con leche o montando un monociclo, DALL · E a menudo dibuja el pañuelo, las manos y los pies en lugares plausibles ". [15]

Si bien DALL-E exhibió una amplia variedad de habilidades y habilidades, en el lanzamiento de su demostración pública, la mayor parte de la cobertura se centró en un pequeño subconjunto de imágenes de salida "surrealistas" [1] o "extravagantes" [16] . Específicamente, la producción de DALL-E para "una ilustración de un rábano daikon bebé con un tutú paseando a un perro" fue mencionada en piezas de Input , NBC, Nature , VentureBeat , Wired , CNN, New Scientist y la BBC; [17] [6] [18] [2] [19] [20] [21] [22] su salida para "un sillón en forma de aguacate" fue informado por Wired ,, New Scientist , NBC, MIT Technology Review , CNBC, CNN y BBC. [19] [2] [21] [6] [1] [16] [20] [22] En contraste, el desarrollo involuntario de DALL-E de habilidades de razonamiento visual suficientes para resolver las Matrices de Raven (pruebas visuales a menudo administradas a humanos para medir inteligencia) fue informado por el ingeniero de aprendizaje automático Dale Markowitz en un artículo para TheNextWeb . [23]

Nature presentó DALL-E como "un programa de inteligencia artificial que puede dibujar prácticamente cualquier cosa que pidas". [18] Thomas Macaulay de TheNextWeb calificó sus imágenes de "impactantes" y "realmente impresionantes", y destacó su capacidad para "crear imágenes completamente nuevas mediante la exploración de la estructura de un mensaje, incluidos objetos fantásticos que combinan ideas no relacionadas con las que nunca se alimentó. capacitación". [24] ExtremeTech dijo que "a veces las representaciones son un poco mejores que pintar con los dedos, pero otras veces son representaciones sorprendentemente precisas"; [25] TechCrunchseñaló que, si bien DALL-E era "un trabajo fabulosamente interesante y poderoso", ocasionalmente producía resultados extraños o incomprensibles, y "muchas imágenes que genera están más que un poco ... apagadas": [3]

Decir "un bolso de cuero verde con forma de pentágono" puede producir lo que se espera, pero "un bolso de gamuza azul con forma de pentágono" puede producir combustible de pesadilla. ¿Por qué? Es difícil de decir, dada la naturaleza de caja negra de estos sistemas. [3]

A pesar de esto, DALL-E fue descrito como "notablemente robusto a tales cambios" y confiable en la producción de imágenes para una amplia variedad de descripciones arbitrarias. [3] Sam Shead, que informa para CNBC , calificó sus imágenes de "extravagantes" y citó a Neil Lawrence, profesor de aprendizaje automático en la Universidad de Cambridge , describiéndolas como una "demostración inspiradora de la capacidad de estos modelos para almacenar información sobre nuestra mundo y generalizar de formas que los humanos encuentran muy naturales ". También citó a Mark Riedl, profesor asociado de la Escuela de Computación Interactiva de Georgia Tech , diciendo que los resultados de la demostración de DALL-E demostraron que era capaz de "combinar conceptos de manera coherente",y que "la demostración de DALL-E es notable por producir ilustraciones que son mucho más coherentes que otros sistemas Text2Image que he visto en los últimos años". [16] Riedl también fue citado por la BBC diciendo que estaba "impresionado por lo que el sistema podía hacer". [22]

También se destacó la capacidad de DALL-E para "completar los espacios en blanco" e inferir detalles apropiados sin indicaciones específicas. ExtremeTech señaló que un mensaje para dibujar un pingüino con un suéter navideño producía imágenes de pingüinos que no usaban suéter, pero también sombreros de Papá Noel relacionados temáticamente , [25] y Engadget notó que las sombras colocadas apropiadamente aparecían en la salida del mensaje "una pintura de un zorro sentado en un campo durante el invierno ". [13] Además, DALL-E muestra un amplio conocimiento de las tendencias visuales y de diseño; ExtremeTechdijo que "puedes pedirle a DALL-E una foto de un teléfono o una aspiradora de un período de tiempo específico, y entiende cómo han cambiado esos objetos". [25] Engadget también señaló su inusual habilidad de "comprender cómo los teléfonos y otros objetos cambian con el tiempo". [13] DALL-E ha sido descrito, junto con otras "IA estrechas" como AlphaGo , AlphaFold y GPT-3 como "[generando] interés en si y cómo se puede lograr la inteligencia artificial general ". [26]

Implicaciones [ editar ]

OpenAI se ha negado a publicar el código fuente de DALL-E, o permitir su uso fuera de un pequeño número de solicitudes de muestra; [2] OpenAI afirmó que planeaba "analizar los impactos sociales" [24] y el "potencial de sesgo" en modelos como DALL-E. [16] A pesar de la falta de acceso, se ha discutido al menos una posible implicación de DALL-E, y varios periodistas y escritores de contenido predicen principalmente que DALL-E podría tener efectos en el campo del periodismo y la redacción de contenido. El artículo de Sam Shead en la CNBC señaló que algunos estaban preocupados por la entonces falta de un artículo publicado que describiera el sistema, y que DALL-E no había sido "de código abierto" [ sic ]. [dieciséis]

Si bien TechCrunch dijo "no escribas obituarios de fotografías e ilustraciones de archivo todavía", [3] Engadget dijo que "si se desarrolla más, DALL-E tiene un gran potencial para interrumpir campos como la fotografía de archivo y la ilustración, con todo lo bueno y lo malo que es implica ". [13]

En un artículo de opinión de Forbes , el capitalista de riesgo Rob Toews dijo que DALL-E "presagiaba el amanecer de un nuevo paradigma de IA conocido como IA multimodal ", en el que los sistemas serían capaces de "interpretar, sintetizar y traducir entre múltiples modalidades de información"; Continuó diciendo que DALL-E demostró que "cada vez es más difícil negar que la inteligencia artificial es capaz de creatividad". Basándose en las indicaciones de muestra (que incluían maniquíes vestidos y muebles), predijo que DALL-E podría ser utilizado por diseñadores de moda y diseñadores de muebles , pero que "la tecnología continuará mejorando rápidamente". [27]

Referencias [ editar ]

- ^ a b c d e f g h i j k Heaven, Will Douglas (5 de enero de 2021). "Este sillón de aguacate podría ser el futuro de la IA" . Revisión de tecnología del MIT . Consultado el 5 de enero de 2021 .

- ^ a b c d e f g h i j k l Johnson, Khari (5 de enero de 2021). "OpenAI presenta DALL-E para generar imágenes a partir de texto" . VentureBeat. Archivado desde el original el 5 de enero de 2021 . Consultado el 5 de enero de 2021 .

- ^ a b c d e f g h i j Coldewey, Devin (5 de enero de 2021). "DALL-E de OpenAI crea imágenes plausibles de literalmente cualquier cosa que le pida" . Archivado desde el original el 6 de enero de 2021 . Consultado el 5 de enero de 2021 .

- ^ Grossman, Gary (16 de enero de 2021). "El motor de texto a imagen de OpenAI, DALL-E, es un poderoso generador de ideas visuales" . VentureBeat . Archivado desde el original el 26 de febrero de 2021 . Consultado el 2 de marzo de 2021 .

- ^ Andrei, Mihai (8 de enero de 2021). "Este módulo de IA puede crear imágenes asombrosas a partir de cualquier entrada de texto" . Ciencia ZME. Archivado desde el original el 29 de enero de 2021 . Consultado el 2 de marzo de 2021 .

- ↑ a b c Ehrenkranz, Melanie (27 de enero de 2021). "Aquí está DALL-E: un algoritmo que aprendió a dibujar todo lo que le digas" . NBC News . Archivado desde el original el 20 de febrero de 2021 . Consultado el 2 de marzo de 2021 .

- ^ Walsh, Bryan (5 de enero de 2021). "Un nuevo modelo de IA extrae imágenes del texto" . Axios . Consultado el 2 de marzo de 2021 .

- ^ "Para su último truco, GPT-3 de OpenAI genera imágenes a partir de leyendas de texto" . Sincronizado. 5 de enero de 2021. Archivado desde el original el 6 de enero de 2021 . Consultado el 2 de marzo de 2021 .

- ^ Radford, Alec; Narasimhan, Karthik; Salimans, Tim; Sutskever, Ilya (11 de junio de 2018). "Mejora de la comprensión del lenguaje mediante la formación previa generativa" (PDF) . OpenAI . pag. 12. Archivado (PDF) desde el original el 26 de enero de 2021 . Consultado el 23 de enero de 2021 .

- ^ Radford, Alec; Wu, Jeffrey; Niño, Rewon; Luan, David; Amodei, Dario; Sutskever, Ilua (14 de febrero de 2019). "Los modelos de lenguaje son aprendices multitarea sin supervisión" (PDF) . 1 (8). Archivado (PDF) desde el original el 6 de febrero de 2021 . Consultado el 19 de diciembre de 2020 . Cite journal requires

|journal=(help) - ^ a b Brown, Tom B .; Mann, Benjamín; Ryder, Nick; Subbiah, Melanie; Kaplan, Jared; Dhariwal, Prafulla; Neelakantan, Arvind; Shyam, Pranav; Sastry, Girish; Askell, Amanda; Agarwal, Sandhini; Herbert-Voss, Ariel; Krueger, Gretchen; Henighan, Tom; Niño, Rewon; Ramesh, Aditya; Ziegler, Daniel M .; Wu, Jeffrey; Invierno, Clemens; Hesse, Christopher; Chen, Mark; Sigler, Eric; Litwin, Mateusz; Gray, Scott; Ajedrez, Benjamín; Clark, Jack; Berner, Christopher; McCandlish, Sam; Radford, Alec; Sutskever, Ilya; Amodei, Dario (22 de julio de 2020). "Los modelos de lenguaje son aprendices de pocas oportunidades" . arXiv : 2005.14165 [ cs.CL ].

- ^ Ramesh, Aditya; Pavlov, Mikhail; Goh, Gabriel; Gray, Scott; Voss, Chelsea; Radford, Alec; Chen, Mark; Sutskever <ref name = "newscientist">, Ilya (24 de febrero de 2021). "Generación de texto a imagen Zero-Shot". arXiv : 2101.12092 [ cs.LG ].

- ^ a b c d Dent, Steve (6 de enero de 2021). "La aplicación DALL-E de OpenAI genera imágenes a partir de una descripción" . Engadget . Archivado desde el original el 27 de enero de 2021 . Consultado el 2 de marzo de 2021 .

- ^ Tamkin, Alex; Brundage, Miles; Clark, Jack; Ganguli, profundo (2021). "Comprensión de las capacidades, limitaciones e impacto social de los grandes modelos lingüísticos" . arXiv : 2102.02503 [ cs.CL ].

- ^ Dunn, Thom (10 de febrero de 2021). "Esta red neuronal de IA transforma los subtítulos de texto en arte, como un Pikachu de medusa" . BoingBoing . Archivado desde el original el 22 de febrero de 2021 . Consultado el 2 de marzo de 2021 .

- ↑ a b c d e Shead, Sam (8 de enero de 2021). "Por qué todo el mundo habla de un generador de imágenes lanzado por un laboratorio de inteligencia artificial respaldado por Elon Musk" . CNBC . Consultado el 2 de marzo de 2021 .

- ^ Kasana, Mehreen (7 de enero de 2021). "Esta IA convierte el texto en arte surrealista, impulsado por sugerencias" . Aporte. Archivado desde el original el 29 de enero de 2021 . Consultado el 2 de marzo de 2021 .

- ↑ a b Stove, Emma (5 de febrero de 2021). "Circo tardígrado y un árbol de la vida - mejores imágenes científicas de enero" . Naturaleza . Archivado desde el original el 8 de marzo de 2021 . Consultado el 2 de marzo de 2021 .

- ↑ a b Knight, Will (26 de enero de 2021). "Esta IA podría pasar de 'arte' a conducir un coche autónomo" . Cableado. Archivado desde el original el 21 de febrero de 2021 . Consultado el 2 de marzo de 2021 .

- ↑ a b Metz, Rachel (2 de febrero de 2021). "¿Un rábano con tutú paseando a un perro? Esta IA puede dibujarlo muy bien" . CNN . Consultado el 2 de marzo de 2021 .

- ↑ a b Stokel-Walker, Chris (5 de enero de 2021). "El ilustrador de inteligencia artificial dibuja imágenes imaginativas para acompañar las leyendas de texto" . Nuevo científico . Archivado desde el original el 28 de enero de 2021 . Consultado el 4 de marzo de 2021 .

- ↑ a b c Wakefield, Jane (6 de enero de 2021). "AI dibuja rábano bebé paseando a un perro en un tutú" . British Broadcasting Corporation . Archivado desde el original el 2 de marzo de 2021 . Consultado el 3 de marzo de 2021 .

- ^ Markowitz, Dale (10 de enero de 2021). "Así es como funciona el mágico generador de imágenes DALL-E de OpenAI" . TheNextWeb . Archivado desde el original el 23 de febrero de 2021 . Consultado el 2 de marzo de 2021 .

- ↑ a b Macaulay, Thomas (6 de enero de 2021). "Saluda a DALL-E de OpenAI, un bot con tecnología GPT-3 que crea imágenes extrañas a partir de texto" . TheNextWeb . Archivado desde el original el 28 de enero de 2021 . Consultado el 2 de marzo de 2021 .

- ↑ a b c Whitwam, Ryan (6 de enero de 2021). "'DALL-E' de OpenAI genera imágenes a partir de descripciones de texto" . ExtremeTech. Archivado desde el original el 28 de enero de 2021 . Consultado el 2 de marzo de 2021 .

- ^ Nichele, Stefano (2021). "Tim Taylor y Alan Dorin: auge de los autorreplicadores: visiones tempranas de máquinas, inteligencia artificial y robots que pueden reproducirse y evolucionar" . Programación genética y máquinas evolutivas . 22 : 141-145. doi : 10.1007 / s10710-021-09398-5 . S2CID 231930573 .

- ^ Toews, Rob (18 de enero de 2021). "IA y creatividad: por qué importa el último modelo de OpenAI" . Forbes . Archivado desde el original el 12 de febrero de 2021 . Consultado el 2 de marzo de 2021 .