Información

| Comunicación |

|---|

| Portal · Historia |

| Aspectos generales |

| Los campos |

| Disciplinas |

| Categorías |

| Parte de una serie sobre estadísticas |

| Visualización de datos |

|---|

| Dimensiones principales |

| Cifras importantes |

|

| Tipos de gráficos de información |

|

| Temas relacionados |

|

Información , en un sentido general, se procesa, organiza y estructura de datos . Proporciona contexto para los datos y permite la toma de decisiones. Por ejemplo, la venta de un solo cliente en un restaurante son datos; esto se convierte en información cuando la empresa puede identificar el plato más popular o menos popular. [1]

Más técnicamente, la información se puede considerar como la resolución de la incertidumbre ; responde a la pregunta de "qué es una entidad" y así define tanto su esencia como la naturaleza de sus características. [2] [ fuente no confiable? ] [3] [ fuente no confiable? ] El concepto de información tiene diferentes significados en diferentes contextos. [4] Así, el concepto se convierte en sinónimo de nociones de restricción , comunicación , control , datos , forma , educación , conocimiento., significado , comprensión , estímulos mentales , patrón , percepción , proposición , representación y entropía .

La información está asociada con los datos . La diferencia es que la información resuelve la incertidumbre. Los datos pueden representar símbolos redundantes, pero se acercan a la información a través de una compresión de datos óptima .

La información se puede transmitir en el tiempo, a través del almacenamiento de datos , y en el espacio, a través de comunicaciones y telecomunicaciones . [5] La información se expresa como contenido de un mensaje o mediante observación directa o indirecta . Lo que se percibe puede interpretarse como un mensaje por derecho propio y, en ese sentido, la información siempre se transmite como el contenido de un mensaje.

La información puede codificarse en varias formas para su transmisión e interpretación (por ejemplo, la información puede codificarse en una secuencia de signos o transmitirse a través de una señal ). También se puede cifrar para un almacenamiento y comunicación seguros.

La incertidumbre de un evento se mide por su probabilidad de ocurrencia. La incertidumbre es inversamente proporcional a la probabilidad de ocurrencia. La teoría de la información aprovecha este hecho al concluir que los eventos más inciertos requieren más información para resolver su incertidumbre. El bit es una unidad de información típica . Es "lo que reduce la incertidumbre a la mitad". [6] Se pueden utilizar otras unidades como la nat . Por ejemplo, la información codificada en un lanzamiento de moneda "justo" es log 2 (2/1) = 1 bit, y en dos lanzamientos de moneda normal es log 2 (4/1) = 2 bits. Una ciencia de 2011El artículo estimó que el 97% de la información almacenada tecnológicamente ya estaba en bits digitales en 2007, y que el año 2002 fue el comienzo de la era digital para el almacenamiento de información (con la capacidad de almacenamiento digital sin pasar por lo analógico por primera vez). [7]

Etimología

La palabra inglesa "información" proviene del francés medio enformacion / informacion / información 'una investigación criminal' y su etimón, latín informatiō (n) 'concepción, enseñanza, creación'. [8]

En inglés, "información" es un sustantivo masivo incontable .

Teoría de la información

La teoría de la información es el estudio científico de la cuantificación , almacenamiento y comunicación de información. El campo fue establecido fundamentalmente por las obras de Harry Nyquist y Ralph Hartley en la década de 1920, y de Claude Shannon en la década de 1940. El campo se encuentra en la intersección de la teoría de la probabilidad , la estadística , la informática, la mecánica estadística , la ingeniería de la información y la ingeniería eléctrica .

Una medida clave en la teoría de la información es la entropía . La entropía cuantifica la cantidad de incertidumbre involucrada en el valor de una variable aleatoria o el resultado de un proceso aleatorio . Por ejemplo, identificar el resultado de un lanzamiento de moneda justo (con dos resultados igualmente probables) proporciona menos información (entropía más baja) que especificar el resultado de un lanzamiento de un dado (con seis resultados igualmente probables). Algunas otras medidas importantes en la teoría de la información son la información mutua , la capacidad del canal, los exponentes de error y la entropía relativa . Los subcampos importantes de la teoría de la información incluyen la codificación de fuentes ,la teoría algorítmica de complejidad , la teoría algorítmica de la información y la seguridad de información teórica .

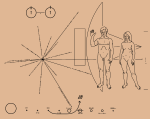

Las aplicaciones de temas fundamentales de la teoría de la información incluyen la compresión de datos sin pérdida (por ejemplo, archivos ZIP ), la compresión de datos con pérdida (por ejemplo, MP3 y JPEG ) y la codificación de canales (por ejemplo, para DSL ). Su impacto ha sido crucial para el éxito de las misiones Voyager al espacio profundo, la invención del disco compacto , la viabilidad de los teléfonos móviles y el desarrollo de Internet. La teoría también ha encontrado aplicaciones en otras áreas, incluida la inferencia estadística , [9] criptografía , neurobiología , [10] percepción , [11] lingüística, evolución [12] y función [13] de códigos moleculares ( bioinformática ), física térmica , [14] computación cuántica , agujeros negros, recuperación de información , recopilación de inteligencia , detección de plagio , [15] reconocimiento de patrones , detección de anomalías [16] e incluso creación de arte.

Como entrada sensorial

A menudo, la información puede verse como un tipo de entrada a un organismo o sistema . Las entradas son de dos tipos; algunos insumos son importantes para la función del organismo (por ejemplo, los alimentos) o el sistema ( energía ) por sí mismos. En su libro Sensory Ecology [17], el biofísico David B. Dusenbery llamó a estas entradas causales. Otras entradas (información) son importantes solo porque están asociadas con entradas causales y pueden usarse para predecir la ocurrencia de una entrada causal en un momento posterior (y quizás en otro lugar). Alguna información es importante debido a la asociación con otra información, pero eventualmente debe haber una conexión con una entrada causal.

En la práctica, la información suele ser transportada por estímulos débiles que deben ser detectados por sistemas sensoriales especializados y amplificados por entradas de energía antes de que puedan ser funcionales para el organismo o sistema. Por ejemplo, la luz es principalmente (pero no solo, por ejemplo, las plantas pueden crecer en la dirección de la fuente de luz) una entrada causal para las plantas, pero para los animales solo proporciona información. La luz de color reflejada por una flor es demasiado débil para la fotosíntesis, pero el sistema visual de la abeja la detecta y el sistema nervioso de la abeja utiliza la información para guiar a la abeja hacia la flor, donde la abeja a menudo encuentra néctar o polen, que son entradas causales. , cumpliendo una función nutricional.

Como representación y complejidad

El científico cognitivo y matemático aplicado Ronaldo Vigo sostiene que la información es un concepto que requiere al menos dos entidades relacionadas para tener sentido cuantitativo. Estos son, cualquier categoría de objetos S definida dimensionalmente, y cualquiera de sus subconjuntos R. R, en esencia, es una representación de S, o, en otras palabras, transmite información representacional (y por lo tanto, conceptual) sobre S. Vigo luego define la cantidad de información que R transmite sobre S como la tasa de cambio en la complejidad de S siempre que los objetos en R se eliminan de S. En "Información de Vigo", patrón, invariancia, complejidad, representación e información: cinco construcciones fundamentales de ciencia universal — están unificadas bajo un marco matemático novedoso. [18] [19] [20]Entre otras cosas, el marco tiene como objetivo superar las limitaciones de la información de Shannon-Weaver al intentar caracterizar y medir la información subjetiva.

Como influencia que conduce a la transformación

La información es cualquier tipo de patrón que influya en la formación o transformación de otros patrones. [21] [22] En este sentido, no hay necesidad de que una mente consciente perciba, mucho menos aprecie, el patrón. Considere, por ejemplo, el ADN . La secuencia de nucleótidos es un patrón que influye en la formación y desarrollo de un organismo sin necesidad de una mente consciente. Sin embargo, se podría argumentar que para que un humano defina conscientemente un patrón, por ejemplo, un nucleótido, naturalmente implica el procesamiento consciente de la información.

La teoría de sistemas a veces parece referirse a la información en este sentido, asumiendo que la información no involucra necesariamente a ninguna mente consciente, y los patrones que circulan (debido a la retroalimentación ) en el sistema pueden denominarse información. En otras palabras, se puede decir que la información en este sentido es algo potencialmente percibido como representación, aunque no creado ni presentado para tal fin. Por ejemplo, Gregory Bateson define "información" como una "diferencia que marca la diferencia". [23]

Sin embargo, si la premisa de "influencia" implica que la información ha sido percibida por una mente consciente y también interpretada por ella, el contexto específico asociado con esta interpretación puede provocar la transformación de la información en conocimiento . Las definiciones complejas de "información" y "conocimiento" dificultan dicho análisis semántico y lógico, pero la condición de "transformación" es un punto importante en el estudio de la información en lo que respecta al conocimiento, especialmente en la disciplina empresarial de la gestión del conocimiento . En esta práctica, se utilizan herramientas y procesos para ayudar a un trabajador del conocimiento a realizar investigaciones y tomar decisiones, incluidos pasos como:

- Revisar la información para obtener valor y significado de manera efectiva.

- Metadatos de referencia si están disponibles

- Establecer un contexto relevante , a menudo de muchos contextos posibles.

- Obtener nuevos conocimientos a partir de la información.

- Tomar decisiones o recomendaciones a partir del conocimiento resultante.

Stewart (2001) sostiene que la transformación de la información en conocimiento es fundamental, ya que se encuentra en el centro de la creación de valor y la ventaja competitiva para la empresa moderna.

El Diccionario danés de términos de información [24] sostiene que la información solo proporciona una respuesta a una pregunta planteada. Que la respuesta proporcione conocimiento depende de la persona informada. Entonces, una definición generalizada del concepto debería ser: "Información" = Una respuesta a una pregunta específica ".

Cuando Marshall McLuhan habla de los medios y sus efectos en las culturas humanas, se refiere a la estructura de los artefactos que a su vez dan forma a nuestros comportamientos y mentalidades. Además, a menudo se dice que las feromonas son "información" en este sentido.

Información mediada tecnológicamente

Estas secciones utilizan mediciones de datos en lugar de información, ya que la información no se puede medir directamente.

A partir de 2017

Se estima que la capacidad tecnológica mundial para almacenar información creció de 2,6 (óptimamente comprimidos) exabytes en 1986 - que es el equivalente informativo a menos de un CD-ROM de 730 MB por persona (539 MB por persona) - a 295 (óptimamente) comprimidos) exabytes en 2007. [7] Este es el equivalente informativo de casi 61 CD-ROM por persona en 2007. [5]

La capacidad tecnológica combinada del mundo para recibir información a través de redes de transmisión unidireccionales fue el equivalente informativo de 174 periódicos por persona y día en 2007 [7].

La capacidad efectiva combinada del mundo para intercambiar información a través de redes de telecomunicaciones bidireccionales fue el equivalente informativo de seis periódicos por persona y día en 2007 [5].

A partir de 2007, se estima que el 90% de toda la información nueva es digital, en su mayoría almacenada en discos duros. [25]

A partir de 2020

Se prevé que la cantidad total de datos creados, capturados, copiados y consumidos a nivel mundial aumente rápidamente, alcanzando los 64,2 zettabytes en 2020. Durante los próximos cinco años hasta 2025, se prevé que la creación de datos globales crezca a más de 180 zettabytes. [26]

Como registros

Los registros son formas especializadas de información. Esencialmente, los registros son información producida conscientemente o como subproducto de actividades o transacciones comerciales y retenida debido a su valor. En primer lugar, su valor es una prueba de las actividades de la organización, pero también pueden conservarse por su valor informativo. La gestión de registros sólidos [27] garantiza que se preserve la integridad de los registros durante el tiempo que sea necesario.

La norma internacional sobre gestión de registros, ISO 15489, define los registros como "información creada, recibida y mantenida como evidencia e información por una organización o persona, en cumplimiento de obligaciones legales o en la transacción de negocios". [28] El Comité Internacional de Archivos (ICA) sobre registros electrónicos definió un registro como "información registrada producida o recibida al inicio, realización o finalización de una actividad institucional o individual y que comprende contenido, contexto y estructura suficientes para proporcionar prueba de la actividad ". [29]

Se pueden mantener registros para conservar la memoria corporativa de la organización o para cumplir con los requisitos legales, fiscales o de responsabilidad impuestos a la organización. Willis expresó la opinión de que la gestión sólida de los registros comerciales y la información ofrecía "... seis requisitos clave para un buen gobierno corporativo ... transparencia; rendición de cuentas; debido proceso; cumplimiento; cumplimiento de los requisitos legales y del derecho consuetudinario; y seguridad de la información personal y corporativa . " [30]

Semiótica

Michael Buckland ha clasificado la "información" en términos de sus usos: "información como proceso", "información como conocimiento" e "información como cosa". [31]

Beynon-Davies [32] [33] explica el concepto multifacético de información en términos de signos y sistemas señal-señal. Los signos mismos pueden considerarse en términos de cuatro niveles, capas o ramas interdependientes de la semiótica : pragmática, semántica, sintaxis y empírica. Estas cuatro capas sirven para conectar el mundo social por un lado con el mundo físico o técnico por el otro.

La pragmática se ocupa del propósito de la comunicación. La pragmática vincula la cuestión de los signos con el contexto en el que se utilizan los signos. El enfoque de la pragmática está en las intenciones de los agentes vivos que subyacen al comportamiento comunicativo. En otras palabras, la pragmática vincula el lenguaje a la acción.

La semántica se ocupa del significado de un mensaje transmitido en un acto comunicativo. La semántica considera el contenido de la comunicación. La semántica es el estudio del significado de los signos, la asociación entre signos y comportamiento. La semántica puede considerarse como el estudio del vínculo entre los símbolos y sus referentes o conceptos, en particular la forma en que los signos se relacionan con el comportamiento humano.

La sintaxis se ocupa del formalismo utilizado para representar un mensaje. La sintaxis como área estudia la forma de comunicación en términos de la lógica y gramática de los sistemas de signos. La sintaxis se dedica al estudio de la forma más que al contenido de los signos y sistemas de signos.

Nielsen (2008) analiza la relación entre semiótica e información en relación con los diccionarios. Introduce el concepto de costos de información lexicográfica y se refiere al esfuerzo que debe hacer un usuario de un diccionario para buscar primero y luego comprender los datos para que puedan generar información.

La comunicación normalmente existe dentro del contexto de alguna situación social. La situación social establece el contexto para las intenciones transmitidas (pragmática) y la forma de comunicación. En una situación comunicativa, las intenciones se expresan a través de mensajes que comprenden conjuntos de signos interrelacionados tomados de un lenguaje mutuamente comprendido por los agentes involucrados en la comunicación. El entendimiento mutuo implica que los agentes involucrados comprenden el lenguaje elegido en términos de su sintaxis (sintáctica) y semántica acordadas. El remitente codifica el mensaje en el idioma y envía el mensaje como señales a lo largo de algún canal de comunicación (empírico). El canal de comunicación elegido tiene propiedades inherentes que determinan resultados como la velocidad a la que puede tener lugar la comunicación y a qué distancia.

La aplicación del estudio de la información.

El ciclo de la información (abordado en su conjunto o en sus distintos componentes) es de gran preocupación para la tecnología de la información , sistemas de información , así como la ciencia de la información . Estos campos se ocupan de los procesos y técnicas relacionados con la captura de información (a través de sensores ) y la generación (a través del cálculo , formulación o composición), procesamiento (incluida la codificación, encriptación, compresión, empaquetado), transmisión (incluidos todos los métodos de telecomunicaciones ), presentación (incluida la métodos de visualización / visualización ), almacenamiento(como magnéticos u ópticos, incluidos los métodos holográficos ), etc.

La visualización de información (abreviada como InfoVis) depende del cálculo y la representación digital de los datos y ayuda a los usuarios en el reconocimiento de patrones y la detección de anomalías .

Mapa parcial de Internet, con nodos que representan direcciones IP

Distribución de materia galáctica (incluida la oscura) en una sección cúbica del Universo

Información incrustada en un objeto matemático abstracto con núcleo de ruptura de simetría

Representación visual de un atractor extraño, con datos convertidos de su estructura fractal.

La seguridad de la información (abreviado como InfoSec) es el proceso continuo de ejercer la debida diligencia para proteger la información y los sistemas de información, del acceso, uso, divulgación, destrucción, modificación, interrupción o distribución no autorizados, a través de algoritmos y procedimientos enfocados en el monitoreo y la detección, como así como respuesta a incidentes y reparación.

El análisis de información es el proceso de inspeccionar, transformar y modelar información, mediante la conversión de datos sin procesar en conocimiento procesable, en apoyo del proceso de toma de decisiones.

La calidad de la información (abreviada como InfoQ) es el potencial de un conjunto de datos para lograr un objetivo específico (científico o práctico) utilizando un método de análisis empírico dado.

La comunicación de información representa la convergencia de la informática, las telecomunicaciones y los medios y contenidos audiovisuales.

Ver también

- Abstracción

- Exactitud y precisión

- La antiinformación reduce la certeza

- Información clasificada

- Sistema adaptativo complejo

- Sistema complejo

- Cibernética

- Dispositivo de almacenamiento de datos # Soporte de grabación

- Engrama

- Exformacion

- Infraestructura de información gratuita

- Libertad de información

- Tecnologías de la información y la comunicación.

- Arquitectura informacional

- Agente de información

- Continuum de información

- Informática

- Ecología de la información

- Ingeniería de Información

- Geometría de la información

- Desigualdad de información

- Infraestructura de información

- Gestión de la información

- Mapeo de información

- Metabolismo de la información

- Sobrecarga de información

- Procesador de información

- Ciencias de la Información

- Sensibilidad de la información

- Superautopista de la información

- Tecnologías de la información

- Teoría de la información

- Calidad de la información (InfoQ)

- Guerra de información

- Infosfera

- foro de Internet

- Costo de la información lexicográfica

- La ciencia de la biblioteca

- Memes

- Filosofía de la información

- Modelo de propaganda

- Información cuántica

- Característica Operativa del Receptor

- Satisfactorio

Referencias

- ^ "¿Cuál es la diferencia entre datos e información?" . BYJUS . Consultado el 5 de agosto de 2021 .

- ^ Artículos pirotécnicos. Artículos pirotécnicos teatrales , BSI British Standards, doi : 10.3403 / 30240478u , consultado el 5 de agosto de 2021

- ^ الريا ضه حيويه ونشاط

- ^ Una breve descripción se encuentra en: Luciano Floridi (2010). Información: una introducción muy breve . Prensa Universitaria de Fátima Gomez. ISBN 978-0-19-160954-1.

El objetivo de este volumen es proporcionar un resumen de qué información es ...

- ^ a b c "World_info_capacity_animation" . YouTube . 11 de junio de 2011 . Consultado el 1 de mayo de 2017 .

- ^ DT&SC 4-5: Introducción a la teoría de la información, 2015, Universidad de California, curso en línea, https://www.youtube.com/watch?v=9qanHTredVE&list=PLtjBSCvWCU3rNm46D3R85efM0hrzjuAIg&index=42

- ↑ a b c Hilbert, Martin; López, Priscila (2011). "La capacidad tecnológica del mundo para almacenar, comunicar y computar información". Ciencia . 332 (6025): 60–65. Código bibliográfico : 2011Sci ... 332 ... 60H . doi : 10.1126 / science.1200970 . PMID 21310967 . S2CID 206531385 . Acceso gratuito al artículo en martinhilbert.net/WorldInfoCapacity.html

- ^ Diccionario de inglés de Oxford , tercera edición, 2009, texto completo

- ^ Burnham, KP y Anderson DR (2002) Selección de modelos e inferencia multimodelo: un enfoque teórico de la información práctica, segunda edición (Springer Science, Nueva York) ISBN 978-0-387-95364-9 .

- ^ F. Rieke; D. Warland; R Ruyter van Steveninck; W Bialek (1997). Spikes: Explorando el código neuronal . La prensa del MIT. ISBN 978-0262681087.

- ^ Delgado-Bonal, Alfonso; Martín-Torres, Javier (3 de noviembre de 2016). "La visión humana se determina en base a la teoría de la información" . Informes científicos . 6 (1): 36038. Bibcode : 2016NatSR ... 636038D . doi : 10.1038 / srep36038 . ISSN 2045-2322 . PMC 5093619 . PMID 27808236 .

- ^ cf; Huelsenbeck, JP; Ronquist, F .; Nielsen, R .; Bollback, JP (2001). "Inferencia bayesiana de la filogenia y su impacto en la biología evolutiva". Ciencia . 294 (5550): 2310–2314. Código Bibliográfico : 2001Sci ... 294.2310H . doi : 10.1126 / science.1065889 . PMID 11743192 . S2CID 2138288 .

- ^ Allikmets, Rando; Wasserman, Wyeth W .; Hutchinson, Amy; Smallwood, Philip; Nathans, Jeremy; Rogan, Peter K. (1998). "Thomas D. Schneider], Michael Dean (1998) Organización del gen ABCR: análisis de secuencias de unión promotora y de empalme" . Gene . 215 (1): 111-122. doi : 10.1016 / s0378-1119 (98) 00269-8 . PMID 9666097 .

- ^ Jaynes, ET (1957). "Teoría de la información y mecánica estadística" . Phys. Rev . 106 (4): 620. Bibcode : 1957PhRv..106..620J . doi : 10.1103 / physrev.106.620 .

- ^ Bennett, Charles H .; Li, Ming; Ma, Bin (2003). "Cartas en cadena e historias evolutivas" . Scientific American . 288 (6): 76–81. Código bibliográfico : 2003SciAm.288f..76B . doi : 10.1038 / scientificamerican0603-76 . PMID 12764940 . Archivado desde el original el 7 de octubre de 2007 . Consultado el 11 de marzo de 2008 .

- ^ David R. Anderson (1 de noviembre de 2003). "Algunos antecedentes sobre por qué las personas en las ciencias empíricas pueden querer comprender mejor los métodos teóricos de la información" (PDF) . Archivado desde el original (PDF) el 23 de julio de 2011 . Consultado el 23 de junio de 2010 .

- ^ Dusenbery, David B. (1992). Ecología sensorial . Nueva York: WH Freeman. ISBN 978-0-7167-2333-2.

- ^ Vigo, R. (2011). "Información representativa: una nueva noción general y medida de información" (PDF) . Ciencias de la información . 181 (21): 4847–59. doi : 10.1016 / j.ins.2011.05.020 .

- ^ Vigo, R. (2013). "Complejidad sobre la incertidumbre en la teoría de la información representacional generalizada (GRIT): una teoría general sensible a la estructura de la información" . Información . 4 (1): 1–30. doi : 10.3390 / info4010001 .

- ^ Vigo, R. (2014). Principios matemáticos del comportamiento conceptual humano: la naturaleza estructural de la representación y el procesamiento conceptual . Nueva York y Londres: Scientific Psychology Series, Routledge. ISBN 978-0415714365.

- ^ Shannon, Claude E. (1949). La teoría matemática de la comunicación .

- ^ Casagrande, David (1999). "La información como verbo: reconceptualizando la información para modelos cognitivos y ecológicos" (PDF) . Revista de Antropología Ecológica . 3 (1): 4–13. doi : 10.5038 / 2162-4593.3.1.1 .

- ^ Bateson, Gregory (1972). Forma, sustancia y diferencia, en pasos hacia una ecología de la mente . Prensa de la Universidad de Chicago. págs. 448–66.

- ^ Simonsen, Bo Krantz. "Informationsordbogen - vis begreb" . Informationsordbogen.dk . Consultado el 1 de mayo de 2017 .

- ^ Tendencias de fallas en una población de unidades de disco grandes. Eduardo Pinheiro, Wolf-Dietrich Weber y Luiz Andre Barroso

- ^ "Volumen total de datos en todo el mundo 2010-2025" . Statista . Consultado el 6 de agosto de 2021 .

- ^ "¿Qué es la gestión de registros?" . Consultado el 29 de enero de 2021 .

- ^ ISO 15489

- ^ Comité de Registros Electrónicos (febrero de 1997). "Guía para la gestión de registros electrónicos desde una perspectiva de archivo" (PDF) . www.ica.org . Comité Internacional de Archivos. pag. 22 . Consultado el 9 de febrero de 2019 .

- ^ Willis, Anthony (1 de agosto de 2005). "Gobierno corporativo y gestión de información y registros". Diario de gestión de registros . 15 (2): 86–97. doi : 10.1108 / 09565690510614238 .

- ^ Buckland, Michael K. (junio de 1991). "Información como cosa". Revista de la Sociedad Estadounidense de Ciencias de la Información . 42 (5): 351–360. doi : 10.1002 / (SICI) 1097-4571 (199106) 42: 5 <351 :: AID-ASI5> 3.0.CO; 2-3 .

- ^ Beynon-Davies, P. (2002). Sistemas de información: una introducción a la informática en las organizaciones . Basingstoke, Reino Unido: Palgrave. ISBN 978-0-333-96390-6.

- ^ Beynon-Davies, P. (2009). Sistemas de información empresarial . Basingstoke: Palgrave. ISBN 978-0-230-20368-6.

Otras lecturas

- Liu, Alan (2004). Las leyes de lo cool: el trabajo del conocimiento y la cultura de la información . Prensa de la Universidad de Chicago .

- Bekenstein, Jacob D. (agosto de 2003). "Información en el universo holográfico" . Scientific American . 289 (2): 58–65. Código bibliográfico : 2003SciAm.289b..58B . doi : 10.1038 / scientificamerican0803-58 . PMID 12884539 .

- Gleick, James (2011). La información: una historia, una teoría, una inundación . Nueva York, NY: Pantheon.

- Lin, Shu-Kun (2008). "Paradoja de Gibbs y los conceptos de información, simetría, similitud y su relación" . Entropía . 10 (1): 1–5. arXiv : 0803.2571 . Bibcode : 2008Entrp..10 .... 1L . doi : 10.3390 / entropy-e10010001 . S2CID 41159530 .

- Floridi, Luciano (2005). "¿Es la información datos significativos?" (PDF) . Filosofía e Investigación Fenomenológica . 70 (2): 351–70. doi : 10.1111 / j.1933-1592.2005.tb00531.x . hdl : 2299/1825 .

- Floridi, Luciano (2005). "Concepciones semánticas de la información" . En Zalta, Edward N. (ed.). La Enciclopedia de Filosofía de Stanford (edición de invierno de 2005). Laboratorio de Investigación en Metafísica, Universidad de Stanford.

- Floridi, Luciano (2010). Información: una introducción muy breve . Oxford: Prensa de la Universidad de Oxford .

- Logan, Robert K. ¿Qué es la información? - Organización que se propaga en la Biosfera, la Simbolósfera, la Tecnosfera y la Econosfera . Toronto: Publicación DEMO.

- Nielsen, Sandro (2008). "El efecto de los costos de la información lexicográfica en la elaboración y el uso de diccionarios". Lexikos . 18 : 170–89.

- Stewart, Thomas (2001). Riqueza de conocimientos . Nueva York, NY: Doubleday.

- Joven, Paul (1987). La naturaleza de la información . Westport, Ct: Greenwood Publishing Group. ISBN 978-0-275-92698-4.

- Kenett, Ron S .; Shmueli, Galit (2016). Calidad de la información: el potencial de los datos y el análisis para generar conocimiento . Chichester, Reino Unido: John Wiley and Sons. doi : 10.1002 / 9781118890622 . ISBN 978-1-118-87444-8.

enlaces externos

| Busque información en Wiktionary, el diccionario gratuito. |

| Wikiquote tiene citas relacionadas con: Información |

| Wikimedia Commons tiene medios relacionados con la información . |

- Revisión de conceptos semánticos de información por Luciano Floridi para la Enciclopedia de Filosofía de Stanford

- Entrada de Principia Cybernetica sobre negentropía

- Fisher Information, un nuevo paradigma para la ciencia: introducción, principios de incertidumbre, ecuaciones de onda, ideas de Escher, Kant, Platón y Wheeler. Este ensayo se revisa continuamente a la luz de la investigación en curso.

- ¿Cuánta información? 2003 un intento de estimar cuánta información nueva se crea cada año (el estudio fue elaborado por profesores y estudiantes de la Escuela de Sistemas y Gestión de la Información de la Universidad de California en Berkeley )

- (en danés) Informationsordbogen.dk Diccionario danés de términos de información / Informationsordbogen

- Información

- Conceptos en metafísica

- Ciencias de la Información

- Artículos del tema principal