| Entropía | |

|---|---|

| Símbolos comunes | S |

| Unidad SI | julios por kelvin (J⋅K −1 ) |

| En unidades base SI | kg⋅m 2 ⋅s −2 ⋅K −1 |

| Termodinámica |

|---|

|

|

| Artículos de entropía |

|---|

|

La entropía es un concepto científico, así como una propiedad física medible que se asocia más comúnmente con un estado de desorden, aleatoriedad o incertidumbre. El término y el concepto se utilizan en diversos campos, desde la termodinámica clásica , donde se reconoció por primera vez, hasta la descripción microscópica de la naturaleza en la física estadística y los principios de la teoría de la información . Ha encontrado aplicaciones de gran alcance en química y física , en sistemas biológicos y su relación con la vida, en cosmología , economía , sociología , ciencias del tiempo , cambio climático ysistemas de información, incluida la transmisión de información en telecomunicaciones . [1]

El científico e ingeniero escocés Macquorn Rankine se refirió al concepto termodinámico en 1850 con los nombres de función termodinámica y potencial de calor . [2] En 1865, el físico alemán Rudolph Clausius , uno de los principales fundadores del campo de la termodinámica, lo definió como el cociente de una cantidad infinitesimal de calor a la temperatura instantánea . Inicialmente lo describió como contenido de transformación , en alemán Verwandlungsinhalt , y luego acuñó el término entropía de una palabra griega para transformación.. Refiriéndose a la constitución y estructura microscópicas, en 1862, Clausius interpretó el concepto como una disgregación de significados . [3]

Una consecuencia de la entropía es que ciertos procesos son irreversibles o imposibles, además del requisito de no violar la conservación de la energía , expresada esta última en la primera ley de la termodinámica . La entropía es fundamental para la segunda ley de la termodinámica , que establece que la entropía de los sistemas aislados que se dejan a la evolución espontánea no puede disminuir con el tiempo, ya que siempre llegan a un estado de equilibrio termodinámico, donde la entropía es más alta.

El físico austriaco Ludwig Boltzmann explicó la entropía como la medida del número de posibles arreglos o estados microscópicos de átomos y moléculas individuales de un sistema que cumplen con la condición macroscópica del sistema. De este modo introdujo el concepto de desorden estadístico y distribuciones de probabilidad en un nuevo campo de la termodinámica, llamado mecánica estadística , y encontró el vínculo entre las interacciones microscópicas, que fluctúan alrededor de una configuración promedio, con el comportamiento macroscópicamente observable, en forma de un simple logarítmico. ley, con una constante de proporcionalidad , la constante de Boltzmann, que se ha convertido en una de las constantes universales definitorias del moderno Sistema Internacional de Unidades (SI).

En 1948, el científico de Bell Labs , Claude Shannon, desarrolló conceptos estadísticos similares para medir la incertidumbre microscópica y la multiplicidad al problema de las pérdidas aleatorias de información en las señales de telecomunicaciones. Por sugerencia de John von Neumann , Shannon nombró a esta entidad de información faltante de manera análoga a su uso en mecánica estadística como entropía , y dio origen al campo de la teoría de la información . Esta descripción se ha propuesto como una definición universal del concepto de entropía. [4]

Historia

En su artículo de 1803, Principios fundamentales de equilibrio y movimiento , el matemático francés Lazare Carnot propuso que en cualquier máquina las aceleraciones y choques de las partes móviles representan pérdidas de momento de actividad ; en cualquier proceso natural existe una tendencia inherente a la disipación de energía útil. En 1824, basándose en ese trabajo, el hijo de Lazare, Sadi Carnot , publicó Reflexiones sobre la fuerza motriz del fuego , que postulaba que en todas las máquinas térmicas, siempre que " calórico " (lo que ahora se conoce como calor) cae a través de una diferencia de temperatura, trabajo o fuerza motrizse puede producir a partir de las acciones de su caída de un cuerpo caliente a frío. Usó una analogía con cómo el agua cae en una rueda de agua . Esa fue una idea temprana de la segunda ley de la termodinámica . [5] Carnot basó sus puntos de vista sobre el calor parcialmente en la "hipótesis newtoniana" de principios del siglo XVIII de que tanto el calor como la luz eran tipos de formas indestructibles de materia, que son atraídas y repelidas por otra materia, y parcialmente en las opiniones contemporáneas de Count Rumford , quien demostró en 1789 que el calor se podía crear por fricción, como cuando se mecanizan los orificios de los cañones. [6] Carnot razonó que si el cuerpo de la sustancia de trabajo, como un cuerpo de vapor, se devuelve a su estado original al final de una completaciclo del motor , "no se produce ningún cambio en la condición del cuerpo de trabajo".

La primera ley de la termodinámica , deducida de los experimentos de calor-fricción de James Joule en 1843, expresa el concepto de energía y su conservación en todos los procesos; sin embargo, la primera ley no puede cuantificar los efectos de la fricción y la disipación .

En las décadas de 1850 y 1860, el físico alemán Rudolf Clausius objetó la suposición de que no se produce ningún cambio en el cuerpo de trabajo y le dio a ese cambio una interpretación matemática, al cuestionar la naturaleza de la pérdida inherente de calor utilizable cuando se realiza el trabajo, por ejemplo, calor. producido por fricción. [7] Describió sus observaciones como un uso disipativo de energía, que resulta en un contenido de transformación ( Verwandlungsinhalt en alemán), de un sistema termodinámico o cuerpo de trabajo de especies químicas durante un cambio de estado . [7] Eso contrastaba con los puntos de vista anteriores, basados en las teorías de Isaac Newton., ese calor era una partícula indestructible que tenía masa. Clausius descubrió que la energía no utilizable aumenta a medida que el vapor pasa de la entrada al escape en una máquina de vapor. Del prefijo en- , como en 'energía', y de la palabra griega τροπή [tropē], que se traduce en un léxico establecido como giro o cambio , [8] y que él tradujo en alemán como Verwandlung , una palabra que a menudo se traduce al inglés como transformación , en 1865 Clausius acuñó el nombre de esa propiedad como entropía . [9] La palabra fue adoptada al idioma inglés en 1868.

Más tarde, científicos como Ludwig Boltzmann , Josiah Willard Gibbs y James Clerk Maxwell dieron a la entropía una base estadística. En 1877, Boltzmann visualizó una forma probabilística de medir la entropía de un conjunto de partículas de gas ideal , en la que definió la entropía como proporcional al logaritmo natural del número de microestados que ese gas podría ocupar. En lo sucesivo, el problema esencial de la termodinámica estadística ha sido determinar la distribución de una determinada cantidad de energía E en N sistemas idénticos. Constantin Carathéodory, matemático griego, vinculó la entropía con una definición matemática de irreversibilidad, en términos de trayectorias e integrabilidad.

Etimología

En 1865, Clausius nombró el concepto de "el diferencial de una cantidad que depende de la configuración del sistema", entropía ( Entropie ) después de la palabra griega para "transformación". [10] Da "contenido transformacional" ( Verwandlungsinhalt ) como sinónimo, en paralelo con su "contenido térmico y ergonal" ( Wärme- und Werkinhalt ) como el nombre de U {\ Displaystyle U} , pero prefiriendo el término entropía como un estrecho paralelo de la palabra energía , ya que encontró los conceptos casi "análogos en su significado físico". [10] Este término se formó reemplazando la raíz de ἔργον ('trabajo') por la de τροπή ('transformación'). [9]

Definiciones y descripciones

Willard Gibbs , Métodos gráficos en la termodinámica de fluidos [11]

El concepto de entropía se describe mediante dos enfoques principales, la perspectiva macroscópica de la termodinámica clásica y la descripción microscópica fundamental para la mecánica estadística . El enfoque clásico define la entropía en términos de propiedades físicas medibles macroscópicamente, como masa, volumen, presión y temperatura. La definición estadística de entropía la define en términos de las estadísticas de los movimientos de los componentes microscópicos de un sistema, modelado al principio de manera clásica, por ejemplo, partículas newtonianas que constituyen un gas, y luego cuántico-mecánicamente (fotones, fonones, giros, etc.). Los dos enfoques forman una visión coherente y unificada del mismo fenómeno tal como se expresa en la segunda ley de la termodinámica, que ha encontrado una aplicabilidad universal a los procesos físicos.

Función del estado

Muchas propiedades termodinámicas tienen una característica especial en el sentido de que forman un conjunto de variables físicas que definen un estado de equilibrio; son funciones del estado . A menudo, si se determinan dos propiedades de un sistema, son suficientes para determinar el estado del sistema y, por lo tanto, los valores de otras propiedades. Por ejemplo, una determinada cantidad, temperatura y presión de gas determinan su estado y, por tanto, también su volumen. Como otro ejemplo, se determina un sistema compuesto de una sustancia pura de una sola fase a una temperatura y presión uniformes particulares (y por lo tanto es un estado particular) y está no solo a un volumen particular sino también a una entropía particular. [12]El hecho de que la entropía sea una función del estado es una de las razones por las que es útil. En el ciclo de Carnot, el fluido de trabajo vuelve al mismo estado que tenía al comienzo del ciclo, por lo que la integral de línea de cualquier función de estado, como la entropía, sobre este ciclo reversible es cero.

Proceso reversible

La entropía se conserva para un proceso reversible . Un proceso reversible es aquel que no se desvía del equilibrio termodinámico, mientras produce el trabajo máximo. Cualquier proceso que ocurra lo suficientemente rápido como para desviarse del equilibrio térmico no puede ser reversible. En estos casos, la energía se pierde en calor, aumenta la entropía total y también se pierde el potencial para realizar el máximo trabajo en la transición. Más específicamente, la entropía total se conserva en un proceso reversible y no se conserva en un proceso irreversible. [13]Por ejemplo, en el ciclo de Carnot, mientras que el flujo de calor del reservorio caliente al reservorio frío representa un aumento en la entropía, la producción de trabajo, si se almacena de manera reversible y perfecta en algún mecanismo de almacenamiento de energía, representa una disminución en la entropía que podría usarse para operar el motor térmico en reversa y volver al estado anterior, por lo tanto, el cambio de entropía total sigue siendo cero en todo momento si todo el proceso es reversible. Un proceso irreversible aumenta la entropía. [14]

Ciclo de Carnot

El concepto de entropía surgió del estudio de Rudolf Clausius del ciclo de Carnot . [15] En un ciclo de Carnot, el calor Q H es absorbida isotérmicamente a la temperatura T H desde un depósito de 'caliente' y renunciado a isotérmicamente en forma de calor Q C a un depósito de 'frío' en T C . Según el principio de Carnot, el trabajo sólo puede ser producido por el sistema cuando hay una diferencia de temperatura, y el trabajo debe ser alguna función de la diferencia de temperatura y el calor absorbido ( Q H ). Carnot no distinguió entre Q H yQ C , ya que estaba usando la hipótesis incorrecta de que teoría calórica era válido, y por lo tanto se conserva calor (la suposición errónea de que Q H y Q C eran iguales) cuando, de hecho, Q H es mayor que Q C . [16] [17] Gracias a los esfuerzos de Clausius y Kelvin , ahora se sabe que el trabajo máximo que puede producir una máquina térmica es el producto de la eficiencia de Carnot y el calor absorbido del depósito caliente:

( 1 )

Para derivar la eficiencia de Carnot, que es 1 - T C / T H (un número menor que uno), Kelvin tuvo que evaluar la relación entre la producción de trabajo y el calor absorbido durante la expansión isotérmica con la ayuda de la ecuación de Carnot-Clapeyron , que contenía una función desconocida llamada función de Carnot. La posibilidad de que la función de Carnot sea la temperatura medida a partir de una temperatura cero, fue sugerida por Joule en una carta a Kelvin. Esto le permitió a Kelvin establecer su escala de temperatura absoluta. [18] También se sabe que el trabajo producido por el sistema es la diferencia entre el calor absorbido del depósito caliente y el calor entregado al depósito frío:

( 2 )

Dado que este último es válido durante todo el ciclo, esto le dio a Clausius la pista de que en cada etapa del ciclo, el trabajo y el calor no serían iguales, sino que su diferencia sería una función de estado que desaparecería al completar el ciclo. La función de estado se llamó energía interna y se convirtió en la primera ley de la termodinámica . [19]

Ahora igualando ( 1 ) y ( 2 ) da

o

Esto implica que hay una función de estado que se conserva durante un ciclo completo del ciclo de Carnot. Clausius llamó a esta función de estado entropía . Se puede ver que la entropía se descubrió a través de las matemáticas y no a través de resultados de laboratorio. Es una construcción matemática y no tiene una analogía física fácil. Esto hace que el concepto sea algo oscuro o abstracto, similar a cómo surgió el concepto de energía.

Clausius luego preguntó qué pasaría si el sistema produjera menos trabajo que el que predice el principio de Carnot. El lado derecho de la primera ecuación sería el límite superior de la producción de trabajo del sistema, que ahora se convertiría en una desigualdad

Cuando se usa la segunda ecuación para expresar el trabajo como una diferencia de calores, obtenemos

- o

Por lo tanto, se entrega más calor al depósito frío que en el ciclo de Carnot. Si denotamos las entropías por S i = Q i / T i para los dos estados, entonces la desigualdad anterior se puede escribir como una disminución en la entropía

- o

La entropía que sale del sistema es mayor que la entropía que ingresa al sistema, lo que implica que algún proceso irreversible evita que el ciclo produzca la máxima cantidad de trabajo predicha por la ecuación de Carnot.

El ciclo de Carnot y la eficiencia son útiles porque definen el límite superior del posible rendimiento de trabajo y la eficiencia de cualquier sistema termodinámico clásico. Otros ciclos, como el ciclo Otto , el ciclo Diesel y el ciclo Brayton , pueden analizarse desde el punto de vista del ciclo de Carnot. Cualquier máquina o proceso que convierta el calor en trabajo y se afirme que produce una eficiencia mayor que la eficiencia de Carnot no es viable porque viola la segunda ley de la termodinámica. Para cantidades muy pequeñas de partículas en el sistema, se debe utilizar la termodinámica estadística. La eficiencia de dispositivos como las células fotovoltaicas requiere un análisis desde el punto de vista de la mecánica cuántica.

Termodinámica clásica

| Variables conjugadas de termodinámica | |

|---|---|

| Presión | Volumen |

| ( Estrés ) | ( Cepa ) |

| La temperatura | Entropía |

| Potencial químico | Número de partícula |

La definición termodinámica de entropía fue desarrollada a principios de la década de 1850 por Rudolf Clausius y esencialmente describe cómo medir la entropía de un sistema aislado en equilibrio termodinámico con sus partes. Clausius creó el término entropía como una variable termodinámica extensa que demostró ser útil para caracterizar el ciclo de Carnot . Se encontró que la transferencia de calor a lo largo de los pasos de isoterma del ciclo de Carnot es proporcional a la temperatura de un sistema (conocida como su temperatura absoluta). Esta relación se expresó en incrementos de entropía iguales a la relación de transferencia de calor incremental dividida por la temperatura, que se encontró que variaba en el ciclo termodinámico pero eventualmente regresaba al mismo valor al final de cada ciclo. Por lo tanto, se encontró que era una función del estado , específicamente un estado termodinámico del sistema.

Si bien Clausius basó su definición en un proceso reversible, también hay procesos irreversibles que cambian la entropía. Siguiendo la segunda ley de la termodinámica , la entropía de un sistema aislado siempre aumenta para procesos irreversibles. La diferencia entre un sistema aislado y un sistema cerrado es que es posible que el calor no fluya hacia y desde un sistema aislado, pero es posible el flujo de calor hacia y desde un sistema cerrado. Sin embargo, tanto para sistemas cerrados como aislados, y de hecho, también en sistemas abiertos, pueden ocurrir procesos termodinámicos irreversibles.

Según la igualdad de Clausius , para un proceso cíclico reversible:. Esto significa que la línea integrales independiente de la ruta .

Entonces podemos definir una función de estado S llamada entropía, que satisface.

Para encontrar la diferencia de entropía entre dos estados cualesquiera de un sistema, la integral debe evaluarse para algún camino reversible entre los estados inicial y final. [20] Dado que la entropía es una función de estado, el cambio de entropía del sistema para una ruta irreversible es el mismo que para una ruta reversible entre los mismos dos estados. [21] Sin embargo, el cambio de entropía del entorno es diferente.

Solo podemos obtener el cambio de entropía integrando la fórmula anterior. Para obtener el valor absoluto de la entropía, necesitamos la tercera ley de la termodinámica , que establece que S = 0 en el cero absoluto para cristales perfectos.

Desde una perspectiva macroscópica, en la termodinámica clásica la entropía se interpreta como una función de estado de un sistema termodinámico : es decir, una propiedad que depende únicamente del estado actual del sistema, independientemente de cómo se haya alcanzado ese estado. En cualquier proceso donde el sistema cede energía Δ E , y su entropía cae en Δ S , una cantidad de al menos T R Δ S de esa energía debe entregarse al entorno del sistema como calor inutilizable ( T Res la temperatura del entorno externo del sistema). De lo contrario, el proceso no puede seguir adelante. En termodinámica clásica, la entropía de un sistema se define solo si está en equilibrio termodinámico .

Mecánica estadística

La definición estadística fue desarrollada por Ludwig Boltzmann en la década de 1870 mediante el análisis del comportamiento estadístico de los componentes microscópicos del sistema. Boltzmann demostró que esta definición de entropía era equivalente a la entropía termodinámica dentro de un factor constante, conocido como constante de Boltzmann . En resumen, la definición termodinámica de entropía proporciona la definición experimental de entropía, mientras que la definición estadística de entropía amplía el concepto, proporcionando una explicación y una comprensión más profunda de su naturaleza.

La interpretación de la entropía en la mecánica estadística es la medida de la incertidumbre, o confusión en la frase de Gibbs , que permanece sobre un sistema después de que se han tenido en cuenta sus propiedades macroscópicas observables, como la temperatura, la presión y el volumen. Para un conjunto dado de variables macroscópicas, la entropía mide el grado en que la probabilidad del sistema se distribuye en diferentes microestados posibles.. A diferencia del macroestado, que caracteriza cantidades medias claramente observables, un microestado especifica todos los detalles moleculares del sistema, incluida la posición y la velocidad de cada molécula. Cuantos más estados de este tipo estén disponibles para el sistema con una probabilidad apreciable, mayor será la entropía. En mecánica estadística, la entropía es una medida de la cantidad de formas en que se puede organizar un sistema, que a menudo se considera una medida de "desorden" (cuanto mayor es la entropía, mayor es el desorden). [22] [23] [24] Esta definición describe la entropía como proporcional al logaritmo natural del número de posibles configuraciones microscópicas de los átomos y moléculas individuales del sistema ( microestados ) que podrían causar el estado macroscópico observado (macroestado ) del sistema. La constante de proporcionalidad es la constante de Boltzmann .

La constante de Boltzmann, y por lo tanto la entropía, tienen dimensiones de energía divididas por la temperatura, que tiene una unidad de joules por kelvin (J⋅K −1 ) en el Sistema Internacional de Unidades (o kg⋅m 2 ⋅s −2 ⋅K −1 en términos de unidades base). La entropía de una sustancia generalmente se da como una propiedad intensiva , ya sea entropía por unidad de masa (unidad SI: J⋅K −1 ⋅kg −1 ) o entropía por unidad de cantidad de sustancia (unidad SI: J⋅K −1 ⋅mol −1 ).

Específicamente, la entropía es una medida logarítmica del número de estados con probabilidad significativa de estar ocupados:

( es la probabilidad de que el sistema esté en th estado; si los estados se definen de manera continua, la suma se reemplaza por una integral sobre todos los estados posibles) o, de manera equivalente, el valor esperado del logaritmo de la probabilidad de que un microestado esté ocupado

donde k B es la constante de Boltzmann , igual a1.380 65 × 10 -23 J / K . La suma es sobre todos los posibles microestados del sistema, y p i es la probabilidad de que el sistema esté en el i -ésimo microestado. [25] Esta definición asume que el conjunto base de estados ha sido elegido de modo que no haya información sobre sus fases relativas. En un conjunto de bases diferente, la expresión más general es

donde es la matriz de densidad ,es rastro yes el logaritmo de la matriz . Esta formulación de matriz de densidad no es necesaria en casos de equilibrio térmico siempre que los estados base se elijan como estados propios de energía. Para la mayoría de los propósitos prácticos, esto puede tomarse como la definición fundamental de entropía, ya que todas las demás fórmulas para S pueden derivarse matemáticamente de ella, pero no al revés.

En lo que se ha llamado el supuesto fundamental de la termodinámica estadística o el postulado fundamental de la mecánica estadística , se supone que la ocupación de cualquier microestado es igualmente probable (es decir, p i = 1 / Ω, donde Ω es el número de microestados); este supuesto suele estar justificado para un sistema aislado en equilibrio. [26] Entonces la ecuación anterior se reduce a

En termodinámica, dicho sistema es aquel en el que el volumen, el número de moléculas y la energía interna están fijos (el conjunto microcanónico ).

Para un sistema termodinámico dado, el exceso de entropía se define como la entropía menos la de un gas ideal a la misma densidad y temperatura, una cantidad que siempre es negativa porque un gas ideal está desordenado al máximo. [27] Este concepto juega un papel importante en la teoría del estado líquido. Por ejemplo, el principio de escalamiento de exceso de entropía de Rosenfeld [28] [29] establece que los coeficientes de transporte reducidos a lo largo del diagrama de fase bidimensional son funciones determinadas únicamente por el exceso de entropía. [30] [31]

La interpretación más general de la entropía es como una medida de nuestra incertidumbre sobre un sistema. El estado de equilibrio de un sistema maximiza la entropía porque hemos perdido toda la información sobre las condiciones iniciales excepto las variables conservadas; maximizar la entropía maximiza nuestra ignorancia sobre los detalles del sistema. [32] Esta incertidumbre no es del tipo subjetivo cotidiano, sino más bien la incertidumbre inherente al método experimental y al modelo interpretativo. [33]

El modelo interpretativo tiene un papel central en la determinación de la entropía. El calificativo "para un conjunto dado de variables macroscópicas" anterior tiene profundas implicaciones: si dos observadores utilizan diferentes conjuntos de variables macroscópicas, ven diferentes entropías. Por ejemplo, si el observador A usa las variables U , V y W , y el observador B usa U , V , W , X , entonces, al cambiar X , el observador B puede causar un efecto que parece una violación de la segunda ley de la termodinámica. al observador A. En otras palabras: el conjunto de variables macroscópicas que uno elige debe incluir todo lo que pueda cambiar en el experimento, de lo contrario, podría ver una entropía decreciente.[34]

La entropía se puede definir para cualquier proceso de Markov con dinámica reversible y la propiedad de equilibrio detallada .

En 1896 Lectures on Gas Theory de Boltzmann , demostró que esta expresión da una medida de entropía para sistemas de átomos y moléculas en la fase gaseosa, proporcionando así una medida de la entropía de la termodinámica clásica.

Entropía de un sistema

La entropía surge directamente del ciclo de Carnot . También se puede describir como el calor reversible dividido por la temperatura. La entropía es una función fundamental del estado.

En un sistema termodinámico , la presión, la densidad y la temperatura tienden a volverse uniformes con el tiempo porque el estado de equilibrio tiene una probabilidad más alta (más combinaciones posibles de microestados ) que cualquier otro estado.

Por ejemplo, para un vaso de agua helada en el aire a temperatura ambiente , la diferencia de temperatura entre una habitación cálida (los alrededores) y un vaso frío de hielo y agua (el sistema y no parte de la habitación), comienza a igualarse como porciones de la energía térmica de los alrededores cálidos se esparcen al sistema más frío de hielo y agua. Con el tiempo, la temperatura del vaso y su contenido y la temperatura de la habitación se igualan. En otras palabras, la entropía de la habitación ha disminuido a medida que parte de su energía se ha dispersado al hielo y al agua, cuya entropía ha aumentado.

Sin embargo, como se calcula en el ejemplo, la entropía del sistema de hielo y agua ha aumentado más de lo que ha disminuido la entropía de la habitación circundante. En un sistema aislado como la habitación y el agua helada tomados juntos, la dispersión de energía de un lugar más cálido a otro más frío siempre da como resultado un aumento neto de la entropía. Por lo tanto, cuando el "universo" de la habitación y el sistema de agua helada ha alcanzado un equilibrio de temperatura, el cambio de entropía desde el estado inicial es máximo. La entropía del sistema termodinámico es una medida de cuánto ha progresado la ecualización.

La entropía termodinámica es una función de estado no conservada que es de gran importancia en las ciencias de la física y la química . [22] [35] Históricamente, el concepto de entropía evolucionó para explicar por qué algunos procesos (permitidos por las leyes de conservación) ocurren espontáneamente mientras que sus inversiones temporales (también permitidas por las leyes de conservación) no lo hacen; Los sistemas tienden a progresar en la dirección de aumentar la entropía. [36] [37] Para sistemas aislados , la entropía nunca disminuye. [35] Este hecho tiene varias consecuencias importantes en la ciencia: primero, prohíbe el " movimiento perpetuo"máquinas; y segundo, implica que la flecha de la entropía tiene la misma dirección que la flecha del tiempo . Los aumentos en la entropía corresponden a cambios irreversibles en un sistema, porque parte de la energía se gasta como calor residual, lo que limita la cantidad de trabajo que un sistema puede realizar. hacer. [22] [23] [38] [39]

A diferencia de muchas otras funciones de estado, la entropía no puede observarse directamente, sino que debe calcularse. La entropía se puede calcular para una sustancia como la entropía molar estándar a partir del cero absoluto (también conocida como entropía absoluta) o como una diferencia en la entropía de algún otro estado de referencia definido como entropía cero. La entropía tiene la dimensión de la energía dividida por la temperatura, que tiene una unidad de julios por kelvin (J / K) en el Sistema Internacional de Unidades . Si bien estas son las mismas unidades que la capacidad calorífica , los dos conceptos son distintos. [40]La entropía no es una cantidad conservada: por ejemplo, en un sistema aislado con temperatura no uniforme, el calor podría fluir irreversiblemente y la temperatura volverse más uniforme de manera que la entropía aumente. La segunda ley de la termodinámica establece que un sistema cerrado tiene una entropía que puede aumentar o permanecer constante. Las reacciones químicas provocan cambios en la entropía y la entropía juega un papel importante en determinar en qué dirección procede espontáneamente una reacción química.

Una definición de diccionario de entropía es que es "una medida de energía térmica por unidad de temperatura que no está disponible para un trabajo útil". Por ejemplo, una sustancia a temperatura uniforme tiene la máxima entropía y no puede impulsar una máquina térmica. Una sustancia a temperatura no uniforme tiene una entropía más baja (que si se permite que la distribución de calor se nivele) y parte de la energía térmica puede impulsar un motor térmico.

Un caso especial de aumento de entropía, la entropía de la mezcla , ocurre cuando se mezclan dos o más sustancias diferentes. Si las sustancias están a la misma temperatura y presión, no hay intercambio neto de calor o trabajo; el cambio de entropía se debe completamente a la mezcla de las diferentes sustancias. A nivel mecánico estadístico, esto se debe al cambio en el volumen disponible por partícula con la mezcla. [41]

Equivalencia de definiciones

Pruebas de equivalencia entre la definición de entropía en mecánica estadística (la fórmula de entropía de Gibbs ) y en termodinámica clásica (junto con la relación termodinámica fundamental ) son conocidos por el conjunto microcanónico , el conjunto canónico , el conjunto gran canónico y el conjunto isotérmico-isobárico . Estas pruebas se basan en la densidad de probabilidad de microestados de la distribución de Boltzmann generalizada y la identificación de la energía interna termodinámica como el promedio del conjunto.. [42] Las relaciones termodinámicas se emplean luego para derivar la conocida fórmula de entropía de Gibbs . Sin embargo, la equivalencia entre la fórmula de la entropía de Gibbs y la definición termodinámica de entropía no es una relación termodinámica fundamental sino más bien una consecuencia de la forma de la distribución de Boltzmann generalizada . [43]

Segunda ley de la termodinámica

La segunda ley de la termodinámica requiere que, en general, la entropía total de cualquier sistema no disminuya más que aumentando la entropía de algún otro sistema. Por tanto, en un sistema aislado de su entorno, la entropía de ese sistema tiende a no disminuir. De ello se deduce que el calor no puede fluir de un cuerpo más frío a un cuerpo más caliente sin la aplicación de trabajo al cuerpo más frío. En segundo lugar, es imposible que cualquier dispositivo que funcione en un ciclo produzca trabajo neto a partir de un depósito de temperatura única; la producción de trabajo neto requiere un flujo de calor de un depósito más caliente a un depósito más frío, o un único depósito en expansión sometido a enfriamiento adiabático , que realiza trabajo adiabático . Como resultado, no hay posibilidad demáquina de movimiento perpetuo . De ello se deduce que una reducción en el aumento de entropía en un proceso específico, como una reacción química , significa que es energéticamente más eficiente.

De la segunda ley de la termodinámica se deduce que la entropía de un sistema que no está aislado puede disminuir. Un acondicionador de aire , por ejemplo, puede enfriar el aire en una habitación, reduciendo así la entropía del aire de ese sistema. El calor expulsado de la habitación (el sistema), que el acondicionador de aire transporta y descarga al aire exterior, siempre hace una mayor contribución a la entropía del ambiente que la disminución de la entropía del aire de ese sistema. Así, el total de entropía de la habitación más la entropía del entorno aumenta, de acuerdo con la segunda ley de la termodinámica.

En mecánica, la segunda ley junto con la relación termodinámica fundamental pone límites a la capacidad de un sistema para realizar un trabajo útil . [44] El cambio de entropía de un sistema a temperatura absorbiendo una cantidad infinitesimal de calor de forma reversible, viene dada por . Más explícitamente, una energía no está disponible para realizar un trabajo útil, donde es la temperatura del depósito o disipador de calor accesible más frío externo al sistema. Para obtener más información, consulte Exergy .

La mecánica estadística demuestra que la entropía se rige por la probabilidad, lo que permite una disminución del desorden incluso en un sistema aislado. Aunque esto es posible, un evento de este tipo tiene una pequeña probabilidad de que ocurra, lo que lo hace poco probable. [45]

La aplicabilidad de una segunda ley de la termodinámica se limita a sistemas cercanos o en estado de equilibrio . [46] Al mismo tiempo, las leyes que gobiernan sistemas alejados del equilibrio siguen siendo discutibles. Uno de los principios rectores de tales sistemas es el principio de máxima producción de entropía. [47] [48] Afirma que los sistemas que no están en equilibrio evolucionan para maximizar su producción de entropía. [49] [50]

Aplicaciones

La relación termodinámica fundamental

La entropía de un sistema depende de su energía interna y de sus parámetros externos, como su volumen. En el límite termodinámico, este hecho conduce a una ecuación que relaciona el cambio en la energía internaa cambios en la entropía y los parámetros externos. Esta relación se conoce como la relación termodinámica fundamental . Si la presión externa soporta el volumen como único parámetro externo, esta relación es:

Dado que tanto la energía interna como la entropía son funciones monótonas de la temperatura , lo que implica que la energía interna es fija cuando se especifica la entropía y el volumen, esta relación es válida incluso si el cambio de un estado de equilibrio térmico a otro con entropía y volumen infinitesimalmente mayor ocurre de una manera no cuasiestática (por lo que durante este cambiar el sistema puede estar muy lejos del equilibrio térmico y entonces la entropía, la presión y la temperatura del sistema completo pueden no existir).

La relación termodinámica fundamental implica muchas identidades termodinámicas que son válidas en general, independientemente de los detalles microscópicos del sistema. Ejemplos importantes son las relaciones de Maxwell y las relaciones entre capacidades caloríficas .

Entropía en termodinámica química

La entropía termodinámica es fundamental en la termodinámica química , lo que permite cuantificar los cambios y predecir el resultado de las reacciones. La segunda ley de la termodinámica establece que la entropía en un sistema aislado , la combinación de un subsistema en estudio y su entorno, aumenta durante todos los procesos químicos y físicos espontáneos. La ecuación de Clausius de introduce la medición del cambio de entropía, . El cambio de entropía describe la dirección y cuantifica la magnitud de cambios simples, como la transferencia de calor entre sistemas, siempre de más caliente a más frío de forma espontánea.

Por tanto, la entropía termodinámica tiene la dimensión de la energía dividida por la temperatura y la unidad joule por kelvin (J / K) en el Sistema Internacional de Unidades (SI).

La entropía termodinámica es una propiedad extensa , lo que significa que escala con el tamaño o la extensión de un sistema. En muchos procesos es útil especificar la entropía como una propiedad intensiva independiente del tamaño, como una característica de entropía específica del tipo de sistema estudiado. La entropía específica se puede expresar en relación con una unidad de masa, típicamente el kilogramo (unidad: J⋅kg −1 ⋅K −1 ). Alternativamente, en química, también se hace referencia a un mol de sustancia, en cuyo caso se denomina entropía molar con una unidad de J⋅mol −1 ⋅K −1 .

Así, cuando un mol de sustancia aproximadamente 0 K es calentado por su entorno a298 K , la suma de los valores incrementales de constituyen la entropía molar estándar de cada elemento o compuesto, un indicador de la cantidad de energía almacenada por una sustancia en 298 K . [51] [52] El cambio de entropía también mide la mezcla de sustancias como una suma de sus cantidades relativas en la mezcla final. [53]

La entropía es igualmente esencial para predecir el alcance y la dirección de reacciones químicas complejas. Para tales aplicaciones, debe incorporarse en una expresión que incluya tanto al sistema como a su entorno, . Esta expresión se convierte, a través de algunos pasos, en la ecuación de energía libre de Gibbs para reactivos y productos en el sistema: [el cambio de energía libre de Gibbs del sistema] [el cambio de entalpía] [el cambio de entropía]. [51]

Capacidad tecnológica mundial para almacenar y comunicar información entrópica

Un estudio de 2011 en Science (revista) estimó la capacidad tecnológica mundial para almacenar y comunicar información comprimida de manera óptima normalizada sobre los algoritmos de compresión más efectivos disponibles en el año 2007, estimando así la entropía de las fuentes tecnológicamente disponibles. [54] La estimación del autor de que la capacidad tecnológica de la humanidad para almacenar información aumentó de 2,6 (comprimidos entrópicamente) exabytes en 1986 a 295 (comprimidos entrópicamente) exabytes en 2007. La capacidad tecnológica mundial para recibir información a través de redes de transmisión unidireccionales fue de 432 exabytes. de información (comprimida entrópicamente) en 1986, a 1,9 zettabytesen 2007. La capacidad efectiva mundial para intercambiar información a través de redes de telecomunicaciones bidireccionales fue de 281 petabytes de información (comprimida entrópicamente) en 1986, a 65 exabytes (comprimida entrópicamente) en 2007. [54]

Ecuación de equilibrio de entropía para sistemas abiertos

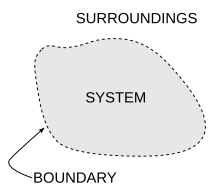

En ingeniería química , los principios de la termodinámica se aplican comúnmente a " sistemas abiertos ", es decir, aquellos en los que el calor, el trabajo y la masa fluyen a través de la frontera del sistema. Flujos de calor () y trabajo, es decir ( trabajo de eje ) y(trabajo de presión-volumen), a través de los límites del sistema, en general provocan cambios en la entropía del sistema. Transferencia como calor implica transferencia de entropía, donde es la temperatura termodinámica absoluta del sistema en el punto del flujo de calor. Si hay flujos de masa a través de los límites del sistema, también influyen en la entropía total del sistema. Esta cuenta, en términos de calor y trabajo, es válida solo para los casos en los que el trabajo y las transferencias de calor son por caminos físicamente distintos de los caminos de entrada y salida de la materia del sistema. [55] [56]

Para derivar una ecuación balanceada de entropía generalizada, comenzamos con la ecuación de balance general para el cambio en cualquier cantidad extensiva en un sistema termodinámico , una cantidad que puede conservarse, como la energía, o no conservarse, como la entropía. La expresión básica de equilibrio genérico establece que, es decir, la tasa de cambio de en el sistema, es igual a la tasa a la que entra en el sistema en los límites, menos la velocidad a la que deja el sistema a través de los límites del sistema, más la velocidad a la que se genera dentro del sistema. Para un sistema termodinámico abierto en el que el calor y el trabajo se transfieren por caminos separados de los caminos para la transferencia de materia, utilizando esta ecuación de equilibrio genérica, con respecto a la tasa de cambio con el tiempo. de la entropía de cantidad extensa , la ecuación del balance de entropía es: [57] [nota 1]

donde

- es la tasa neta de flujo de entropía debido a los flujos de masa dentro y fuera del sistema (donde es la entropía por unidad de masa).

- es la tasa de flujo de entropía debido al flujo de calor a través del límite del sistema.

- es la tasa de producción de entropía dentro del sistema. Esta producción de entropía surge de procesos dentro del sistema, incluidas reacciones químicas, difusión de materia interna, transferencia de calor interna y efectos de fricción como la viscosidad que se produce dentro del sistema a partir de la transferencia de trabajo mecánico hacia o desde el sistema.

Si hay varios flujos de calor, el término es reemplazado por donde es el flujo de calor y es la temperatura en el th puerto de flujo de calor en el sistema.

Fórmulas de cambio de entropía para procesos simples

Para ciertas transformaciones simples en sistemas de composición constante, los cambios de entropía vienen dados por fórmulas simples. [58]

Expansión o compresión isotérmica de un gas ideal

Para la expansión (o compresión) de un gas ideal a partir de un volumen inicial y presion a un volumen final y presion a cualquier temperatura constante, el cambio de entropía viene dado por:

Aquí es el número de moles de gas yes la constante del gas ideal . Estas ecuaciones también se aplican para la expansión en un vacío finito o un proceso de estrangulamiento , donde la temperatura, la energía interna y la entalpía de un gas ideal permanecen constantes.

Refrigeración y calefacción

Para calentar o enfriar cualquier sistema (gas, líquido o sólido) a presión constante desde una temperatura inicial a una temperatura final , el cambio de entropía es

siempre que la capacidad calorífica molar a presión constante (o calor específico) C P sea constante y que no se produzca ninguna transición de fase en este intervalo de temperatura.

De manera similar, a volumen constante, el cambio de entropía es

donde la capacidad calorífica molar de volumen constante C v es constante y no hay cambio de fase.

A bajas temperaturas cercanas al cero absoluto, la capacidad calorífica de los sólidos desciende rápidamente hasta casi cero, por lo que no se aplica el supuesto de capacidad calorífica constante. [59]

Dado que la entropía es una función de estado , el cambio de entropía de cualquier proceso en el que la temperatura y el volumen varían es el mismo que para una ruta dividida en dos pasos: calentamiento a volumen constante y expansión a temperatura constante. Para un gas ideal, el cambio de entropía total es [60]

De manera similar, si la temperatura y la presión de un gas ideal varían,

Transiciones de fase

Las transiciones de fase reversibles ocurren a temperatura y presión constantes. El calor reversible es el cambio de entalpía para la transición y el cambio de entropía es el cambio de entalpía dividido por la temperatura termodinámica. [61] Para la fusión ( fusión ) de un sólido a un líquido en el punto de fusión T m , la entropía de fusión es

De manera similar, para la vaporización de un líquido a gas en el punto de ebullición T b , la entropía de vaporización es

Enfoques para comprender la entropía

Como aspecto fundamental de la termodinámica y la física, son válidos varios enfoques diferentes de la entropía más allá de los de Clausius y Boltzmann.

Definiciones estándar de libros de texto

La siguiente es una lista de definiciones adicionales de entropía de una colección de libros de texto:

- una medida de dispersión de energía a una temperatura específica.

- una medida de desorden en el universo o de la disponibilidad de energía en un sistema para realizar un trabajo. [62]

- una medida de la energía térmica de un sistema por unidad de temperatura que no está disponible para realizar un trabajo útil . [63]

En la definición de Boltzmann, la entropía es una medida del número de posibles estados microscópicos (o microestados) de un sistema en equilibrio termodinámico. De acuerdo con la definición de Boltzmann, la segunda ley de la termodinámica debe redactarse nuevamente como tal que la entropía aumenta con el tiempo, aunque el principio subyacente sigue siendo el mismo.

Orden y desorden

La entropía a menudo se asocia vagamente con la cantidad de orden o desorden , o de caos , en un sistema termodinámico . La descripción cualitativa tradicional de la entropía es que se refiere a cambios en el status quo del sistema y es una medida de "desorden molecular" y la cantidad de energía desperdiciada en una transformación de energía dinámica de un estado o forma a otro. En esta dirección, varios autores recientes han derivado fórmulas de entropía exactas para explicar y medir el desorden y el orden en los ensamblajes atómicos y moleculares. [64] [65] [66] Una de las fórmulas de orden / desorden de entropía más simples es la derivada en 1984 por el físico termodinámico Peter Landsberg, basada en una combinación deargumentos de termodinámica y teoría de la información . Argumenta que cuando las restricciones operan en un sistema, de manera que se le impide entrar en uno o más de sus estados posibles o permitidos, en contraste con sus estados prohibidos, la medida de la cantidad total de "desorden" en el sistema está dada por : [65] [66]

De manera similar, la cantidad total de "pedido" en el sistema viene dada por:

Donde C D es la capacidad de "desorden" del sistema, que es la entropía de las partes contenidas en el conjunto permitido, C I es la capacidad de "información" del sistema, una expresión similar a la capacidad de canal de Shannon , y C O es la capacidad de "orden" del sistema. [64]

Dispersión de energía

El concepto de entropía se puede describir cualitativamente como una medida de la dispersión de energía a una temperatura específica. [67] Términos similares se han utilizado desde principios de la historia de la termodinámica clásica , y con el desarrollo de la termodinámica estadística y la teoría cuántica , los cambios de entropía se han descrito en términos de la mezcla o "propagación" de la energía total de cada constituyente. de un sistema sobre sus niveles de energía cuantificados particulares.

Las ambigüedades en los términos desorden y caos , que generalmente tienen significados directamente opuestos al equilibrio, contribuyen a una confusión generalizada y dificultan la comprensión de la entropía para la mayoría de los estudiantes. [68] Como muestra la segunda ley de la termodinámica , en un sistema aislado, las porciones internas a diferentes temperaturas tienden a ajustarse a una única temperatura uniforme y, por lo tanto, producen equilibrio. Un enfoque educativo desarrollado recientemente evita términos ambiguos y describe tal dispersión de energía como dispersión, que conduce a la pérdida de los diferenciales requeridos para el trabajo aunque la energía total permanece constante de acuerdo con la primera ley de la termodinámica [69].(compare la discusión en la siguiente sección). El químico físico Peter Atkins , en su libro de texto Physical Chemistry , introduce la entropía con la afirmación de que "los cambios espontáneos siempre van acompañados de una dispersión de energía". [70]

Relacionar la entropía con la utilidad energética

Siguiendo lo anterior, es posible (en un contexto térmico) considerar la entropía inferior como un indicador o medida de la eficacia o utilidad de una determinada cantidad de energía. [71] Esto se debe a que la energía suministrada a una temperatura más alta (es decir, con una entropía baja) tiende a ser más útil que la misma cantidad de energía disponible a una temperatura más baja. Mezclar un paquete caliente de un fluido con uno frío produce un paquete de temperatura intermedia, en el que el aumento general de entropía representa una "pérdida" que nunca puede ser reemplazada.

Por lo tanto, el hecho de que la entropía del universo aumente constantemente significa que su energía total se está volviendo menos útil: eventualmente, esto conduce a la " muerte térmica del Universo ". [72]

Entropía y accesibilidad adiabática

EHLieb y J. Yngvason en 1999 dieron una definición de entropía basada enteramente en la relación de accesibilidad adiabática entre estados de equilibrio . [73] Este enfoque tiene varios predecesores, incluido el trabajo pionero de Constantin Carathéodory de 1909 [74] y la monografía por R. Giles. [75] En el contexto de Lieb e Yngvason, uno comienza eligiendo, para una cantidad unitaria de la sustancia considerada, dos estados de referencia y de manera que el último sea adiabáticamente accesible desde el primero pero no al revés. Definir las entropías de los estados de referencia como 0 y 1, respectivamente, la entropía de un estado. se define como el número más grande tal que es adiabáticamente accesible desde un estado compuesto que consta de una cantidad en el estado y una cantidad complementaria, , en el estado . Un resultado simple pero importante dentro de esta configuración es que la entropía está determinada de manera única, además de una elección de unidad y una constante aditiva para cada elemento químico, por las siguientes propiedades: Es monótona con respecto a la relación de accesibilidad adiabática, aditivo sobre compuesto. sistemas, y extensivo bajo escalamiento.

Entropía en mecánica cuántica

En mecánica estadística cuántica , el concepto de entropía fue desarrollado por John von Neumann y generalmente se lo conoce como " entropía de von Neumann ",

donde ρ es la matriz de densidad y Tr es el operador de traza .

Esto sostiene el principio de correspondencia , porque en el límite clásico , cuando las fases entre los estados base usados para las probabilidades clásicas son puramente aleatorias, esta expresión es equivalente a la conocida definición clásica de entropía,

es decir, en tal base, la matriz de densidad es diagonal.

Von Neumann estableció un marco matemático riguroso para la mecánica cuántica con su trabajo Mathematische Grundlagen der Quantenmechanik . Proporcionó en este trabajo una teoría de la medición, donde la noción habitual de colapso de la función de onda se describe como un proceso irreversible (el llamado von Neumann o medición proyectiva). Usando este concepto, junto con la matriz de densidad , extendió el concepto clásico de entropía al dominio cuántico.

Teoría de la información

Conversación entre Claude Shannon y John von Neumann sobre qué nombre dar a la atenuación en las señales de las líneas telefónicas [76]

Cuando se ve en términos de teoría de la información , la función de estado de entropía es la cantidad de información en el sistema que se necesita para especificar completamente el microestado del sistema. La entropía es la medida de la cantidad de información que falta antes de la recepción. [77] A menudo llamada entropía de Shannon , fue ideada originalmente por Claude Shannon en 1948 para estudiar el tamaño de la información de un mensaje transmitido. La definición de entropía de la información se expresa en términos de un conjunto discreto de probabilidades. así que eso

En el caso de los mensajes transmitidos, estas probabilidades eran las probabilidades de que un mensaje en particular se transmitiera realmente, y la entropía del sistema de mensajes era una medida del tamaño promedio de información de un mensaje. Para el caso de probabilidades iguales (es decir, cada mensaje es igualmente probable), la entropía de Shannon (en bits) es solo el número de preguntas binarias necesarias para determinar el contenido del mensaje. [25]

La mayoría de los investigadores consideran que la entropía de la información y la entropía termodinámica están directamente vinculadas al mismo concepto, [78] [79] [80] [81] [82] mientras que otros argumentan que son distintas. [83] Ambas expresiones son matemáticamente similares. Sies el número de microestados que pueden producir un macroestado dado, y cada microestado tiene la misma probabilidad a priori , entonces esa probabilidad es. La entropía de Shannon (en nats ) es:

- y si la entropía se mide en unidades de per nat, entonces la entropía viene dada por:

que es la fórmula de la entropía de Boltzmann , dondees la constante de Boltzmann, que puede interpretarse como la entropía termodinámica per nat. Algunos autores abogan por eliminar la palabra entropía para elfunción de la teoría de la información y utilizando el otro término de Shannon, "incertidumbre", en su lugar. [84]

Medida

La entropía de una sustancia se puede medir, aunque de forma indirecta. La medición, conocida como entropimetría, [85] se realiza en un sistema cerrado (con el número de partículas N y el volumen V siendo constantes) y utiliza la definición de temperatura [86] en términos de entropía, mientras que limita el intercambio de energía al calor ().

La relación resultante describe cómo cambia la entropía. cuando una pequeña cantidad de energía se introduce en el sistema a una determinada temperatura .

El proceso de medición es el siguiente. Primero, una muestra de la sustancia se enfría lo más cerca posible del cero absoluto. A tales temperaturas, la entropía se acerca a cero, debido a la definición de temperatura. Luego, se introducen pequeñas cantidades de calor en la muestra y se registra el cambio de temperatura, hasta que la temperatura alcanza un valor deseado (generalmente 25 ° C). Los datos obtenidos permiten al usuario integrar la ecuación anterior, obteniendo el valor absoluto de entropía de la sustancia a la temperatura final. Este valor de entropía se llama entropía calorimétrica. [87]

Aplicaciones interdisciplinarias

Aunque el concepto de entropía era originalmente un concepto termodinámico, se ha adaptado a otros campos de estudio, incluida la teoría de la información , la psicodinámica , la termoeconomía / economía ecológica y la evolución . [64] [88] [89] [90] [91] Por ejemplo, se ha propuesto un argumento entrópico para explicar la preferencia de las arañas de las cavernas al elegir un área adecuada para poner sus huevos. [92] Con esta expansión de los campos / sistemas a los que se aplica la segunda ley de la termodinámica, el significado de la palabra entropía también se ha expandido y se basa en la energía impulsora de ese sistema.[93] El concepto divide los sistemas en tres categorías, naturales, híbridos y artificiales, basándose en la cantidad de control que los humanos tienen para frenar la implacable marcha de la entropía y la escala de tiempo de cada categoría para alcanzar la máxima entropía.

Lista de temas de entropía en termodinámica y mecánica estadística

- Unidad de entropía: una unidad de entropía termodinámica que no pertenece al SI, generalmente denominada "eu" e igual a una caloría por kelvin por mol, o 4,184 julios por kelvin por mol. [94]

- Entropía de Gibbs : la entropía mecánica estadística habitual de un sistema termodinámico.

- Entropía de Boltzmann : un tipo de entropía de Gibbs que ignora las correlaciones estadísticas internas en la distribución general de partículas.

- Entropía de Tsallis : una generalización de la entropía estándar de Boltzmann-Gibbs.

- Entropía molar estándar : es el contenido de entropía de un mol de sustancia, en condiciones de temperatura y presión estándar.

- Entropía residual : la entropía presente después de que una sustancia se enfría arbitrariamente cerca del cero absoluto .

- Entropía de mezcla : el cambio en la entropía cuando se mezclan dos sustancias o componentes químicos diferentes .

- Entropía de bucle : es la entropía que se pierde al juntar dos residuos de un polímero dentro de una distancia prescrita.

- Entropía conformacional : es la entropía asociada con la disposición física de una cadena de polímero que asume un estado compacto o globular en solución.

- Fuerza entrópica: fuerza microscópica o tendencia de reacción relacionada con cambios en la organización del sistema, consideraciones de fricción molecular y variaciones estadísticas.

- Entropía libre : un potencial termodinámico entrópico análogo a la energía libre.

- Explosión entrópica : una explosión en la que los reactivos experimentan un gran cambio de volumen sin liberar una gran cantidad de calor.

- Cambio de entropía: un cambio en la entropía dS entre dos estados de equilibrio viene dado por el calor transferido dQ rev dividido por la temperatura absoluta T del sistema en este intervalo.

- Entropía de Sackur-Tetrode : la entropía de un gas ideal clásico monoatómico determinada mediante consideraciones cuánticas.

Flecha del tiempo

La entropía es la única cantidad en las ciencias físicas que parece implicar una dirección particular de progreso, a veces llamada flecha del tiempo . A medida que pasa el tiempo, la segunda ley de la termodinámica establece que la entropía de un sistema aislado nunca disminuye en sistemas grandes durante períodos de tiempo significativos. Por lo tanto, desde esta perspectiva, la medición de la entropía se considera un reloj en estas condiciones.

Entropía de secuencias de ADN

Se ha demostrado que la entropía es útil en el análisis de secuencias de ADN. Se ha demostrado que muchas medidas basadas en la entropía distinguen entre diferentes regiones estructurales del genoma, diferencian entre regiones codificantes y no codificantes del ADN y también se pueden aplicar para la recreación de árboles evolutivos determinando la distancia evolutiva entre diferentes especies. [95]

Cosmología

Suponiendo que un universo finito es un sistema aislado, la segunda ley de la termodinámica establece que su entropía total aumenta continuamente. Se ha especulado, desde el siglo XIX, con que el universo está destinado a una muerte térmica en la que toda la energía termina como una distribución homogénea de energía térmica de modo que no se puede extraer más trabajo de ninguna fuente.

Si se puede considerar que el universo tiene una entropía generalmente creciente, entonces, como ha señalado Roger Penrose , la gravedad juega un papel importante en el aumento porque la gravedad hace que la materia dispersa se acumule en estrellas, que finalmente colapsarán en agujeros negros . La entropía de un agujero negro es proporcional al área de la superficie del horizonte de eventos del agujero negro . [96] [97] [98] Jacob Bekenstein y Stephen Hawkinghan demostrado que los agujeros negros tienen la máxima entropía posible de cualquier objeto de igual tamaño. Esto los convierte en puntos finales probables de todos los procesos de aumento de entropía, si son trampas de materia y energía totalmente efectivas. [99] Sin embargo, el escape de energía de los agujeros negros podría ser posible debido a la actividad cuántica (ver radiación de Hawking ).

El papel de la entropía en la cosmología sigue siendo un tema controvertido desde la época de Ludwig Boltzmann . Trabajos recientes han arrojado algunas dudas sobre la hipótesis de la muerte por calor y la aplicabilidad de cualquier modelo termodinámico simple al universo en general. Aunque la entropía aumenta en el modelo de un universo en expansión, la máxima entropía posible aumenta mucho más rápidamente, alejando al universo de la muerte por calor con el tiempo, no más cerca. [100] [101] [102] Esto da como resultado una "brecha de entropía" que empuja al sistema más lejos del equilibrio de muerte por calor postulado. [103] Otros factores que complican, como la densidad de energía del vacío y el cuántico macroscópicoefectos, son difíciles de conciliar con los modelos termodinámicos, lo que hace que cualquier predicción de la termodinámica a gran escala sea extremadamente difícil. [104]

Las teorías actuales sugieren que la brecha de entropía se abrió originalmente por la rápida expansión exponencial temprana del universo. [105]

Economía

El economista rumano-estadounidense Nicholas Georgescu-Roegen , progenitor de la economía y fundador paradigmático de la economía ecológica , hizo un amplio uso del concepto de entropía en su obra magna sobre La ley de la entropía y el proceso económico . [79] Debido al trabajo de Georgescu-Roegen, las leyes de la termodinámica forman ahora una parte integral de la escuela de economía ecológica . [106] : 204f [107] : 29–35 Aunque su trabajo estaba algo manchado por errores, se ha incluido con aprobación un capítulo completo sobre la economía de Georgescu-Roegen en un libro de texto de física elemental sobre el desarrollo histórico de la termodinámica. [108] : 95–112

En economía, el trabajo de Georgescu-Roegen ha generado el término "pesimismo de la entropía" . [109] : 116 Desde la década de 1990, el destacado economista ecológico y teórico del estado estacionario Herman Daly , un estudiante de Georgescu-Roegen, ha sido el defensor más influyente de la profesión económica de la posición del pesimismo de la entropía. [110] : 545f [111]

Hermenéutica

En Hermenéutica , Arianna Béatrice Fabbricatore ha utilizado el término entropía, apoyándose en las obras de Umberto Eco, [112] para identificar y evaluar la pérdida de significado entre la descripción verbal de la danza y el coreotexto (la seda en movimiento que utiliza el bailarín para representar la escritura coreográfica) [113] generada por operaciones de traducción inter-semiótica. [114] [115]

Este uso está vinculado a las nociones de logotexto y coreotexto. En la transición del logotexto al coreotexto es posible identificar dos tipologías de entropía: la primera, denominada "natural", se relaciona con la unicidad del acto performativo y su carácter efímero. El segundo está provocado por "vacíos" más o menos importantes en el logotexto ( es decir, el texto verbal que refleja la acción bailada [116] ).

Ver también

- Reacciones autocatalíticas y creación de pedidos

- Trinquete browniano

- Desigualdad de Clausius-Duhem

- Entropía de configuración

- Función de salida

- Entalpía

- Fuerza entrópica

- Valor entrópico en riesgo

- Entropía (teoría de la información)

- Entropía (computación)

- Entropía (termodinámica estadística)

- Entropía y vida

- Entropía (orden y desorden)

- Tasa de entropía

- Producción de entropía

- Extropía

- Frustración geométrica

- Entropía armónica

- Muerte por calor del universo

- Métricas de información

- Leyes de la termodinámica

- Función de multiplicidad

- Negentropía (entropía negativa)

- Órdenes de magnitud (entropía)

- Espacio de fase

- Principio de máxima entropía

- Fórmula de Stirling

- Bases de datos termodinámicas para sustancias puras

- Potencial termodinámico

- Equilibrio termodinámico

Notas

- ^ Los sobrepuntos representan derivadas de las cantidades con respecto al tiempo.

Referencias

- ^ Wehrl, Alfred (1 de abril de 1978). "Propiedades generales de la entropía" . Reseñas de Física Moderna . 50 (2): 221–260. doi : 10.1103 / RevModPhys.50.221 .

- ^ Truesdell, C. (1980). La historia tragicómica de la termodinámica 1822–1854 , Springer, Nueva York, ISBN 0-387-90403-4 , página 215.

- ^ Pincel, SG (1976). El tipo de movimiento que llamamos calor: una historia de la teoría cinética de los gases en el siglo XIX, Libro 2, Física estadística y procesos irreversibles , Elsevier, Amsterdam, ISBN 0-444-87009-1 , págs. 576–577.

- ^ Arieh Ben-Naim, Adiós a la entropía: termodinámica estadística basada en información , World-Scientific Publishing Co., Singapur, 2008, ISBN 978-981-270-706-2

- ^ "Carnot, Sadi (1796-1832)" . Wolfram Research. 2007 . Consultado el 24 de febrero de 2010 .

- ^ McCulloch, Richard, S. (1876). Tratado sobre la teoría mecánica del calor y sus aplicaciones a la máquina de vapor, etc . D. Van Nostrand.

- ↑ a b Clausius, Rudolf (1850). "Über die bewegende Kraft der Wärme und die Gesetze, welche sich daraus für die Wärmelehre selbst ableiten lassen". Annalen der Physik . 155 (3): 368–397. Código Bibliográfico : 1850AnP ... 155..368C . doi : 10.1002 / yp.18501550306 . hdl : 2027 / uc1. $ b242250 .[Sobre la fuerza motriz del calor y las leyes que se pueden deducir de él para la teoría del calor]: Annalen der Physik und Chemie de Poggendorff

- ↑ Liddell, HG, Scott, R. (1843/1978). A Greek-English Lexicon, edición revisada y aumentada, Oxford University Press, Oxford Reino Unido, ISBN 0198642148 , págs. 1826–1827.

- ↑ a b Clausius, Rudolf (1865). "Ueber verschiedene für die Anwendung bequeme Formen der Hauptgleichungen der mechanischen Wärmetheorie (Vorgetragen in der naturforsch. Gesellschaft zu Zürich den 24. Abril 1865)" . Annalen der Physik und Chemie . 125 (7): 353–400. Código Bibliográfico : 1865AnP ... 201..353C . doi : 10.1002 / yp.18652010702 ."Sucht man für S einen bezeichnenden Namen, so könnte man, ähnlich wie von der Gröſse U gesagt ist, sie sey der Wärme- und Werkinhalt des Körpers, von der Gröſse S sagen, sie sey der Verwandlungsinhalt des Körpers f. Besser halte, morir Namen derartiger für die Wissenschaft wichtiger Grössen aus den alten Sprachen zu entnehmen, damit sie unverändert en allen neuen Sprachen angewandt werden können, por lo Schlage ich vor, die Grosse S nach dem griechischen Worte ἡ τροπή, morir Verwandlung, morir Entropie des Körpers zu nennen. Das Wort Entropie habei ich absichtlich dem Worte Energie möglichst ähnlich gebildet, denn die beiden Gröſsen, welche durch diese Worte benannt werden sollen, sind ihren physikalischen Bedeutungen nach einander so nahe verwandt, daſs eine gewisse Gleichartigkeit in der Benennä mirig zweck. 390.

- ↑ a b Gillispie, Charles Coulston (1960). El borde de la objetividad: un ensayo en la historia de las ideas científicas . Prensa de la Universidad de Princeton. pag. 399 . ISBN 0-691-02350-6. "Clausius acuñó la palabra entropía para : ″ Prefiero acudir a las lenguas antiguas en busca de nombres de cantidades científicas importantes, para que puedan significar lo mismo en todas las lenguas vivas. Propongo, en consecuencia, llamarla entropía de un cuerpo, después de la palabra griega "transformación". He acuñado deliberadamente la palabra entropía para que sea similar a 'energía', ya que estas dos cantidades son tan análogas en su significado físico, que una analogía de denominación me pareció útil ″ ".

- ^ Los artículos científicos de J. Willard Gibbs en dos volúmenes . 1 . Longmans, Green y Co. 1906. p. 11 . Consultado el 26 de febrero de 2011 .

- ^ JA McGovern, "Entropía 2.5" . Archivado desde el original el 23 de septiembre de 2012 . Consultado el 5 de febrero de 2013 .

- ^ "6.5 irreversibilidad, cambios de entropía y trabajo perdido " . web.mit.edu . Consultado el 21 de mayo de 2016 .

- ^ Más bajo, Stephen. "¿Qué es la entropía?" . www.chem1.com . Consultado el 21 de mayo de 2016 .

- ^ Lavenda, Bernard H. (2010). "2.3.4". Una nueva perspectiva sobre la termodinámica (Online-Ausg. Ed.). Nueva York: Springer. ISBN 978-1-4419-1430-9.

- ^ Carnot, Sadi Carnot (1986). Fox, Robert (ed.). Reflexiones sobre la fuerza motriz del fuego . Nueva York: Lilian Barber Press. págs. 26 . ISBN 978-0-936508-16-0.

- ^ Truesdell, C. (1980). La tragicómica historia de la termodinámica 1822-1854 . Nueva York: Springer. págs. 78 –85. ISBN 978-0-387-90403-0.

- ^ Secretario Maxwel, James (2001). Pesic, Peter (ed.). Teoría del calor . Mineola: Publicaciones de Dover. págs. 115-158. ISBN 978-0-486-41735-6.

- ^ Rudolf Clausius (1867). La teoría mecánica del calor: con sus aplicaciones a la máquina de vapor y a las propiedades físicas de los cuerpos . J. Van Voorst. pag. 28. ISBN 978-1-4981-6733-8.

- ^ Atkins, Peter; Julio De Paula (2006). Química física, 8ª ed . Prensa de la Universidad de Oxford. pag. 79. ISBN 978-0-19-870072-2.

- ^ Engel, Thomas; Philip Reid (2006). Química Física . Pearson Benjamin Cummings. pag. 86. ISBN 978-0-8053-3842-3.

- ↑ a b c Licker, Mark D. (2004). Enciclopedia de química concisa de McGraw-Hill . Nueva York: McGraw-Hill Professional. ISBN 978-0-07-143953-4.

- ↑ a b Sethna, James P. (2006). Mecánica estadística: entropía, parámetros de orden y complejidad ([Online-Ausg.] Ed.). Oxford: Prensa de la Universidad de Oxford. pag. 78 . ISBN 978-0-19-856677-9.

- ^ Clark, John OE (2004). El diccionario esencial de la ciencia . Nueva York: Barnes & Noble. ISBN 978-0-7607-4616-5.

- ^ a b Frigg, R. y Werndl, C. "Entropía: una guía para los perplejos" . En Probabilidades en Física ; Beisbart C. y Hartmann, S. Eds; Prensa de la Universidad de Oxford, Oxford, 2010

- ^ Schroeder, Daniel V. (2000). Introducción a la física térmica . San Francisco, CA: Addison Wesley. pag. 57 . ISBN 978-0-201-38027-9.

- ^ Allen, Michael P .; Tildesley, Dominic J. (23 de noviembre de 2017). "Simulación por computadora de líquidos". Beca de Oxford en línea . doi : 10.1093 / oso / 9780198803195.001.0001 . ISBN 9780198803195.

- ^ Rosenfeld, Yaakov (1 de junio de 1977). "Relación entre los coeficientes de transporte y la entropía interna de sistemas simples". Physical Review A . 15 (6): 2545–2549. Código Bibliográfico : 1977PhRvA..15.2545R . doi : 10.1103 / PhysRevA.15.2545 . ISSN 0556-2791 .

- ^ Dyre, Jeppe C. (2018). "Perspectiva: escala de exceso de entropía" . La Revista de Física Química . 149 (21): 210901. doi : 10.1063 / 1.5055064 . ISSN 0021-9606 . PMID 30525736 .

- ↑ Bell, Ian H. (2019). "Probar el vínculo entre la entropía residual y la viscosidad de los fluidos moleculares y los potenciales del modelo" . Actas de la Academia Nacional de Ciencias . 116 (10): 4070–4079. doi : 10.1073 / pnas.1815943116 . ISSN 0027-8424 . PMC 6410835 . PMID 30770449 .

- ^ Bell, Ian H .; Dyre, Jeppe C .; Ingebrigtsen, Trond S. (2020). "Exceso de escala de entropía en mezclas binarias superenfriadas" . Comunicaciones de la naturaleza . 11 (1): 4300. doi : 10.1038 / s41467-020-17948-1 . ISSN 2041-1723 . PMC 7453028 . PMID 32855393 .

- ^ "EntropyOrderParametersComplexity.pdf www.physics.cornell.edu" (PDF) . Consultado el 17 de agosto de 2012 .

- ^ Jaynes, ET (1 de mayo de 1965). "Gibbs vs Entropías de Boltzmann" . Revista estadounidense de física . 33 (5): 391–398. doi : 10.1119 / 1.1971557 . ISSN 0002-9505 .

- ^ Jaynes, ET (1992). Smith, CR; Erickson, GJ; Neudorfer, PO (eds.).'La paradoja de Gibbs,' [en] Máxima entropía y métodos bayesianos (PDF) . Académico Kluwer: Dordrecht. págs. 1–22 . Consultado el 17 de agosto de 2012 .

- ↑ a b Sandler, Stanley I. (2006). Termodinámica química, bioquímica y de ingeniería (4ª ed.). Nueva York: John Wiley & Sons. pag. 91 . ISBN 978-0-471-66174-0.

- ^ Simon, Donald A. McQuarrie; John D. (1997). Química física: un enfoque molecular (Rev. ed.). Sausalito, California: Univ. Libros de ciencia. pag. 817. ISBN 978-0-935702-99-6.

- ^ Haynie, Donald, T. (2001). Termodinámica biológica . Prensa de la Universidad de Cambridge . ISBN 978-0-521-79165-6.

- ^ Daintith, John (2005). Un diccionario de ciencia (5ª ed.). Oxford: Prensa de la Universidad de Oxford. ISBN 978-0-19-280641-3.

- ↑ de Rosnay, Joel (1979). El macroscopio: una nueva visión del mundo (escrito por un bioquímico formado en el MIT) . Harper & Row, editores. ISBN 978-0-06-011029-1.

- ^ McGovern, JA "Capacidades térmicas" . Archivado desde el original el 19 de agosto de 2012 . Consultado el 27 de enero de 2013 .

- ^ Ben-Naim, Arieh (21 de septiembre de 2007). "Sobre la llamada paradoja de Gibbs y sobre la paradoja real" (PDF) . Entropía . 9 (3): 132-136. Código Bibliográfico : 2007Entrp ... 9..132B . doi : 10.3390 / e9030133 .

- ^ Callen, Herbert (2001). Termodinámica e Introducción a la Termostatística (2ª ed.) . John Wiley e hijos. ISBN 978-0-471-86256-7.

- ^ Gao, Xiang; Gallicchio, Emilio; Roitberg, Adrian (2019). "La distribución de Boltzmann generalizada es la única distribución en la que la entropía de Gibbs-Shannon es igual a la entropía termodinámica". La Revista de Física Química . 151 (3): 034113. arXiv : 1903.02121 . Código bibliográfico : 2019JChPh.151c4113G . doi : 10.1063 / 1.5111333 . PMID 31325924 . S2CID 118981017 .

- ^ Daintith, John (2005). Diccionario Oxford de Física . Prensa de la Universidad de Oxford. ISBN 978-0-19-280628-4.

- ^ Saha, Arnab; Lahiri, Sourabh; Jayannavar, AM (2009). "Teoremas de producción de entropía y algunas consecuencias". Revisión E física . 80 (1): 1–10. arXiv : 0903.4147 . Código Bibliográfico : 2009PhRvE..80a1117S . doi : 10.1103 / PhysRevE.80.011117 . PMID 19658663 . S2CID 22204063 .

- ^ Martyushev, LM; Seleznev, VD (2014). "Las restricciones del principio de máxima producción de entropía". Physica A: Mecánica estadística y sus aplicaciones . 410 : 17-21. arXiv : 1311.2068 . Código bibliográfico : 2014PhyA..410 ... 17M . doi : 10.1016 / j.physa.2014.05.014 . S2CID 119224112 .

- ^ Ziegler, H. (1983). Introducción a la termomecánica . Holanda Septentrional, Amsterdam.

- ^ Onsager, Lars (1931). "Relaciones recíprocas en procesos irreversibles" . Phys. Rev . 37 (4): 405. Bibcode : 1931PhRv ... 37..405O . doi : 10.1103 / PhysRev.37.405 .

- ^ Kleidon, A .; et., al. (2005). Termodinámica del desequilibrio y producción de entropía . Heidelberg: Springer.

- ^ Belkin, Andrey; et., al. (2015). "Nanoestructuras ondulantes autoensambladas y el principio de máxima producción de entropía" . Informes científicos . 5 : 8323. Código Bibliográfico : 2015NatSR ... 5E8323B . doi : 10.1038 / srep08323 . PMC 4321171 . PMID 25662746 .

- ^ a b Moore, JW; CL Stanistski; PC Jurs (2005). Química, la ciencia molecular . Brooks Cole. ISBN 978-0-534-42201-1.

- ^ Jungermann, AH (2006). "La entropía y el modelo de estante: un enfoque físico cuántico de una propiedad física". Revista de educación química . 83 (11): 1686–1694. Código Bibliográfico : 2006JChEd..83.1686J . doi : 10.1021 / ed083p1686 . S2CID 18081336 .

- ^ Levine, IN (2002). Química física, 5ª ed . McGraw-Hill. ISBN 978-0-07-231808-1.

- ^ a b "La capacidad tecnológica del mundo para almacenar, comunicar y computar información" , Martin Hilbert y Priscila López (2011), Science (revista) , 332 (6025), 60–65; acceso gratuito al artículo a través de aquí: martinhilbert.net/WorldInfoCapacity.html

- ^ Último premio Nobel Max Born (8 de agosto de 2015). Filosofía natural de la causa y el azar . BiblioLife. págs. 44, 146-147. ISBN 978-1-298-49740-6.

- ^ Haase, R. (1971). Termodinámica . Nueva York: Academic Press. págs. 1-97. ISBN 978-0-12-245601-5.

- ^ Sandler, Stanley, I. (1989). Termodinámica Química e Ingeniería . John Wiley e hijos. ISBN 978-0-471-83050-4.

- ^ "GRC.nasa.gov" . GRC.nasa.gov. 27 de marzo de 2000. Archivado desde el original el 21 de agosto de 2011 . Consultado el 17 de agosto de 2012 .

- ^ Franzen, Stefan. "Tercera Ley" (PDF) . ncsu.edu. Archivado desde el original (PDF) el 9 de julio de 2017.

- ^ "GRC.nasa.gov" . GRC.nasa.gov. 11 de julio de 2008 . Consultado el 17 de agosto de 2012 .

- ^ Starzak, Michael E. (2010). "Equilibrios de fase y propiedades coligativas" . Energía y entropía: equilibrio a estados estacionarios . Springer Science + Business Media. págs. 138–140. ISBN 978-1489983671. Consultado el 5 de septiembre de 2019 .

- ^ Gribbin, John (1999). Gribbin, Mary (ed.). Q es cuántica: una enciclopedia de física de partículas . Nueva York: Free Press. ISBN 978-0-684-85578-3.

- ^ "Entropía: definición y ecuación" . Encyclopædia Britannica . Consultado el 22 de mayo de 2016 .

- ^ a b c Brooks, Daniel R .; Wiley, EO (1988). Evolución como entropía: hacia una teoría unificada de la biología (2ª ed.). Chicago [etc.]: University of Chicago Press. ISBN 978-0-226-07574-7.

- ↑ a b Landsberg, PT (1984). "¿El equilibrio es siempre un máximo de entropía?". J. Stat. Física . 35 (1–2): 159–169. Código bibliográfico : 1984JSP .... 35..159L . doi : 10.1007 / bf01017372 . S2CID 122424225 .

- ↑ a b Landsberg, PT (1984). "¿Pueden la entropía y el" orden "aumentar juntos?". Letras de física . 102A (4): 171-173. Código bibliográfico : 1984PhLA..102..171L . doi : 10.1016 / 0375-9601 (84) 90934-4 .

- ^ Lambert, Frank L. "Aproximación de un estudiante a la segunda ley y la entropía" . entropysite.oxy.edu . Archivado desde el original el 17 de julio de 2009 . Consultado el 22 de mayo de 2016 .

- ^ Watson, JR; Carson, EM (mayo de 2002). "Comprensión de los estudiantes de pregrado de la entropía y la energía libre de Gibbs" (PDF) . Educación Universitaria en Química . 6 (1): 4. ISSN 1369-5614 .

- ^ Lambert, Frank L. (febrero de 2002). "Trastorno: una muleta rota para apoyar las discusiones de entropía". Revista de educación química . 79 (2): 187. Código bibliográfico : 2002JChEd..79..187L . doi : 10.1021 / ed079p187 . S2CID 97102995 .

- ^ Peter Atkins; Julio de Paula; James Keeler (2019). Química física de Atkins 11e: Volumen 3: Termodinámica y cinética molecular . Prensa de la Universidad de Oxford. pag. 89. ISBN 978-0-19-882336-0.

- ^ Sandra Saary (23 de febrero de 1993). "Reseña de libro de" A Science Miscellany " " . Tiempos de Khaleej . Emiratos Árabes Unidos: Galadari Press: xi.

- ^ Lathia, R; Agrawal, T; Parmar, V; Dobariya, K; Patel, A (20 de octubre de 2015). "Muerte por calor (el destino final del universo)". doi : 10.13140 / rg.2.1.4158.2485 . Cite journal requires

|journal=(help) - ^ Lieb, Elliott H .; Yngvason, Jakob (marzo de 1999). "La física y las matemáticas de la segunda ley de la termodinámica". Informes de física . 310 (1): 1–96. arXiv : cond-mat / 9708200 . Código Bibliográfico : 1999PhR ... 310 .... 1L . doi : 10.1016 / S0370-1573 (98) 00082-9 . S2CID 119620408 .

- ^ Carathéodory, C. (septiembre de 1909). "Untersuchungen über die Grundlagen der Thermodynamik" . Mathematische Annalen (en alemán). 67 (3): 355–386. doi : 10.1007 / BF01450409 . S2CID 118230148 .

- ^ R. Giles (2016). Fundamentos matemáticos de la termodinámica: Serie internacional de monografías sobre matemáticas puras y aplicadas . Ciencia de Elsevier. ISBN 978-1-4831-8491-3.

- ^ Tribus, M .; McIrvine, CE (1971). "Energía e información". Scientific American . 224 : 178-184.

- ^ Balian, Roger (2004). "Entropía, un concepto proteico". En Dalibard, Jean (ed.). Seminario de Poincaré 2003: Condensación de Bose-Einstein - entropía . Basilea: Birkhäuser. págs. 119-144. ISBN 978-3-7643-7116-6.

- ^ Brillouin, León (1956). Teoría de la ciencia y la información . ISBN 978-0-486-43918-1.

- ↑ a b Georgescu-Roegen, Nicholas (1971). La ley de la entropía y el proceso económico . Prensa de la Universidad de Harvard. ISBN 978-0-674-25781-8.

- ^ Chen, Jing (2005). La base física de la economía: una teoría termodinámica analítica . World Scientific. ISBN 978-981-256-323-1.

- ^ Kalinin, MI; Kononogov, SA (2005). "Constante de Boltzmann". Técnicas de medición . 48 (7): 632–636. doi : 10.1007 / s11018-005-0195-9 . S2CID 118726162 .