Teoría de probabilidad

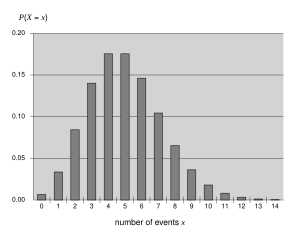

La teoría de la probabilidad es la rama de las matemáticas que se ocupa de la probabilidad . Aunque hay varias interpretaciones de probabilidad diferentes, la teoría de la probabilidad trata el concepto de una manera matemática rigurosa al expresarlo a través de un conjunto de axiomas . Por lo general, estos axiomas formalizan la probabilidad en términos de un espacio de probabilidad , que asigna una medida que toma valores entre 0 y 1, denominada medida de probabilidad , a un conjunto de resultados denominado espacio muestral . Cualquier subconjunto especificado del espacio muestral se denomina evento . Los temas centrales en la teoría de la probabilidad incluyen discretos y continuos.variables aleatorias , distribuciones de probabilidad y procesos estocásticos , que proporcionan abstracciones matemáticas de procesos no deterministas o inciertos o cantidades medidas que pueden ser ocurrencias únicas o evolucionar con el tiempo de manera aleatoria. Aunque no es posible predecir perfectamente eventos aleatorios, se puede decir mucho sobre su comportamiento. Dos resultados importantes en la teoría de la probabilidad que describen tal comportamiento son la ley de los grandes números y el teorema del límite central .

Como base matemática para las estadísticas , la teoría de la probabilidad es esencial para muchas actividades humanas que involucran el análisis cuantitativo de datos. [1] Los métodos de la teoría de la probabilidad también se aplican a las descripciones de sistemas complejos dado solo un conocimiento parcial de su estado, como en la mecánica estadística o la estimación secuencial . Un gran descubrimiento de la física del siglo XX fue la naturaleza probabilística de los fenómenos físicos a escala atómica, descritos en la mecánica cuántica . [2] [ fuente poco fiable? ]

La teoría matemática moderna de la probabilidad tiene sus raíces en los intentos de analizar los juegos de azar de Gerolamo Cardano en el siglo XVI y de Pierre de Fermat y Blaise Pascal en el siglo XVII (por ejemplo, el " problema de los puntos "). [3] Christiaan Huygens publicó un libro sobre el tema en 1657 [4] y en el siglo XIX, Pierre Laplace completó lo que hoy se considera la interpretación clásica. [5]

Inicialmente, la teoría de la probabilidad consideraba principalmente eventos discretos y sus métodos eran principalmente combinatorios . Eventualmente, las consideraciones analíticas obligaron a la incorporación de variables continuas en la teoría.

Esto culminó en la teoría de la probabilidad moderna, sobre los cimientos establecidos por Andrey Nikolaevich Kolmogorov . Kolmogorov combinó la noción de espacio muestral , introducida por Richard von Mises , y la teoría de la medida y presentó su sistema de axiomas para la teoría de la probabilidad en 1933. Esto se convirtió en la base axiomática mayoritariamente indiscutible de la teoría de la probabilidad moderna; pero existen alternativas, como la adopción de aditividad finita en lugar de numerable por Bruno de Finetti . [6]

La mayoría de las introducciones a la teoría de la probabilidad tratan las distribuciones de probabilidad discretas y las distribuciones de probabilidad continuas por separado. El tratamiento de la probabilidad basado en la teoría de la medida cubre lo discreto, lo continuo, una combinación de los dos y más.